Ebben az internetkorszakban terabájt és petabájtnyi adat létezik, ugyanakkor exponenciális növekedés mellett. De hogyan használjuk fel ezeket az adatokat, és fordítsuk le hasznos információkká a szolgáltatások elérhetőségének javítása érdekében?

Érvényes, újszerű és érthető adatokra van szükségük a vállalkozásoknak tudásfeltárási modelljeikhez.

Emiatt a vállalkozások sokféle módon alkalmazzák az elemzést a minőségi adatok feltárására.

De hol kezdődik minden? A válasz adatcsavarás.

Kezdjük el!

Tartalomjegyzék

Mi az az adatvesztés?

Az adatviszály a nyers adatok tisztítása, strukturálása és formátumokká alakítása, amelyek leegyszerűsítik az adatelemzési folyamatokat. Az adatviszály gyakran azt jelenti, hogy olyan rendetlen és összetett adatkészletekkel kell dolgozni, amelyek nem állnak készen az adatfolyam-folyamatokra. Az adatvesztés a nyers adatokat finomított állapotba, a finomított adatokat pedig optimalizált állapotba és gyártásra kész szintre helyezi át.

Néhány ismert feladat az adatcsavarásban:

- Több adatkészlet összevonása egyetlen nagy adatkészletbe elemzés céljából.

- Hiányzó/hiányos adatok vizsgálata.

- Kiugró értékek vagy anomáliák eltávolítása az adatkészletekből.

- A bemenetek szabványosítása.

Az adatrögzítési folyamatokban részt vevő nagy adattárak általában túlmutatnak a kézi hangoláson, ezért automatizált adat-előkészítési módszerekre van szükség a pontosabb és minőségibb adatok előállításához.

Az adatvesztés céljai

Az adatok elemzésre való előkészítése, mint nagyobb cél, további célok közé tartoznak:

- Érvényes és újszerű adatok létrehozása zavaros adatokból a vállalkozások döntéshozatalának elősegítésére.

- A nyers adatok szabványosítása olyan formátumokká, amelyeket a Big Data rendszerek képesek feldolgozni.

- Az adatelemzők által az adatmodellek létrehozására fordított idő csökkentése rendezett adatok bemutatásával.

- Konzisztencia, teljesség, használhatóság és biztonság megteremtése bármely felhasznált vagy adattárházban tárolt adatkészlethez.

Az adatválás általános megközelítései

Felfedezés

Mielőtt az adatmérnökök elkezdenék az adat-előkészítési feladatokat, meg kell érteniük, hogyan tárolják azokat, milyen méretben, milyen rekordokat vezetnek, milyen kódolási formátumokat és más, bármely adatkészletet leíró attribútumot.

Strukturálás

Ez a folyamat magában foglalja az adatok rendszerezését, hogy könnyen használható formátumba kerüljön. A nyers adatkészleteknél szükség lehet az oszlopok megjelenésének, a sorok számának strukturálására, valamint más adatattribútumok hangolására az elemzés egyszerűsítése érdekében.

Tisztítás

A strukturált adatkészleteket meg kell szabadítani a benne rejlő hibáktól és mindentől, ami torzíthatja az adatokat. A tisztítás tehát magában foglalja több, hasonló adatokat tartalmazó cellabejegyzés eltávolítását, az üres cellák és a kiugró adatok törlését, a bemenetek szabványosítását, a zavaró attribútumok átnevezését stb.

Gazdagítás

Miután az adatok átmentek a strukturálási és tisztítási szakaszon, fel kell mérni az adatok hasznosságát, és ki kell egészíteni más olyan adatkészletekből származó értékekkel, amelyek hiányoznak a kívánt adatminőség biztosításához.

Érvényesítés

Az érvényesítési folyamat iteratív programozási szempontokat foglal magában, amelyek megvilágítják az adatok minőségét, konzisztenciáját, használhatóságát és biztonságát. Az érvényesítési szakasz biztosítja, hogy az összes átalakítási feladat megvalósuljon, és az adatkészleteket készen áll az elemzési és modellezési fázisokra.

Bemutatás

Az összes szakasz lejárta után a megzavart adatkészleteket bemutatják/megosztják egy szervezeten belül elemzés céljából. Ebben a szakaszban megosztják az előkészítési lépések és a vitás folyamat során keletkező metaadatok dokumentálását is.

Talend

Talend egy egységes adatkezelési platform 3 adatszövetbe csomagolva, hogy megbízható és egészséges adatokat biztosítson. A Talend bemutatja az adatintegrációt, az alkalmazásokat és integrációt, valamint az adatintegritást és irányítást. Az adatviszály a Talendben egy böngészőalapú point and click eszközön keresztül történik, amely lehetővé teszi a kötegelt, tömeges és élő adatok előkészítését – adatprofilozást, tisztítást és dokumentálást.

A Talend data fabric az adatok életciklusának minden szakaszát kezeli, gondosan egyensúlyozva az adatok elérhetőségét, használhatóságát, biztonságát és integritását minden üzleti adat között.

Aggódtál valaha a sokféle adatforrás miatt? A Talend egységes megközelítése gyors adatintegrációt biztosít az összes adatforrásból (adatbázisok, felhőtárolók és API-végpontok) – lehetővé téve az összes adat átalakítását és leképezését zökkenőmentes minőségellenőrzéssel.

Az adatintegráció a Talendben olyan önkiszolgáló eszközökön keresztül lehetséges, mint például a csatlakozók, amelyek lehetővé teszik a fejlesztők számára, hogy bármilyen forrásból automatikusan feldolgozzák az adatokat, és megfelelően kategorizálják az adatokat.

A Talend jellemzői

Univerzális adatintegráció

A Talend lehetővé teszi a vállalkozások számára, hogy különféle adatforrásokból – felhőből vagy On-prem környezetből – bármilyen adattípust megvitassanak.

Rugalmas

A Talend túlmutat a szállítókon vagy a platformokon, amikor adatfolyamokat épít ki az integrált adatokból. Miután létrehozta a feldolgozott adatokból adatfolyamokat, a Talend lehetővé teszi a folyamatok bárhol futtatását.

Adat minőség

Az olyan gépi tanulási képességekkel, mint az adatok deduplikációja, érvényesítése és szabványosítása, a Talend automatikusan megtisztítja a bevitt adatokat.

Alkalmazás- és API-integrációk támogatása

Miután a Talend önkiszolgáló eszközökön keresztül jelentést kapott az adatokból, megoszthatja adatait felhasználóbarát API-kon keresztül. A Talend API-végpontok a fejlett adatleképezési és -átalakítási eszközökön keresztül elérhetővé tehetik az adatvagyont SaaS, JSON, AVRO és B2B platformokon.

R

R egy jól fejlett és hatékony programozási nyelv tudományos és üzleti alkalmazások feltáró adatelemzésére.

A statisztikai számításokhoz és grafikákhoz ingyenes szoftverként megépített R egy nyelv és egy környezet az adatok bonyolítására, modellezésére és megjelenítésére. Az R környezet szoftvercsomagokat kínál, míg az R nyelv számos statisztikai, klaszterezési, osztályozási, elemzési és grafikus technikát integrál, amelyek segítenek az adatok kezelésében.

R jellemzői

Csomagok gazdag készlete

Az adatmérnökök több mint 10 000 szabványosított csomagot és bővítményt választhatnak a Comprehensive R Archive Network (CRAN) hálózatból. Ez leegyszerűsíti a vitát és az adatelemzést.

Rendkívül erős

A rendelkezésre álló elosztott számítási csomagokkal az R összetett és egyszerű (matematikai és statisztikai) manipulációkat tud végrehajtani az adatobjektumokon és adatkészleteken néhány másodpercen belül.

Platformok közötti támogatás

Az R platformfüggetlen, számos operációs rendszeren képes futni. Más programozási nyelvekkel is kompatibilis, amelyek segítenek a számításilag nehéz feladatok kezelésében.

Az R-t könnyű megtanulni.

Trifacta

Trifacta egy interaktív felhőkörnyezet a gépi tanulási és elemzési modellekkel futtatott adatok profilálásához. Ennek az adatmérnöki eszköznek az a célja, hogy érthető adatokat hozzon létre, függetlenül attól, hogy az adatkészletek mennyire rendetlenek vagy összetettek. A felhasználók eltávolíthatják a dupla bejegyzéseket, és kitölthetik az üres cellákat az adatkészletekben a deduplikáció és a lineáris transzformációs transzformációk segítségével.

Ez az adatrögzítő eszköz bármilyen adatkészletben figyeli a kiugró értékeket és az érvénytelen adatokat. Egy kattintással és húzással a kéznél lévő adatok rangsorolhatók és intelligens módon átalakíthatók a gépi tanulás által támasztott javaslatok segítségével az adatok előkészítésének felgyorsítása érdekében.

Az adatviszály a Trifactában lenyűgöző vizuális profilokon keresztül történik, amelyekben nem műszaki és műszaki személyzet is elfér. A megjelenített és intelligens átalakításokkal a Trifacta büszke arra, hogy a felhasználókat szem előtt tartva tervez.

Függetlenül attól, hogy adatpiacokból, adattárházakból vagy adatforrásokból nyernek adatokat, a felhasználók védve vannak az adat-előkészítés bonyolultságaitól.

A Trifacta jellemzői

Zökkenőmentes felhő integráció

Támogatja az előkészítési munkaterhelést bármely felhő- vagy hibrid környezetben, hogy a fejlesztők élethelyüktől függetlenül feldolgozhassák az adatkészleteket a veszekedéshez.

Több adat Szabványosítási módszerek

A Trifacta wrangler számos mechanizmussal rendelkezik az adatok mintáinak azonosítására és a kimenetek szabványosítására. Az adatmérnökök választhatják a szabványosítást minta, funkció vagy keverés alapján.

Egyszerű munkafolyamat

A Trifacta folyamok formájában szervezi az adat-előkészítési munkákat. Egy folyamat egy vagy több adatkészletet és a hozzájuk tartozó recepteket (az adatokat átalakító meghatározott lépéseket) tartalmaz.

A folyamat ezért csökkenti az adatok importálásával, vitájával, profilalkotásával és exportálásával a fejlesztők által eltöltött időt.

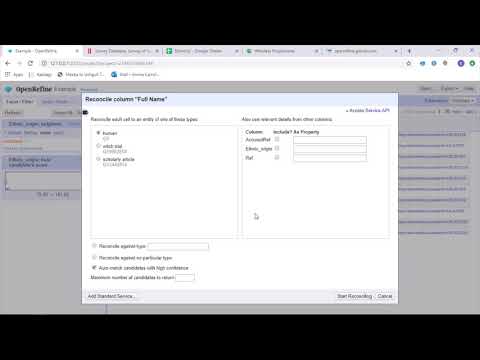

OpenRefine

OpenRefine egy kiforrott, nyílt forráskódú eszköz a rendetlen adatokkal való munkavégzéshez. Adattisztító eszközként az OpenRefine pillanatok alatt feltárja az adatkészleteket, miközben összetett cellaátalakításokat alkalmaz a kívánt adatformátumok megjelenítéséhez.

Az OpenRefine szűrőkön és adathalmazokon reguláris kifejezéseket használó partíciókon keresztül közelíti meg az adatvesztést. A beépített General Refine Expression Language használatával az adatmérnökök a facet-ek, szűrők és rendezési technikák segítségével tanulhatják meg és tekinthetik meg az adatokat, mielőtt speciális adatműveleteket hajtanának végre az entitáskivonásokhoz.

Az OpenRefine lehetővé teszi a felhasználók számára, hogy az adatokon projektként dolgozzanak, ahol több számítógépes fájlból, web URL-ből és adatbázisból származó adatkészleteket lehet bevonni ilyen projektekbe, és helyileg futhatnak a felhasználók gépein.

A kifejezések segítségével a fejlesztők kiterjeszthetik az adattisztítást és -átalakítást olyan feladatokra is, mint a többértékű cellák felosztása/egyesítése, a szempontok testreszabása és az adatok külső URL-ek használatával oszlopokba való lekérése.

Az OpenRefine jellemzői

Cross-platform eszköz

Az OpenRefine úgy készült, hogy Windows, Mac és Linux operációs rendszerekkel működjön a letölthető telepítőbeállításokon keresztül.

API-k gazdag készlete

Tartalmazza az OpenRefine API-t, az adatkiterjesztési API-t, az egyeztetési API-t és más API-kat, amelyek támogatják a felhasználók adatkezelését.

Datameer

A Datameer egy SaaS adatátalakító eszköz, amely az adatgyűjtés és szoftverfejlesztési folyamatokon keresztüli integráció egyszerűsítésére szolgál. A Datameer lehetővé teszi az adatkészletek kinyerését, átalakítását és betöltését felhő adattárházakba, például a Snowflake-be.

Ez az adatrögzítő eszköz jól működik olyan szabványos adatkészlet-formátumokkal, mint a CSV és a JSON, lehetővé téve a mérnökök számára, hogy különböző formátumokban importálják az adatokat aggregálás céljából.

A Datameer katalógusszerű adatdokumentációt, mélyreható adatprofilozást és felfedezést kínál az összes adatátalakítási igény kielégítésére. Az eszköz egy mély vizuális adatprofilt tart fenn, amely lehetővé teszi a felhasználók számára az érvénytelen, hiányzó vagy kiugró mezők és értékek, valamint az adatok általános alakjának nyomon követését.

A méretezhető adattárházban futó Datameer hatékony adathalmazokkal és Excel-szerű funkciókkal átalakítja az adatokat az értelmes elemzés érdekében.

A Datameer hibrid, kódos és kód nélküli felhasználói felületet kínál széles adatelemző csapatok számára, akik könnyedén építhetnek összetett ETL-folyamatokat.

A Datameer jellemzői

Több felhasználói környezet

Többszemélyes adatátalakító környezeteket tartalmaz – alacsony kódú, kódos és hibrid – a technológiában jártas és nem tech személyek támogatására.

Megosztott munkaterületek

A Datameer lehetővé teszi a csapatok számára a modellek újrafelhasználását és együttműködését a projektek felgyorsítása érdekében.

Gazdag adatdokumentáció

A Datameer a rendszer és a felhasználó által generált adatdokumentációt egyaránt támogatja metaadatokon és wiki-stílusú leírásokon, címkéken és megjegyzéseken keresztül.

Utolsó szavak 👩🏫

Az adatelemzés egy összetett folyamat, amely megköveteli az adatok megfelelő rendszerezését, hogy értelmes következtetéseket lehessen levonni és előrejelzéseket lehessen készíteni. A Data Wrangling eszközök segítségével nagy mennyiségű nyers adatot formázhat a fejlett elemzések elvégzése érdekében. Válassza ki az igényeinek leginkább megfelelő eszközt, és váljon Analytics profivá!

Talán tetszene:

A legjobb CSV-eszközök a konvertáláshoz, formázáshoz és ellenőrzéshez.