Olyan eszközöket keres, amelyekkel javíthatja SEO rangsorolását, láthatóságát és konverzióit? Ehhez szükség van egy webrobot eszközre. A webrobot egy olyan számítógépes program, amely az internetet vizsgálja. A webes pókok, a webes adatkinyerő szoftverek és a webhelykaparó programok az internetes webes feltérképezési technológiák példái. Pókbotnak vagy póknak is nevezik. Ma megnézünk néhány ingyenesen letölthető webrobot eszközt.

Tartalomjegyzék

A 25 legjobb ingyenes webes feltérképező eszköz

A webrobot eszközök rengeteg információt nyújtanak az adatbányászat és -elemzés számára. Elsődleges célja az interneten található weboldalak indexelése. Felismerheti a hibás hivatkozásokat, a duplikált tartalmat és a hiányzó oldalcímeket, és azonosíthatja a súlyos SEO-problémákat. Az online adatok lemásolása számos módon előnyös lehet vállalkozása számára.

- Számos webrobot alkalmazás képes megfelelően feltérképezni az adatokat bármely webhely URL-jéről.

- Ezek a programok segítenek Önnek a webhely szerkezetének javításában, hogy a keresőmotorok megérthessék azt, és javíthassák az Ön helyezéseit.

A legnépszerűbb eszközeink listájában összeállítottuk az ingyenesen letölthető webrobot-eszközök listáját, valamint azok funkcióit és költségeit, amelyek közül választhat. A listán fizetős pályázatok is szerepelnek.

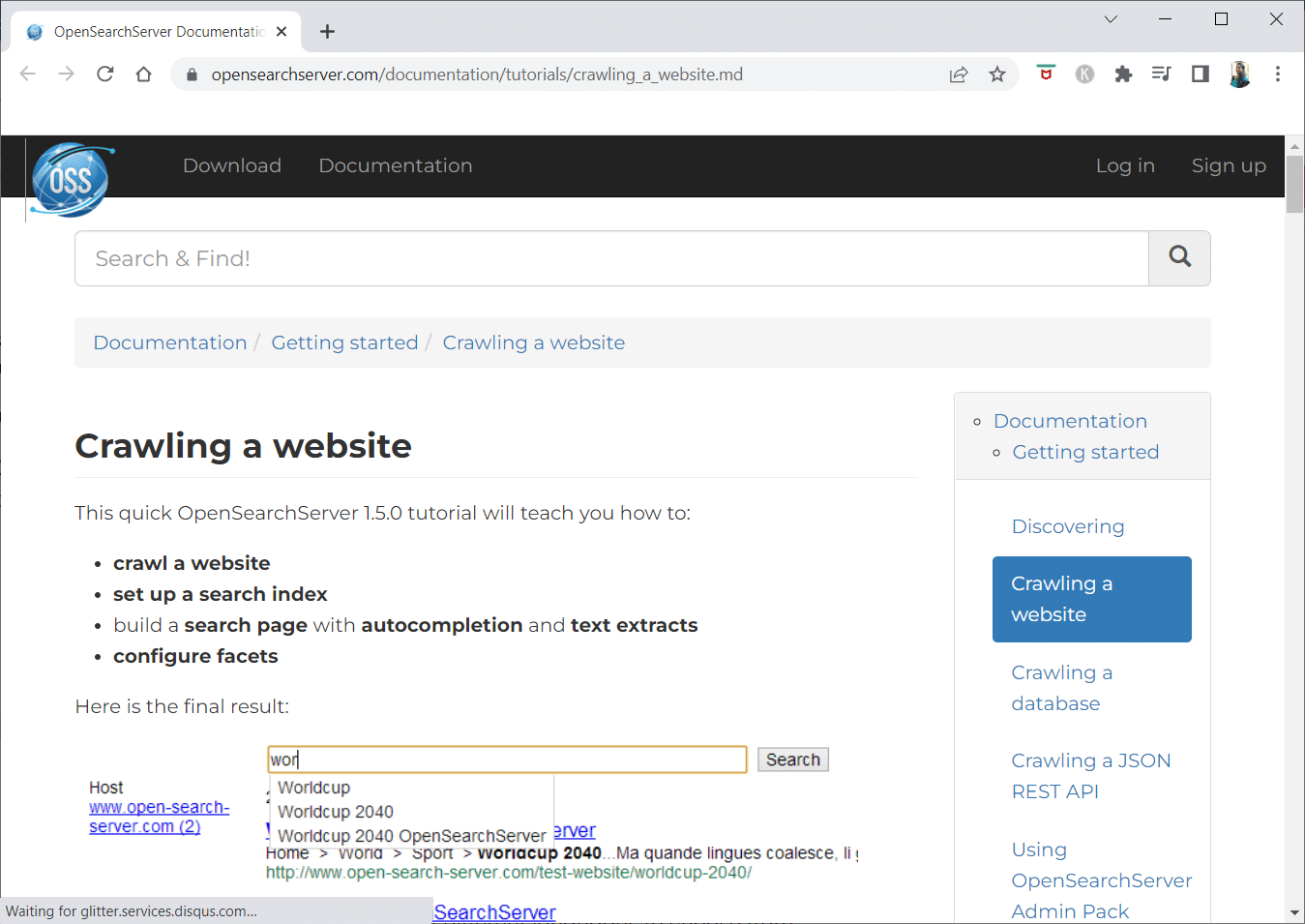

1. Nyissa meg a Keresőkiszolgálót

Az OpenSearchServer egy ingyenes webrobot, és az egyik legjobb értékeléssel rendelkezik az interneten. Az egyik legjobb elérhető alternatíva.

- Ez egy teljesen integrált megoldás.

- Az Open Search Server egy ingyenes és nyílt forráskódú webfeltérképező és keresőmotor.

- Ez egy egyablakos és költséghatékony megoldás.

- A keresési lehetőségek átfogó készletével és saját indexelési stratégia kialakításának lehetőségével érkezik.

- A feltérképező robotok szinte bármit képesek indexelni.

- Választhat teljes szövegű, logikai és fonetikus keresések közül.

- 17 különböző nyelv közül választhat.

- Automatikus osztályozás történik.

- Létrehozhat egy ütemtervet a gyakran előforduló dolgokhoz.

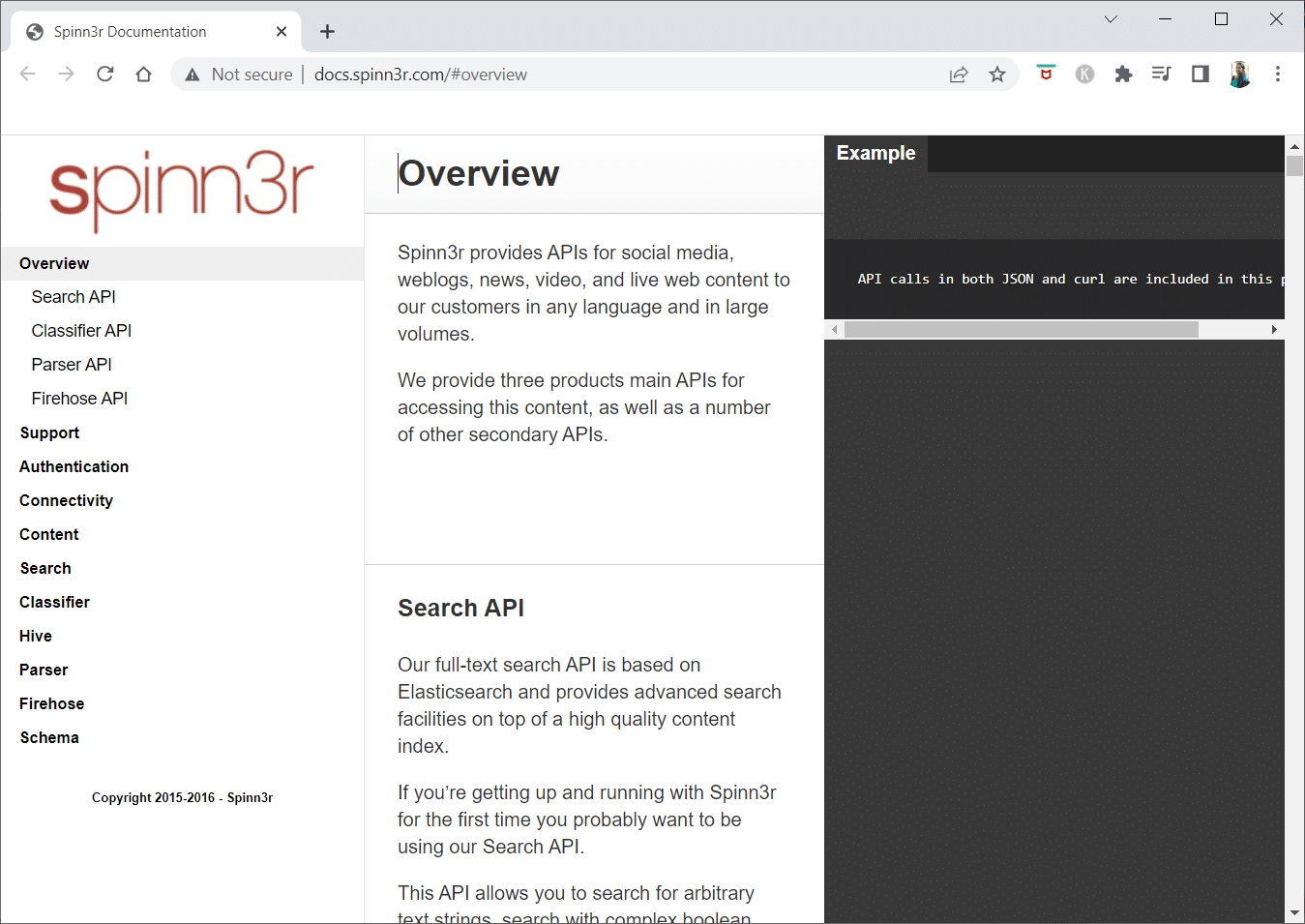

2. Spinn3r

A Spinn3r webbejáró program lehetővé teszi a tartalom teljes kivonatát blogokból, hírekből, közösségi oldalakról, RSS-hírcsatornákról és ATOM-hírcsatornákról.

- Villámgyors API-val érkezik, amely az indexelési munka 95%-át kezeli.

- Ez a webes feltérképező alkalmazás fejlett spamvédelmet tartalmaz, amely eltávolítja a spamet és a nem megfelelő nyelvhasználatot, javítva az adatbiztonságot.

- A webkaparó folyamatosan keresi az interneten számos forrásból származó frissítéseket, hogy valós idejű tartalmat jelenítsen meg.

- A tartalmat ugyanúgy indexeli, mint a Google, és a kivont adatokat JSON-fájlokként menti.

- A Parser API lehetővé teszi az információk gyors elemzését és kezelését tetszőleges web URL-ekhez.

- A Firehose API-t hatalmas mennyiségű adat tömeges elérésére tervezték.

-

Az egyszerű HTTP-fejlécek a Spinn3r összes API-jának hitelesítésére szolgálnak.

- Ez egy ingyenesen letölthető webrobot.

- Az Osztályozó API lehetővé teszi a fejlesztők számára, hogy szöveget (vagy URL-eket) továbbítsanak, amelyeket gépi tanulási technológiánk segítségével címkéznek.

3. Import.io

Az Import.io lehetővé teszi, hogy percek alatt több millió weboldalt kaparjon ki, és több mint 1000 API-t hozzon létre az Ön igényei alapján anélkül, hogy egyetlen kódsort írna.

- Most már programozottan működtethető, és az adatok automatikusan lekérhetők.

- Egy gombnyomással több oldalról is kinyerhet adatokat.

- Automatikusan felismeri a lapozott listákat, vagy rákattinthat a következő oldalra.

- Néhány kattintással online adatokat építhet be alkalmazásába vagy webhelyébe.

- Hozza létre az összes szükséges URL-t néhány másodperc alatt olyan minták, például oldalszámok és kategórianevek használatával.

- Az Import.io segítségével egyszerűen bemutatható, hogyan lehet adatokat levonni egy oldalról. Egyszerűen válasszon ki egy oszlopot az adatkészletből, és mutasson valamire az oldalon, amely felkelti a figyelmét.

- A weboldalukon árajánlatot kaphat.

- A listaoldalakon található linkek további információkat tartalmazó részletes oldalakra vezetnek.

- Az Import.io segítségével csatlakozhat hozzájuk, hogy egyszerre szerezzen be minden adatot a részletező oldalakról.

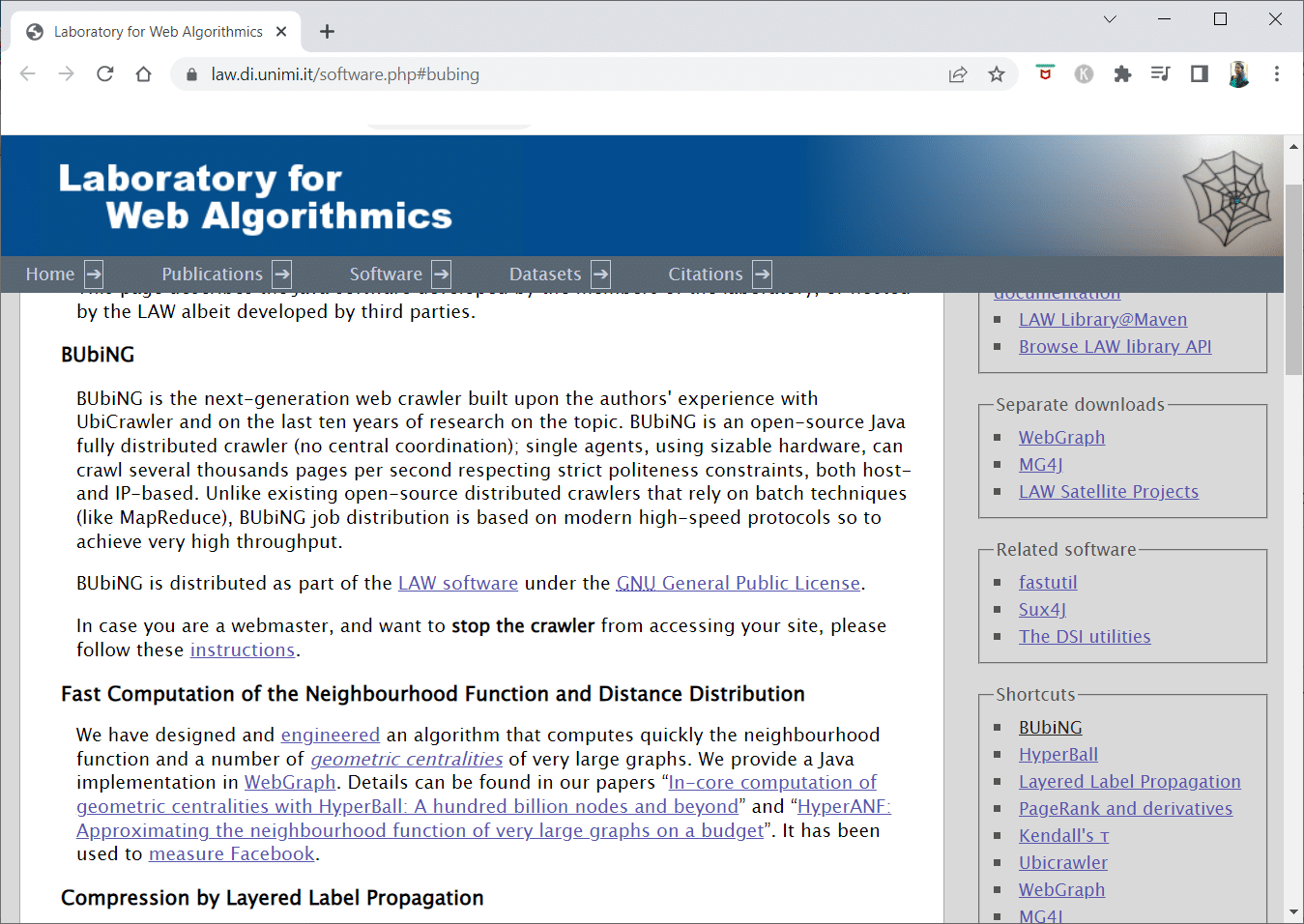

4. BUBIG

A BUbiNG, a következő generációs webrobot eszköz a szerzők UbiCrawlerrel kapcsolatos tapasztalatainak és a téma tíz évnyi kutatásának csúcspontja.

- Egyetlen ügynök több ezer oldalt tud feltérképezni másodpercenként, miközben betartja a szigorú udvariassági szabványokat, mind a gazdagép-, mind az IP-alapú.

- Munkaelosztása kortárs nagy sebességű protokollokra épül, hogy nagyon nagy átviteli sebességet biztosítson, ellentétben a korábbi nyílt forráskódú elosztott bejárókkal, amelyek kötegelt technikáktól függenek.

- A lecsupaszított oldal ujjlenyomatát használja a majdnem ismétlődő példányok észlelésére.

- A BUbiNG egy teljesen elosztott, nyílt forráskódú Java bejáró.

- Rengeteg párhuzam van benne.

- Sokan használják ezt a terméket.

- Ez gyors.

- Lehetővé teszi a nagyméretű bejárást.

5. GNU Wget

A GNU Wget egy ingyenesen letölthető webbejáró eszköz, amely egy C nyelven írt nyílt forráskódú szoftverprogram, amely lehetővé teszi a fájlok letöltését HTTP, HTTPS, FTP és FTPS protokollon keresztül.

- Ennek az alkalmazásnak az egyik legmeghatározóbb jellemzője, hogy képes NLS-alapú üzenetfájlokat létrehozni különböző nyelveken.

- A REST és RANGE használatával leállított letöltéseket újraindíthatja.

- Szükség esetén a letöltött dokumentumok abszolút hivatkozásait is relatív hivatkozásokká alakíthatja.

- Rekurzív helyettesítő karakterek használata a fájlnevekben és a tükrözési könyvtárakban.

- NLS-alapú üzenetfájlok számos nyelvhez.

- A tükrözés során a rendszer kiértékeli a helyi fájl időbélyegeit annak meghatározására, hogy szükséges-e újra letölteni a dokumentumokat.

6. Webhose.io

A Webhose.io egy fantasztikus webrobot alkalmazás, amely lehetővé teszi adatok beolvasását és kulcsszavak kibontását több nyelven, különféle szűrők segítségével, amelyek a források széles skáláját lefedik.

- Az archívum lehetővé teszi a felhasználóknak a korábbi adatok megtekintését is.

- Ezenkívül a webhose.io feltérképezési adatfelfedezései akár 80 nyelven is elérhetők.

- Minden olyan személyazonosításra alkalmas információ, amely feltört, egy helyen található.

- Vizsgálja meg a sötét hálózatokat és az üzenetküldő alkalmazásokat kiberfenyegetésekkel kapcsolatban.

-

Az XML, JSON és RSS formátumok is elérhetők a kimásolt adatokhoz.

- A weboldalukon árajánlatot kaphat.

- A felhasználók egyszerűen indexelhetik és kereshetik a strukturált adatokat a Webhose.io oldalon.

- Minden nyelven képes figyelni és elemezni a médiát.

- A beszélgetések üzenőfalakon és fórumokon követhetők.

- Lehetővé teszi a kulcsfontosságú blogbejegyzések nyomon követését az internet minden részéről.

7. Norconex

A Norconex kiváló forrás azoknak a vállalkozásoknak, akik nyílt forráskódú webrobot alkalmazást keresnek.

- Ez a teljes funkcionalitású gyűjtő használható vagy integrálható a programjába.

- Előfordulhat, hogy egy oldal kiemelt képe is.

- A Norconex lehetővé teszi bármely webhely tartalmának feltérképezését.

- Bármilyen operációs rendszer használható.

- Ez a webrobot szoftver több millió oldalt képes feltérképezni egyetlen átlagos kapacitású szerveren.

- Tartalmaz egy sor eszközt is a tartalom és a metaadatok módosításához.

- Szerezze meg a metaadatokat azokhoz a dokumentumokhoz, amelyeken éppen dolgozik.

-

A JavaScript által renderelt oldalak támogatottak.

- Több nyelv felismerését teszi lehetővé.

- Lehetővé teszi a fordítási segítséget.

- A feltérképezés sebessége változhat.

- A módosított vagy eltávolított dokumentumok azonosításra kerülnek.

- Ez egy teljesen ingyenes webrobot program.

8. Dexi.io

A Dexi.io egy böngészőalapú webrobot, amely lehetővé teszi, hogy információkat gyűjtsön le bármely webhelyről.

-

Az extraktorok, lánctalpasok és csövek az a három típusú robot, amelyet a kaparási művelethez használhat.

- A piaci fejlemények előrejelzése a Delta jelentések segítségével történik.

- Az összegyűjtött adatokat két hétig megőrizzük a Dexi.io szerverein az archiválás előtt, vagy azonnal exportálhatja a kinyert adatokat JSON vagy CSV fájlként.

- A weboldalukon árajánlatot kaphat.

- Professzionális szolgáltatásokat kínálnak, mint például a minőségbiztosítás és a folyamatos karbantartás.

- Kereskedelmi szolgáltatásokat kínál valós idejű adatigényeinek kielégítéséhez.

- Korlátlan számú cikkszám/termék készletének és árának nyomon követése lehetséges.

- Lehetővé teszi az adatok integrálását élő irányítópultok és teljes termékelemzés segítségével.

- Segít a webalapú rendszerezett és használatra kész termékadatok elkészítésében és öblítésében.

9. Zyte

A Zyte egy felhőalapú adatkinyerő eszköz, amely fejlesztők tízezreinek segít megtalálni a döntő fontosságú információkat. Ez egyben az egyik legjobb ingyenes webrobot alkalmazás.

- A felhasználók a nyílt forráskódú vizuális kaparóalkalmazással lekaparhatják a weboldalakat anélkül, hogy bármiféle kódolást ismernének.

-

A Crawlera, a Zyte által használt összetett proxy-forgató lehetővé teszi a felhasználók számára, hogy könnyedén feltérképezzenek nagy vagy botokkal védett webhelyeket, miközben elkerülik a botellenintézkedéseket.

- Az Ön online információit ütemezetten és következetesen kézbesítjük. Következésképpen a proxyk kezelése helyett az adatok beszerzésére összpontosíthat.

- Az intelligens böngésző képességeinek és megjelenítésének köszönhetően a böngészőréteget megcélzó antibotok könnyen kezelhetők.

- Weboldalukon kaphat árajánlatot.

- A felhasználók számos IP-címről és régióból térképezhetnek fel egy egyszerű HTTP API használatával, így nincs szükség a proxy karbantartására.

- Segít készpénz generálásában, miközben időt takarít meg a szükséges információk megszerzésével.

- Lehetővé teszi a webes adatok nagy léptékű kinyerését, miközben időt takarít meg a kódoláson és a pók karbantartásán.

10. Apache Nutch

Az Apache Nutch vitathatatlanul a legjobb nyílt forráskódú webrobot-alkalmazások listájának élén áll.

- Egyetlen gépen tud működni. A legjobban azonban Hadoop-fürtön teljesít.

- A hitelesítéshez az NTLM protokollt használják.

- Elosztott fájlrendszerrel rendelkezik (Hadoopon keresztül).

- Ez egy jól ismert nyílt forráskódú online adatkinyerési szoftverprojekt, amely adaptálható és méretezhető adatbányászathoz.

- Számos adatelemző használja, tudósok, alkalmazásfejlesztők és webszövegbányászati szakemberek világszerte.

- Ez egy Java-alapú, többplatformos megoldás.

- Alapértelmezés szerint a lekérés és az elemzés egymástól függetlenül történik.

- Az adatok XPath és névterek segítségével vannak leképezve.

- Hivatkozási gráf adatbázist tartalmaz.

11. VisualScraper

A VisualScraper egy másik fantasztikus, nem kódoló webkaparó az adatok internetről való kinyerésére.

- Egyszerű point-and-click felhasználói felületet kínál.

- Emellett online adattárolási szolgáltatásokat is kínál, például adatterjesztést és szoftverkivonatok építését.

- A versenytársakat is szemmel tartja.

- A felhasználók ütemezhetik projektjeik futását egy adott időpontban, vagy a sorozatot percenként, napon, héten, hónaponként és évente megismételhetik a Visual Scraper segítségével.

- Olcsóbb és hatékonyabb is.

- Még csak kód sincs, amit ki kellene mondanunk.

- Ez egy teljesen ingyenes webrobot program.

- A valós idejű adatok több weboldalról kinyerhetők és CSV-, XML-, JSON- vagy SQL-fájlként menthetők.

- A felhasználók rendszeresen használhatják híreket, frissítéseket és fórumbejegyzéseket.

- Az adatok 100%-ban pontosak és testreszabottak.

12. WebSzfinx

A WebSphinx egy fantasztikus személyes, ingyenes webrobot alkalmazás, amely egyszerűen beállítható és használható.

- Kifinomult webfelhasználóknak és Java-programozóknak készült, akik az internet korlátozott részét szeretnék automatikusan átvizsgálni.

- Ez az online adatkinyerési megoldás tartalmaz egy Java osztálykönyvtárat és egy interaktív programozási környezetet.

- Az oldalak összefűzhetők egyetlen dokumentummá, amely böngészhető vagy nyomtatható.

-

Kivonja az összes olyan szöveget, amely egy adott mintához illeszkedik egy oldalsorozatból.

- Ennek a csomagnak köszönhetően a webrobotok már Java nyelven is írhatók.

- A Crawler Workbench és a WebSPHINX osztálykönyvtár egyaránt megtalálható a WebSphinxben.

- A Crawler Workbench egy grafikus felhasználói felület, amely lehetővé teszi a webrobot testreszabását és működtetését.

- Weboldalak csoportjából grafikon készíthető.

- Mentse az oldalakat a helyi meghajtóra offline olvasáshoz.

13. OutWit Hub

Az OutWit Hub Platform egy olyan kernelből áll, amely kiterjedt adatfelismerési és -kinyerési képességekkel rendelkezik, amelyen végtelen számú különböző alkalmazás hozható létre, amelyek mindegyike a kernel funkcióit használja.

- Ez a webrobot alkalmazás képes átvizsgálni a webhelyeket, és hozzáférhető módon megőrizni az általa felfedezett adatokat.

- Ez egy többcélú betakarítógép a lehető legtöbb funkcióval, hogy megfeleljen a különféle követelményeknek.

- A Hub már régóta létezik.

- Hasznos és változatos platformmá fejlődött a nem műszaki felhasználók és informatikai szakemberek számára, akik tudják, hogyan kell kódolni, de felismerik, hogy a PHP nem mindig az ideális megoldás az adatok kinyerésére.

- Az OutWit Hub egyetlen interfészt biztosít szerény vagy nagy mennyiségű adat lekaparásához, az Ön igényeitől függően.

- Lehetővé teszi, hogy bármely weboldalt közvetlenül a böngészőből lekaparjon, és automatizált ügynököket hozzon létre, amelyek megragadják az adatokat, és az Ön igényei szerint előkészítik azokat.

- A weboldalukon árajánlatot kaphat.

14. Scrapy

A Scrapy egy Python online lekaparási keretrendszer méretezhető webrobotok létrehozásához.

- Ez egy teljes webes feltérképezési keretrendszer, amely kezeli az összes olyan jellemzőt, amely megnehezíti a webrobotok létrehozását, például a proxy köztes szoftvereket és a lekérdezési kérdéseket.

- Megírhatja az adatok kinyerésének szabályait, majd hagyja, hogy a Scrapy kezelje a többit.

- Könnyen hozzáadhat új funkciókat a mag módosítása nélkül, mert ezt így tervezték.

- Ez egy Python-alapú program, amely Linux, Windows, Mac OS X és BSD rendszereken működik.

- Ez egy teljesen ingyenes segédprogram.

- Könyvtára egy használatra kész struktúrát biztosít a programozóknak a webrobot testreszabásához és az adatok hatalmas méretarányú kinyeréséhez.

15. Mozenda

A Mozenda a legjobb ingyenes webrobot alkalmazás is. Ez egy üzletközpontú felhőalapú önkiszolgáló webkaparó program. A Mozendának több mint 7 milliárd oldala van, és vállalati ügyfelei vannak szerte a világon.

- A Mozenda webkaparási technológiája megszünteti a szkriptekre és a mérnökök alkalmazására vonatkozó követelményt.

- Ötszörösére gyorsítja az adatgyűjtést.

- A Mozenda point-and-click funkciójával szöveget, fájlokat, képeket és PDF-információkat másolhat le webhelyekről.

- Az adatállományok rendszerezésével felkészítheti azokat a publikálásra.

- A Mozeda API használatával közvetlenül exportálhat TSV, CSV, XML, XLSX vagy JSON formátumba.

- Használhatja a Mozenda kifinomult Data Wrangling szolgáltatását információi rendszerezésére, hogy létfontosságú döntéseket hozhasson.

- Használhatja a Mozenda partnereinek egyik platformját az adatok integrálására vagy egyéni adatintegrációk létrehozására néhány platformon.

16. Cyotek Webcopy

A Cyotek Webcopy egy ingyenes webrobot, amely lehetővé teszi a webhelyek tartalmának automatikus letöltését helyi eszközére.

- A kiválasztott weboldal tartalmát beszkenneljük és letöltjük.

- Kiválaszthatja, hogy a webhely mely részeit klónozza, és hogyan használja fel összetett szerkezetét.

- Az új helyi útvonal átirányítja a hivatkozásokat a webhely erőforrásaira, például stíluslapokra, képekre és egyéb oldalakra.

- Megvizsgálja egy webhely HTML-jelölését, és megpróbálja megtalálni a kapcsolódó forrásokat, például más webhelyeket, fényképeket, videókat, fájlletöltéseket stb.

- Feltérképezhet egy webhelyet, és letölthet bármit, amit lát, hogy elfogadható másolatot készítsen az eredetiről.

17. Közös bejárás

A Common Crawl mindenki számára készült, aki érdeklődik az adatok feltárása és elemzése iránt, hogy hasznos betekintést nyerhessen.

- Ez egy 501(c)(3) nonprofit szervezet, amely adományokra támaszkodik működésének megfelelő működéséhez.

- Bárki, aki szeretné használni a Common Crawl-t, megteheti anélkül, hogy pénzt költene vagy problémákat okozna.

- A Common Crawl egy korpusz, amely oktatásra, kutatásra és elemzésre használható.

- Érdemes elolvasnia a cikkeket, ha nem rendelkezik technikai ismeretekkel ahhoz, hogy megismerje azokat a figyelemre méltó felfedezéseket, amelyeket mások tettek a Common Crawl adatok felhasználásával.

- A tanárok használhatják ezeket az eszközöket az adatelemzés tanítására.

18. Semrush

A Semrush egy webhelyrobot, amely megvizsgálja webhelyének oldalait és szerkezetét technikai SEO-problémák miatt. Ezeknek a problémáknak a megoldása javíthatja a keresési eredményeket.

- Eszközei vannak SEO-hoz, piackutatáshoz, közösségi média marketinghez és reklámozáshoz.

- Felhasználóbarát felhasználói felülettel rendelkezik.

-

Megvizsgálják a metaadatokat, a HTTP/HTTPS-t, az irányelveket, az állapotkódokat, a duplikált tartalmat, az oldalválasz sebességét, a belső hivatkozásokat, a képméreteket, a strukturált adatokat és egyéb elemeket.

- Lehetővé teszi webhelyének gyors és egyszerű auditálását.

- Segíti a naplófájlok elemzését.

- Ez a program egy irányítópultot biztosít, amely lehetővé teszi a webhelyekkel kapcsolatos problémák egyszerű megtekintését.

19. Sitechecker.pro

A Sitechecker.pro egy másik legjobb ingyenes webrobot alkalmazás. Ez a webhelyek SEO-ellenőrzője, amely segít javítani SEO rangsorolását.

- Könnyen megjelenítheti egy weboldal szerkezetét.

- Létrehoz egy oldalon lévő SEO audit jelentést, amelyet az ügyfelek e-mailben kaphatnak meg.

- Ez a webrobot eszköz meg tudja nézni a webhely belső és külső hivatkozásait.

- Segít a webhely sebességének meghatározásában.

- A Sitechecker.pro segítségével is ellenőrizheti a céloldalak indexelési problémáit.

- Segít a hackertámadások elleni védekezésben.

20. Webharvy

A Webharvy egy webkaparó eszköz, egyszerű point-and-click felülettel. Azoknak tervezték, akik nem tudják, hogyan kell kódolni.

- A licenc ára 139 dollártól kezdődik.

- A WebHarvy beépített böngészője segítségével töltheti be az online webhelyeket, és egérkattintással választhatja ki a lemásolni kívánt adatokat.

- Automatikusan képes kimásolni a szövegeket, fényképeket, URL-eket és e-maileket a webhelyekről, és különféle formátumokban elmenteni őket.

-

Proxyszerverek vagy VPN használható a célwebhelyek eléréséhez.

- Az adatok lekaparásához nincs szükség programozás vagy alkalmazások létrehozására.

- Ön névtelenül is lekaparhatja, és megakadályozhatja, hogy a webszerverek tiltsák a webkaparó szoftvert, ha proxyszervert vagy VPN-t használ a célwebhelyek eléréséhez.

- A WebHarvy automatikusan azonosítja az adatmintákat a webhelyeken.

- Ha egy weblapról objektumok listáját kell kikaparnia, akkor semmi mást nem kell tennie.

21. NetSpeak Spider

A NetSpeak Spider egy asztali webrobot alkalmazás a napi SEO auditokhoz, a problémák gyors azonosításához, szisztematikus elemzések elvégzéséhez és weboldalak lekaparásához.

- Ez a webes feltérképező alkalmazás kiválóan alkalmas nagyméretű weboldalak kiértékelésére, miközben minimálisra csökkenti a RAM-felhasználást.

- A CSV-fájlok könnyen importálhatók és exportálhatók a webes feltérképezési adatokból.

- Néhány kattintással azonosíthatja ezeket és több száz egyéb súlyos webhely-optimalizálási problémát.

- Az eszköz segít Önnek felmérni a webhely oldalon belüli optimalizálását, beleértve többek között az állapotkódot, a feltérképezési és indexelési utasításokat, a webhely szerkezetét és az átirányításokat.

- A Google Analytics és a Yandex adatai exportálhatók.

- Vegye figyelembe az adattartományt, az eszköztípust és a szegmentációt webhelye oldalai, forgalom, konverziók, célpontok és még az e-kereskedelmi beállítások esetében is.

- Havi előfizetései 21 dollártól kezdődnek.

-

A megszakadt hivatkozásokat és fényképeket a SEO robot észleli, csakúgy, mint az ismétlődő anyagokat, például oldalakat, szövegeket, ismétlődő cím- és metaleíró címkéket, valamint a H1-eket.

22. UiPath

Az UiPath egy webrobot online kaparóeszköz, amely lehetővé teszi a robot eljárások automatizálását. Automatizálja az online és asztali adatok feltérképezését a legtöbb harmadik féltől származó program esetében.

- A robotizált folyamatautomatizálási alkalmazást telepítheti Windows rendszeren.

- Számos weboldalról képes táblázatos és minta alapú adatokat kinyerni.

- Az UiPath további feltérképezéseket tud végrehajtani a dobozból.

- A jelentés nyomon követi robotjait, így bármikor tájékozódhat a dokumentációról.

- Eredményei hatékonyabbak és sikeresebbek lesznek, ha szabványosítja gyakorlatait.

-

A havi előfizetések 420 dollártól kezdődnek.

- A Marketplace több mint 200 kész összetevője több időt biztosít csapatának rövidebb idő alatt.

- Az UiPath robotok növelik a megfelelőséget azáltal, hogy pontosan az Ön igényeinek megfelelő módszert követik.

- A vállalatok gyorsabb digitális átalakulást érhetnek el alacsonyabb költségek mellett a folyamatok optimalizálásával, a gazdaságok felismerésével és betekintést nyújtva.

23. Hélium kaparó

A Helium Scraper egy vizuális online adat-webes feltérképező alkalmazás, amely akkor működik a legjobban, ha kevés az összefüggés az elemek között. Alapszinten kielégítheti a felhasználók feltérképezési igényeit.

- Nem igényel semmilyen kódolást vagy konfigurációt.

- Az áttekinthető és egyszerű felhasználói felület lehetővé teszi a tevékenységek kiválasztását és hozzáadását egy meghatározott listából.

- Online sablonok is rendelkezésre állnak a speciális feltérképezési követelményekhez.

- A képernyőn kívül számos Chromium webböngészőt használnak.

- Növelje az egyidejű böngészők számát, hogy a lehető legtöbb adatot megszerezze.

- Határozza meg saját műveleteit, vagy használjon egyéni JavaScriptet a bonyolultabb példányokhoz.

- Telepíthető személyi számítógépre vagy dedikált Windows szerverre.

- Licencei 99 dollártól kezdődnek, és onnantól emelkednek.

24. 80Lábak

2009-ben megalapították a 80Legst, hogy az online adatok hozzáférhetőbbé váljanak. Ez az egyik legjobb ingyenes webrobot eszköz. Kezdetben a cég arra összpontosított, hogy webes feltérképezési szolgáltatásokat nyújtson különféle ügyfelek számára.

- Kiterjedt webrobot alkalmazásunk személyre szabott információkat nyújt.

- A feltérképezési sebesség automatikusan a webhely forgalmának megfelelően módosul.

- A leleteket a 80legs segítségével töltheti le helyi környezetére vagy számítógépére.

- Egy URL megadásával feltérképezheti a webhelyet.

- Havi előfizetései havi 29 dollártól kezdődnek.

- A SaaS-en keresztül lehetőség nyílik webes feltérképezések létrehozására és lebonyolítására.

- Számos szerverrel rendelkezik, amelyek lehetővé teszik a webhely megtekintését különböző IP-címekről.

- Azonnali hozzáférést kaphat a webhely adataihoz az internet böngészése helyett.

- Megkönnyíti a testreszabott webes feltérképezések felépítését és végrehajtását.

- Használhatja ezt az alkalmazást az online trendek nyomon követésére.

- Ha akarod, elkészítheted a sablonokat.

25. ParseHub

A ParseHub egy kiváló webrobot, amely információkat gyűjthet az AJAX-ot, JavaScriptet, cookie-kat és egyéb kapcsolódó technológiákat használó webhelyekről.

- Gépi tanulási motorja képes olvasni, kiértékelni és értelmes adatokká alakítani az online tartalmat.

- Használhatja a böngészőjében a beépített webalkalmazást is.

- Több millió weboldalról lehet információt szerezni.

- A ParseHub automatikusan keresni fog több ezer link és szó között.

- Az adatokat automatikusan gyűjtjük és tároljuk szervereinken.

-

A havi csomagok 149 dollártól kezdődnek.

- Shareware-ként csak öt nyilvános projektet építhet a ParseHubon.

- Használhatja legördülő menük eléréséhez, webhelyekre való bejelentkezéshez, térképekre kattintáshoz és weboldalak kezeléséhez végtelen görgetéssel, lapokkal és előugró ablakokkal.

- A ParseHub asztali kliense Windows, Mac OS X és Linux rendszerekhez érhető el.

- A lekapart adatait elemzés céljából bármilyen formátumban megszerezheti.

- Legalább 20 privát kaparási projektet hozhat létre prémium tagsági szintekkel.

***

Reméljük, hogy ez a cikk hasznos volt, és kiválasztotta kedvenc ingyenes webrobot eszközét. Ossza meg gondolatait, kérdéseit és javaslatait az alábbi megjegyzés részben. Ezenkívül javasolhatja nekünk a hiányzó eszközöket. Tudassa velünk, mit szeretne legközelebb megtanulni.