Egy gépi tanulási modell felépítése viszonylag egyszerű. Nehéz modellek százait vagy ezreit létrehozni és a meglévőket átvinni.

Könnyű eltévedni a káoszban. Ez a káosz tovább romlik, ha csapatban dolgozol, mivel most nyomon kell követned, hogy mindenki mit csinál. A káosz rendbetétele megköveteli, hogy az egész csapat kövessen egy folyamatot és dokumentálja tevékenységét. Ez az MLOps lényege.

Tartalomjegyzék

Mi az MLOps?

Forrás: ml-ops.org

Az MLOps.org szerint a Machine Learning Operationalization egy teljes körű gépi tanulásfejlesztési folyamatot próbál felépíteni reprodukálható, tesztelhető és fejleszthető, ML-alapú szoftverek tervezésére, felépítésére és kezelésére. Az MLOps lényegében a gépi tanulásra alkalmazott DevOps-elvek.

A DevOpshoz hasonlóan az MLOps kulcsötlete az automatizálás a kézi lépések csökkentése és a hatékonyság növelése érdekében. A DevOps-hoz hasonlóan az MLOp-ok is tartalmazzák a folyamatos integrációt (CI) és a folyamatos szállítást (CD). A kettőn kívül magában foglalja a folyamatos képzést (CT) is. A CT további aspektusa a modellek új adatokkal való átképzése és azok újratelepítése.

Az MLOps tehát egy olyan mérnöki kultúra, amely a gépi tanulási modellfejlesztés módszeres megközelítését és a módszer különböző lépéseinek automatizálását támogatja. A folyamat elsősorban adatkinyerést, elemzést, előkészítést, modell betanítást, értékelést, modellszolgáltatást és monitorozást foglal magában.

Az MLOps előnyei

Általánosságban elmondható, hogy az MLOps elvek alkalmazásának előnyei megegyeznek a szabványos működési eljárások előnyeivel. Az előnyök a következők:

- Egy jól definiált folyamat útitervet ad a modellfejlesztésben megteendő összes döntő lépésről. Ez biztosítja, hogy egyetlen kritikus lépés se maradjon el.

- A folyamat automatizálható lépései azonosíthatók és automatizálhatók. Ez csökkenti az ismétlődő munka mennyiségét és növeli a fejlődés sebességét. Kiküszöböli az emberi hibákat is, miközben csökkenti az elvégzendő munka mennyiségét.

- Könnyebbé válik a modell fejlesztésének előrehaladásának felmérése, ha tudjuk, hogy a folyamat mely szakaszában van a modell.

- A csapatok könnyebben kommunikálhatnak, mivel közös szókincsünk van a fejlesztés során megteendő lépésekre.

- A folyamat többször is alkalmazható számos modell kifejlesztésére, módot adva a káosz kezelésére.

Tehát végső soron az MLOps szerepe a gépi tanulásban az, hogy módszeres megközelítést biztosítsanak a modellfejlesztéshez, amely a lehető legnagyobb mértékben automatizálható.

Platformok csővezetékek építéséhez

Az MLOp-ok bevezetésének elősegítése érdekében használhatja az itt tárgyalt platformok egyikét. Bár ezeknek a platformoknak az egyes funkciói eltérőek lehetnek, alapvetően a következőkben segítenek:

- Tárolja az összes modellt a hozzájuk tartozó modell-metaadatokkal együtt – például konfigurációkat, kódot, pontosságot és kísérleteket. Tartalmazza a modellek különböző verzióit is a verzióvezérléshez.

- Tárolja az adatkészlet metaadatait, például a modellek betanításához használt adatokat.

- Kövesse nyomon a gyártásban lévő modelleket, hogy felderítse a problémákat, például a modelleltolódást.

- Modellek üzembe helyezése a termelésben.

- Építsen modelleket alacsony kódú vagy kód nélküli környezetben.

Fedezzük fel a legjobb MLOps platformokat.

MLFlow

Az MLFlow talán a legnépszerűbb gépi tanulási életciklus-kezelési platform. Ez ingyenes és nyílt forráskódú. A következő funkciókat kínálja:

- nyomon követés a gépi tanulási kísérletek, kódok, adatok, konfigurációk és végső eredmények rögzítéséhez;

- projektek a kód könnyen reprodukálható formátumba történő csomagolásához;

- üzembe helyezés a gépi tanulás üzembe helyezéséhez;

- egy rendszerleíró adatbázis, amely az összes modelljét egy központi tárolóban tárolja

Az MLFlow integrálható olyan népszerű gépi tanulási könyvtárakkal, mint a TensorFlow és a PyTorch. Olyan platformokkal is integrálható, mint az Apache Spark, a H20.asi, a Google Cloud, az Amazon Sage Maker, az Azure Machine Learning és a Databricks. Különféle felhőszolgáltatókkal is működik, mint például az AWS, a Google Cloud és a Microsoft Azure.

Azure Machine Learning

Az Azure Machine Learning egy teljes körű gépi tanulási platform. Kezeli a gépek különböző életciklus-tevékenységeit az MLOP-folyamatban. Ezek a tevékenységek magukban foglalják az adatok előkészítését, a modellek felépítését és képzését, a modellek validálását és telepítését, valamint a telepítések kezelését és nyomon követését.

Az Azure Machine Learning lehetővé teszi, hogy modelleket készítsen a preferált IDE és a választott PyTorch vagy TensorFlow keretrendszer használatával.

Integrálódik az ONNX Runtime és Deepspeed programokkal is, hogy optimalizálja az edzést és a következtetéseket. Ez javítja a teljesítményt. Kihasználja a Microsoft Azure AI-infrastruktúráját, amely egyesíti az NVIDIA GPU-kat és a Mellanox-hálózatot, hogy segítsen a gépi tanulási fürtök felépítésében. Az AML segítségével központi nyilvántartást hozhat létre modellek és adatkészletek tárolására és megosztására.

Az Azure Machine Learning integrálható a Git és a GitHub Actions szolgáltatással a munkafolyamatok létrehozásához. Támogatja a hibrid vagy többfelhős beállítást is. Integrálhatja más Azure-szolgáltatásokkal is, mint például a Synapse Analytics, a Data Lake, a Databricks és a Security Center.

Google Vertex AI

A Google Vertex AI egy egységes adat- és mesterségesintelligencia-platform. Biztosítja az egyedi és előre betanított modellek készítéséhez szükséges szerszámokat. Végpontok közötti megoldásként is szolgál az MLOps megvalósításához. A könnyebb használat érdekében integrálja a BigQuery-t, a Dataproc-ot és a Spark-ot a zökkenőmentes adathozzáférés érdekében az edzés során.

Az API mellett a Google Vertex AI alacsony kódú és kód nélküli eszközkörnyezetet biztosít, így nem fejlesztők, például üzleti és adatelemzők és mérnökök is használhatják. Az API lehetővé teszi a fejlesztők számára, hogy integrálják a meglévő rendszerekkel.

A Google Vertex AI azt is lehetővé teszi, hogy generatív AI-alkalmazásokat készítsen a Generative AI Studio segítségével. Ez megkönnyíti és gyorsítja az infrastruktúra telepítését és kezelését. A Google Vertex AI ideális használati esetei közé tartozik az adatok készenlétének biztosítása, a funkciótervezés, a betanítás és a hiperparaméter-hangolás, a modellszolgáltatás, a modellhangolás és -megértés, a modellfigyelés és a modellkezelés.

Databricks

A Databricks egy adattóház, amely lehetővé teszi az adatok előkészítését és feldolgozását. A Databricks segítségével a teljes gépi tanulási életciklust kezelheti a kísérletezéstől a gyártásig.

A Databricks lényegében olyan felügyelt MLFlow-t biztosít, amely olyan funkciókat kínál, mint az ML-modellek adatnaplózó hirdetési verziója, a kísérletek követése, a modellszolgáltatás, a modellnyilvántartás és a hirdetési metrikák követése. A modellnyilvántartás lehetővé teszi a modellek tárolását a reprodukálhatóság érdekében, a rendszerleíró adatbázis pedig segít nyomon követni a verziókat és az életciklusuk szakaszát.

A Dataricks használatával modellek üzembe helyezése egyetlen kattintással elvégezhető, és REST API-végpontjai lesznek az előrejelzések készítéséhez. Más modellek mellett jól integrálható a meglévő, előre betanított generatív és nagy nyelvi modellekkel, például az ölelő arctranszformátorok könyvtárából.

A Dataricks együttműködő Databricks jegyzetfüzeteket biztosít, amelyek támogatják a Python, R, SQL és Scalát. Ezenkívül leegyszerűsíti az infrastruktúra kezelését azáltal, hogy előre konfigurált fürtöket biztosít, amelyek a Machine Learning feladatokra vannak optimalizálva.

AWS SageMaker

Az AWS SageMaker egy AWS felhőszolgáltatás, amely biztosítja a gépi tanulási modellek fejlesztéséhez, betanításához és üzembe helyezéséhez szükséges eszközöket. A SageMaker elsődleges célja, hogy automatizálja a gépi tanulási modell felépítésével járó fárasztó és ismétlődő manuális munkát.

Ennek eredményeként eszközöket biztosít a gépi tanulási modellek gyártási folyamatának létrehozásához különböző AWS-szolgáltatások, például Amazon EC2 példányok és Amazon S3 tárolók használatával.

A SageMaker az EC2-példányra telepített Jupyter Notebookokkal működik együtt a Machine Learning modell kódolásához szükséges összes általános csomaggal és könyvtárral. Az adatokhoz a SageMaker képes adatokat gyűjteni az Amazon Simple Storage Service szolgáltatásból.

Alapértelmezés szerint az általános gépi tanulási algoritmusok, például a lineáris regresszió és a képosztályozás megvalósításait kapja meg. A SageMaker modellmonitorral is rendelkezik, amely folyamatos és automatikus hangolást biztosít, hogy megtalálja a legjobb teljesítményt biztosító paramétereket. A telepítés is leegyszerűsödött, mivel könnyedén telepítheti modelljét az AWS-re, mint biztonságos HTTP-végpontot, amelyet a CloudWatch segítségével figyelhet.

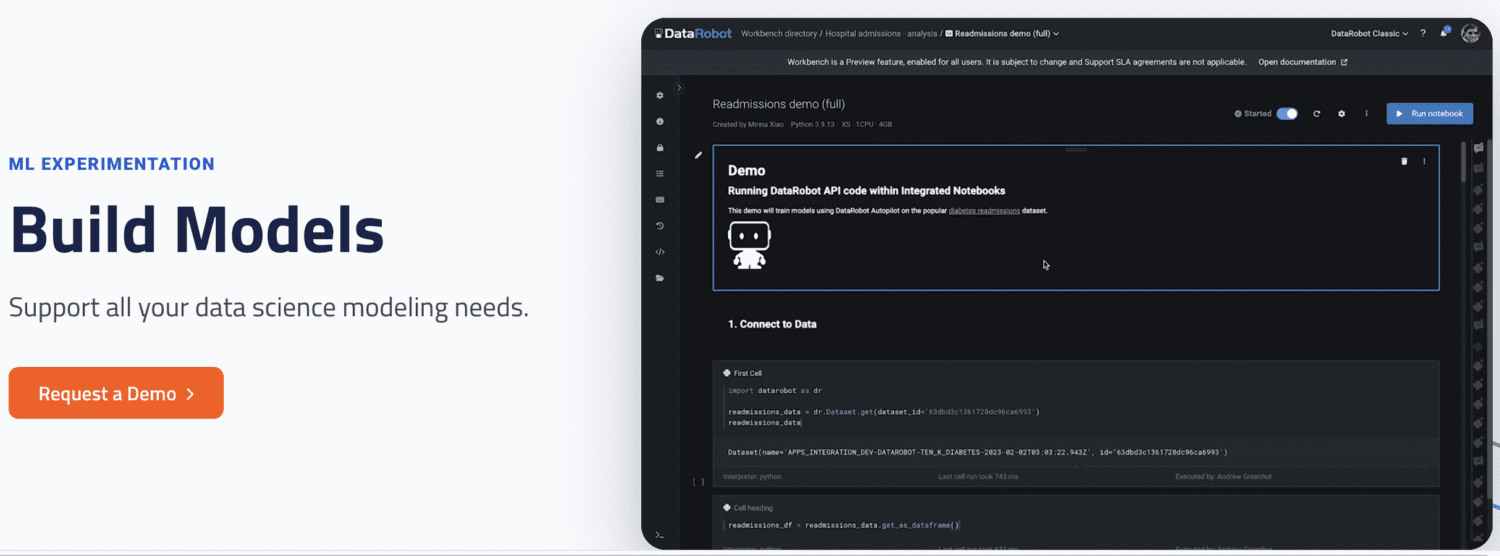

DataRobot

A DataRobot egy népszerű MLOps-platform, amely lehetővé teszi a gépi tanulás életciklusának különböző szakaszaiban történő kezelést, például az adatok előkészítését, az ML-kísérletezést, a validálást és a modellek irányítását.

Eszközökkel rendelkezik a különböző adatforrásokkal futó kísérletek automatizálására, több ezer modell tesztelésére és a legjobbak értékelésére az éles környezetben. Támogatja a különböző típusú mesterséges intelligencia-modellek modelljeinek építését az idősorok, a természetes nyelvi feldolgozás és a számítógépes látás problémáinak megoldásához.

A DataRobot segítségével már kész modellekkel is építhet, így nem kell kódot írnia. Alternatív megoldásként választhat a kód-első megközelítés mellett, és egyedi kóddal implementálhatja a modelleket.

A DataRobot notebookokkal érkezik a kód írásához és szerkesztéséhez. Alternatív megoldásként használhatja az API-t, így modelleket fejleszthet egy választott IDE-ben. A GUI segítségével nyomon követheti modelljei kísérleteit.

Futtassa az AI-t

A Run AI megpróbálja megoldani az AI-infrastruktúra, különösen a GPU-k kihasználatlanságának problémáját. Ezt a problémát úgy oldja meg, hogy elősegíti az összes infrastruktúra láthatóságát, és gondoskodik annak kihasználásáról a képzés során.

Ennek végrehajtásához a Run AI az MLOps szoftver és a cég hardvere között helyezkedik el. Miközben ezt a réteget elfoglalja, az összes képzési feladat a Run AI segítségével fut. A platform pedig ütemezi, hogy mikor futnak ezek a feladatok.

Nincs korlátozás arra vonatkozóan, hogy a hardvernek felhőalapúnak kell lennie, mint például az AWS és a Google Cloud, helyszíni vagy hibrid megoldás. GPU-virtualizációs platformként funkcionálva egy absztrakciós réteget biztosít a Machine Learning csapatok számára. Futtathat feladatokat a Jupyter Notebookból, a bash terminálból vagy a távoli PyCharmból.

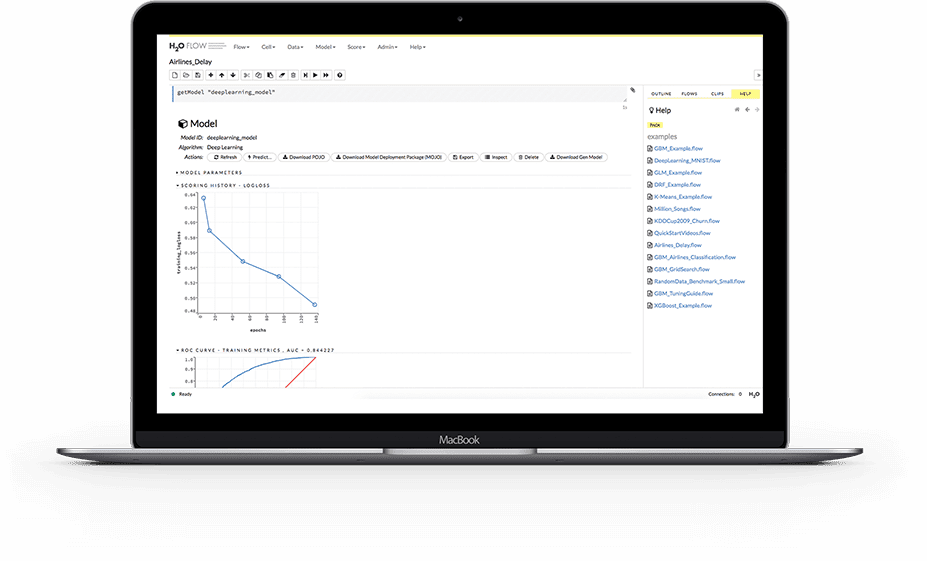

H2O.ai

A H2O egy nyílt forráskódú, elosztott gépi tanulási platform. Lehetővé teszi a csapatok számára, hogy együttműködjenek, és központi tárházat hozzanak létre a modellek számára, ahol az adatkutatók kísérletezhetnek és összehasonlíthatják a különböző modelleket.

MLOps platformként a H20 számos kulcsfontosságú funkciót kínál. Először is, a H2O leegyszerűsíti a modell üzembe helyezését a kiszolgálón REST-végpontként. Különböző telepítési témákat kínál, mint például az A/B teszt, a Champoion-Challenger modellek és az egyszerű, egymodellű telepítés.

A képzés során adatokat, műtermékeket, kísérleteket, modelleket és telepítéseket tárol és kezel. Ez lehetővé teszi a modellek reprodukálhatóságát. Ezenkívül lehetővé teszi a csoport- és felhasználói szintű engedélykezelést a modellek és adatok szabályozásához. Amíg a modell fut, a H2O valós idejű monitorozást is biztosít a modelleltolódáshoz és egyéb működési mutatókhoz.

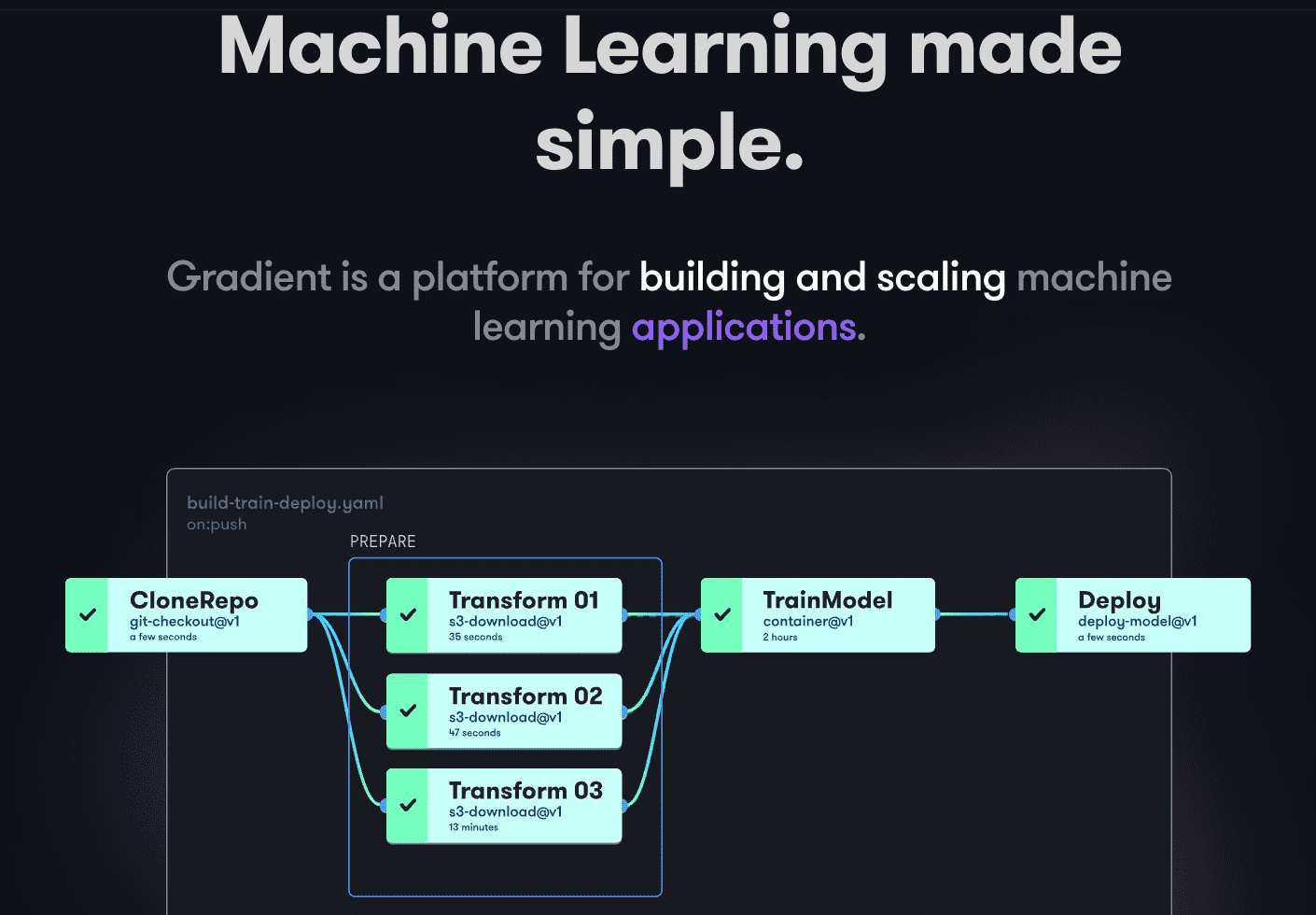

Paperspace Gradient

A Gradient a gépi tanulás fejlesztési ciklusának minden szakaszában segíti a fejlesztőket. Nyílt forráskódú Jupyterrel működő notebookokat biztosít a felhőben történő modellfejlesztéshez és -tanuláshoz, nagy teljesítményű GPU-k segítségével. Ez lehetővé teszi a modellek gyors felfedezését és prototípusát.

A telepítési folyamatok munkafolyamatok létrehozásával automatizálhatók. Ezeket a munkafolyamatokat a YAML-beli feladatok leírása határozza meg. A munkafolyamatok használatával a telepítések és a kiszolgálási modellek létrehozása könnyen replikálható, és ennek eredményeként méretezhető.

A Gradient összességében konténereket, gépeket, adatokat, modelleket, metrikákat, naplókat és titkokat biztosít, amelyek segítségével kezelheti a Machine Learning modellfejlesztési folyamat különböző szakaszait. A folyamatok Gradiet-fürtökön futnak. Ezek a fürtök a Paperspace Cloudon, az AWS-en, a GCP-n, az Azure-on vagy bármely más kiszolgálón találhatók. A Gradient programozottan CLI vagy SDK használatával kommunikálhat.

Végső szavak

Az MLOps egy hatékony és sokoldalú megközelítés a gépi tanulási modellek méretarányos felépítéséhez, telepítéséhez és kezeléséhez. Az MLOps könnyen használható, méretezhető és biztonságos, így bármilyen méretű szervezet számára jó választás.

Ebben a cikkben bemutattuk az MLOP-okat, miért fontos ezek megvalósítása, miről van szó, valamint a különböző népszerű MLOps platformokról.

Ezután érdemes elolvasni a Dataricks vs. Snowflake összehasonlítását.