Die Gefahren im Web und wie man sie bekämpft

Das Internet ist ein Tummelplatz für schädliche Webseiten. Bedauerlicherweise können diese auch auf den Seiten Ihrer Kunden und Lieferanten lauern.

Heutzutage ist kaum ein Unternehmen ohne Integrationen denkbar, die Daten von Kunden- oder Anbieterseiten beziehen oder bereitstellen. Diese Dienste sind für Ihr Geschäft unerlässlich, können aber gleichzeitig ein Sicherheitsrisiko darstellen. Externe Webseiten, mit denen Sie interagieren, können bösartige Inhalte enthalten – sei es durch Absicht oder durch die Kompromittierung durch Dritte. Gelangen diese Inhalte an die falschen Stellen, können die Folgen verheerend sein.

Ist es nicht möglich, Webseiten manuell auf Schadseiten zu untersuchen?

Es mag den Anschein haben, dass ein erfahrener Entwickler in der Lage sein sollte, Webseiten auf Schwachstellen zu überprüfen. Die Realität sieht jedoch aus verschiedenen Gründen anders aus:

- Entwickler sind nicht primär auf Sicherheitserkennung spezialisiert. Ihre Expertise liegt in der Erstellung komplexer Software durch die Kombination vieler kleinerer Subsysteme. Kurz gesagt, sie verfügen nicht über die notwendigen Fachkenntnisse.

- Selbst ein talentierter Entwickler wäre mit dieser Aufgabe überfordert. Eine typische, funktionsreiche Webseite besteht aus Tausenden von Codezeilen. Diese alle zu überblicken, um sowohl das Gesamtbild als auch kleinste Sicherheitslücken zu erfassen, ist eine Mammutaufgabe. Es wäre, als würde man jemanden bitten, einen ganzen Elefanten zum Mittagessen zu verspeisen!

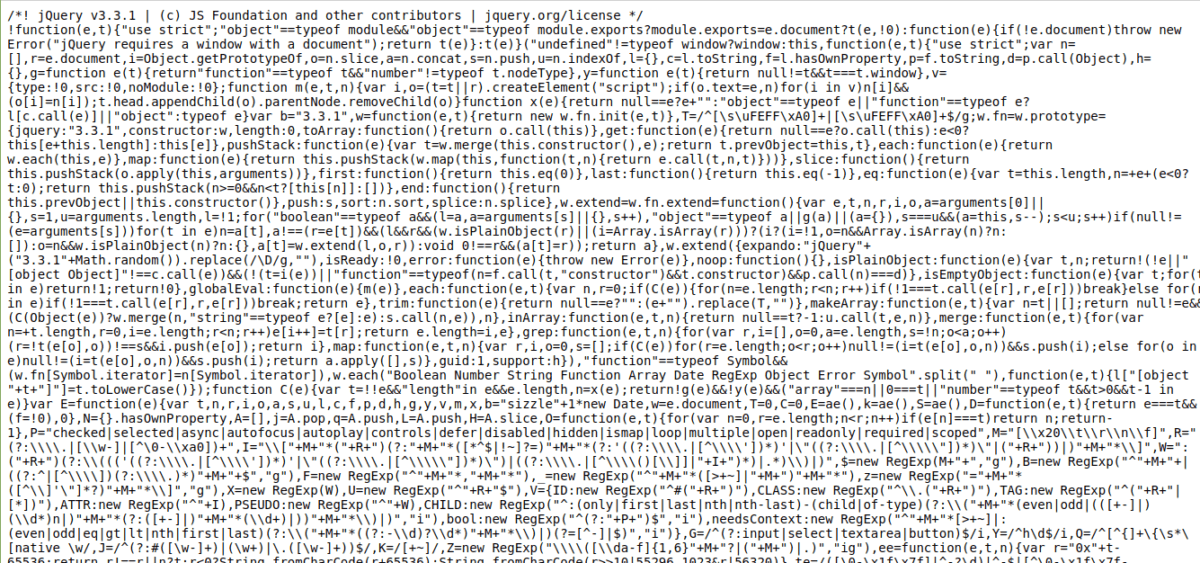

- Webseiten komprimieren und minimieren häufig ihre CSS- und JavaScript-Dateien, um die Ladezeiten zu verkürzen. Dies führt zu einem derartigen Code-Durcheinander, dass er praktisch unlesbar wird.

Was glauben Sie, was dieser Code tut? :kappa: (Quelle: elgg.org)

Wenn dies noch lesbar erscheint, liegt es daran, dass die Urheber beschlossen haben, die Variablennamen in einem größeren Kontext beizubehalten. Betrachten Sie den Quellcode von jQuery, den jemand auf seiner Webseite hosten und manipulieren könnte (zwei Zeilen irgendwo in diesem Durcheinander):

Ganz zu schweigen davon, dass der Quellcode fast 5.000 Zeilen umfasst. 😎

Und das ist nur ein einziges Skript. In der Regel sind 5-15 Skripte an eine Webseite angehängt, und Sie arbeiten wahrscheinlich insgesamt mit 10-20 Webseiten. Stellen Sie sich vor, Sie müssten das jeden Tag tun. Oder noch schlimmer, mehrmals am Tag!

Glücklicherweise gibt es APIs, mit denen URLs schnell und unkompliziert gescannt werden können. Sie können nicht nur Webseiten, sondern auch Dateien überprüfen, die Ihnen zum Download angeboten werden. Lassen Sie uns einige API-Tools betrachten, die Ihnen dabei helfen. Da es sich um APIs handelt, wird Ihr Entwickler bei der Erstellung eines Website-Scanner-Tools mit diesen APIs eine viel bessere Unterstützung haben. 😀

Google Web Risk

Es überrascht nicht, dass ein Webseiten-Prüfer von dem Unternehmen stammt, das praktisch das Internet besitzt (also alle seine Webseiten). Aber es gibt einen Haken: Google Web Risk befindet sich noch in der Beta-Phase und ist nur auf Anfrage verfügbar. In der Beta-Version bedeutet dies mehr Änderungen.

Da die API jedoch recht einfach ist, können alle Änderungen von Ihrem Entwickler mit einem API-Überwachungstool und wenigen Minuten Entwicklungszeit behoben werden. 🙂

Die API ist auch sehr einfach zu verwenden. Um eine einzelne Seite über die Befehlszeile zu prüfen, senden Sie einfach eine Anfrage wie die folgende:

curl -H "Content-Type: application/json" "https://webrisk.googleapis.com/v1beta1/uris:search?key=YOUR_API_KEY&threatTypes=MALWARE&uri=http%3A%2F%2Ftestsafebrowsing.appspot.com%2Fs%2Fmalware.html"

Wenn die Anfrage erfolgreich war, antwortet die API mit der Art der Schwachstelle auf der Seite:

{

"threat": {

"threatTypes": [

"MALWARE"

],

"expireTime": "2019-07-17T15:01:23.045123456Z"

}

}

Wie Sie sehen, bestätigt die API, dass die Seite bekanntermaßen Malware enthält.

Es ist wichtig zu wissen, dass die Google Web Risk API keine On-Demand-Diagnose für eine beliebige URL oder Datei durchführt. Sie konsultiert eine von Google geführte Blacklist, die auf Suchergebnissen und Berichten basiert, und meldet, ob die URL in dieser Blacklist enthalten ist oder nicht. Mit anderen Worten: Wenn diese API angibt, dass eine URL sicher ist, können Sie davon ausgehen, dass sie ziemlich sicher ist, aber es gibt keine Garantien.

VirusTotal

VirusTotal ist ein weiterer praktischer Dienst, mit dem Sie nicht nur URLs, sondern auch einzelne Dateien scannen können (was ihn meiner Meinung nach in Bezug auf die Nützlichkeit über Google Web Risk stellt). Um den Dienst zu testen, gehen Sie einfach auf die Webseite. Direkt auf der Startseite finden Sie die Möglichkeit, loszulegen.

VirusTotal ist als kostenlose Plattform verfügbar, die von einer aktiven Community entwickelt und gepflegt wird, bietet aber auch eine kommerzielle Version seiner API an. Hier sind einige Gründe, warum Sie für den Premium-Service bezahlen sollten:

- Flexible Anforderungsrate und Tageskontingent (im Gegensatz zu den nur vier Anfragen pro Minute für die öffentliche API).

- Die übermittelte Ressource wird von VirusTotal mit seinem Antivirenprogramm gescannt und es werden zusätzliche Diagnoseinformationen zurückgegeben.

- Verhaltensbasierte Informationen zu Ihren eingereichten Dateien (die Dateien werden in verschiedenen Sandbox-Umgebungen platziert, um verdächtige Aktivitäten zu überwachen).

- Abfragen der Dateidatenbank von VirusTotal nach verschiedenen Parametern (komplexe Abfragen werden unterstützt).

- Strenge SLAs und Reaktionszeiten (Dateien, die über die öffentliche API an VirusTotal gesendet werden, werden in eine Warteschlange gestellt und benötigen einige Zeit für die Analyse).

Die Entscheidung für die private VirusTotal-API kann eine der besten Investitionen sein, die Sie jemals in ein SaaS-Produkt für Ihr Unternehmen getätigt haben.

Scanii

Eine weitere empfehlenswerte API für Sicherheitsscans ist Scanii. Es handelt sich um eine einfache REST-API, die übermittelte Dokumente und Dateien auf Bedrohungen scannen kann. Betrachten Sie sie als einen On-Demand-Virenscanner, der problemlos ausgeführt und skaliert werden kann!

Hier sind die Vorteile, die Scanii bietet:

- Kann Malware, Phishing-Skripte, Spam-Inhalte, NSFW-Inhalte (Not Safe For Work) usw. erkennen.

- Es basiert auf Amazon S3 für einfache Skalierung und risikofreie Dateispeicherung.

- Erkennt anstößige, unsichere oder potenziell gefährliche Texte in über 23 Sprachen.

- Ein einfacher, unkomplizierter und fokussierter Ansatz für das API-basierte Scannen von Dateien (also keine unnötig „hilfreichen“ Funktionen).

Das Besondere ist, dass Scanii eine Meta-Engine ist. Das heißt, sie führt keine Scans selbst durch, sondern nutzt eine Reihe von zugrunde liegenden Engines, die die eigentliche Arbeit erledigen. Das ist ein großer Vorteil, da Sie nicht an eine bestimmte Sicherheits-Engine gebunden sind, was bedeutet, dass Sie sich keine Gedanken über fehlerhafte API-Änderungen usw. machen müssen.

Ich betrachte Scanii als einen großen Gewinn für Plattformen, die auf von Nutzern generierten Inhalten angewiesen sind. Ein weiterer Anwendungsfall ist das Scannen von Dateien, die von einem Anbieterdienst generiert wurden, dem Sie nicht zu 100 % vertrauen können.

MetaDefender

Für einige Organisationen reicht das Scannen von Dateien und Webseiten an einem einzigen Endpunkt nicht aus. Sie haben einen komplexen Informationsfluss und keiner der Endpunkte darf kompromittiert werden. Für diese Anwendungsfälle ist MetaDefender die ideale Lösung.

Betrachten Sie MetaDefender als einen paranoiden Torwächter, der zwischen Ihren zentralen Datenbeständen und allem anderen sitzt, einschließlich des Netzwerks. Ich sage „paranoid“, weil dies die Designphilosophie von MetaDefender ist. Ich kann es nicht besser beschreiben als sie selbst:

Die meisten Cybersicherheitslösungen verlassen sich auf die Erkennung als ihre zentrale Schutzfunktion. Die Datenbereinigung von MetaDefender ist nicht auf die Erkennung angewiesen. Es geht davon aus, dass alle Dateien infiziert sein könnten, und baut ihren Inhalt mithilfe eines sicheren und effizienten Prozesses wieder auf. Es unterstützt mehr als 30 Dateitypen und gibt sichere und verwendbare Dateien aus. Die Datenbereinigung ist äußerst effektiv, um gezielte Angriffe, Ransomware und andere Arten von bekannten und unbekannten Malware-Bedrohungen zu verhindern.

Es gibt einige nützliche Funktionen, die MetaDefender bietet:

- Data Loss Prevention: Vereinfacht ausgedrückt, ist dies die Fähigkeit, sensible Informationen, die in Dateiinhalten entdeckt wurden, zu unterdrücken und zu schützen. Beispielsweise wird ein PDF-Beleg mit einer sichtbaren Kreditkartennummer von MetaDefender maskiert.

- Stellen Sie es lokal oder in der Cloud bereit (je nachdem, wie paranoid Sie sind!).

- Durchsucht mehr als 30 Arten von Archivierungsformaten (zip, tar, rar usw.) und 4.500 Dateityp-Spoofing-Tricks.

- Multi-Channel-Bereitstellungen – sichern Sie nur Dateien oder nutzen Sie es für E-Mail-, Netzwerk- und Login-Kontrolle.

- Benutzerdefinierte Workflows zur Anwendung verschiedener Arten von Scan-Pipelines basierend auf benutzerdefinierten Regeln.

MetaDefender umfasst mehr als 30 Engines, abstrahiert diese aber gut, sodass Sie nie darüber nachdenken müssen. Wenn Sie ein mittelständisches oder großes Unternehmen sind, das sich Sicherheitsbedenken nicht leisten kann, ist MetaDefender eine großartige Option.

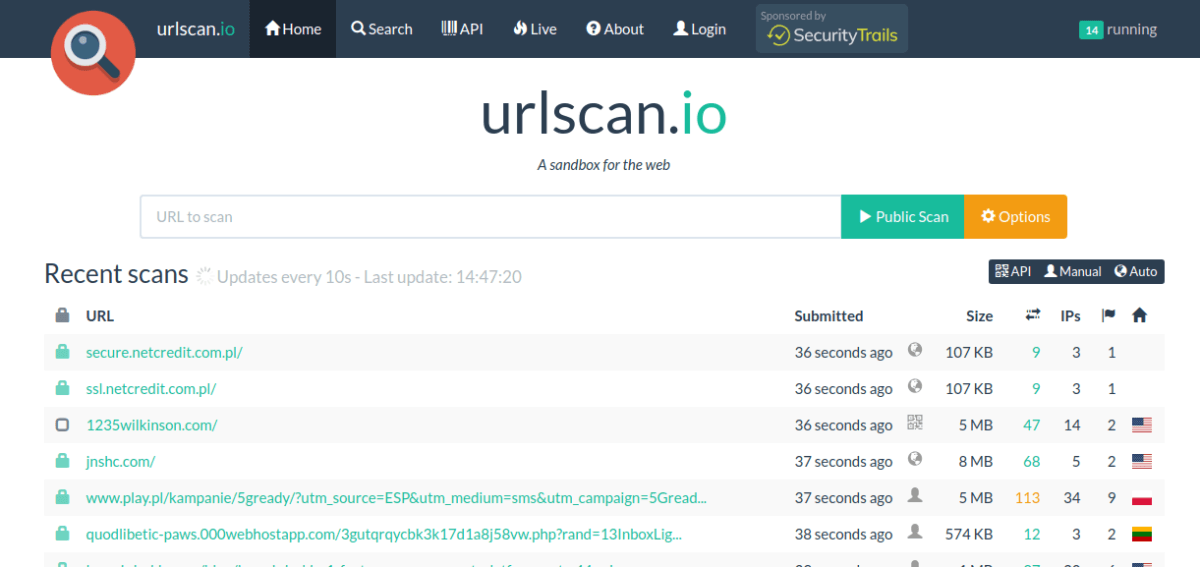

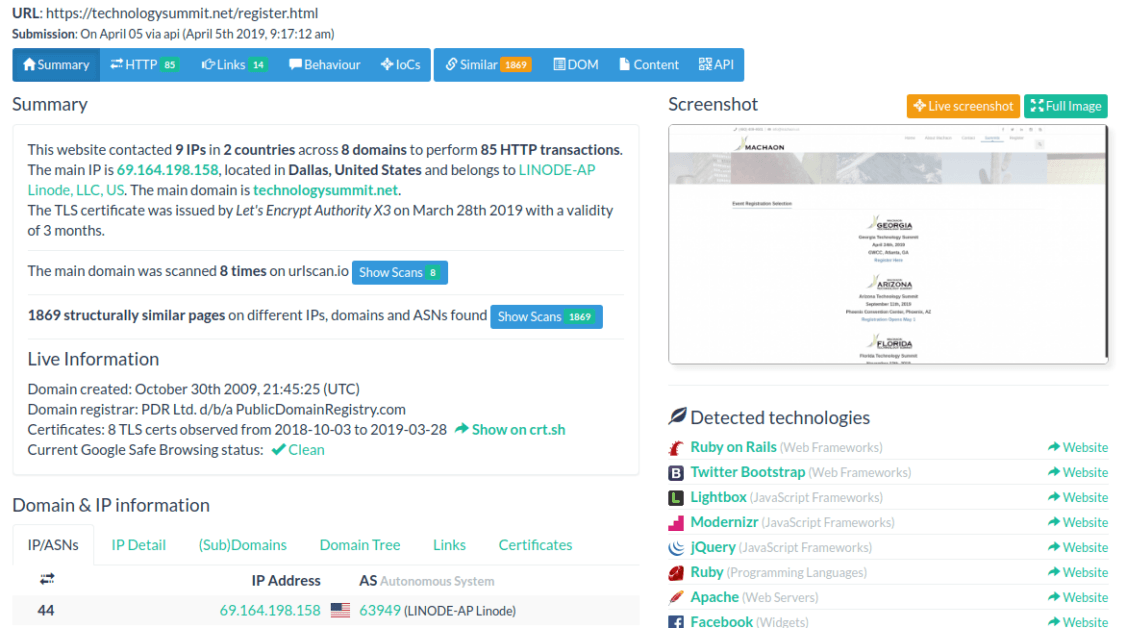

Urlscan.io

Wenn Sie sich hauptsächlich mit Webseiten befassen und schon immer einen detaillierteren Einblick in deren Abläufe hinter den Kulissen haben wollten, ist Urlscan.io eine hervorragende Waffe in Ihrem Arsenal.

Die Menge an Informationen, die Urlscan.io ausgibt, ist beeindruckend. Sie können unter anderem Folgendes sehen:

- Die Gesamtzahl der IP-Adressen, die von der Seite kontaktiert wurden.

- Eine Liste der Regionen und Domänen, an die die Seite Informationen gesendet hat.

- Technologien, die im Frontend und Backend der Webseite verwendet werden (es werden keine Ansprüche auf Genauigkeit erhoben, aber es ist erschreckend genau!).

- Informationen zu Domänen und SSL-Zertifikaten.

- Detaillierte HTTP-Interaktionen zusammen mit Anfragedaten, Servernamen, Antwortzeiten und vielem mehr.

- Versteckte Weiterleitungen und fehlgeschlagene Anfragen.

- Ausgehende Links.

- JavaScript-Analyse (verwendete globale Variablen in den Skripten usw.).

- DOM-Baumanalyse, Formularinhalte und mehr.

So sieht das Ganze aus:

Die API ist einfach und unkompliziert. Sie können eine URL zum Scannen einreichen und die Scan-Historie dieser URL überprüfen (z. B. von anderen durchgeführte Scans). Alles in allem bietet Urlscan.io eine Fülle von Informationen für alle betroffenen Unternehmen oder Einzelpersonen.

SUCURI

SUCURI ist eine bekannte Plattform für das Online-Scannen von Webseiten auf Bedrohungen und Malware. Was Sie vielleicht nicht wissen, ist, dass sie auch eine REST-API anbieten, mit der Sie die gleiche Leistung programmgesteuert nutzen können.

Hier gibt es nicht viel zu sagen, außer dass die API einfach ist und gut funktioniert. Natürlich ist Sucuri nicht auf eine Scan-API beschränkt, daher würde ich Ihnen empfehlen, sich einige der leistungsstarken Funktionen anzusehen, wie z. B. serverseitiges Scannen (im Grunde geben Sie die FTP-Zugangsdaten ein und es meldet sich an und scannt alle Dateien auf Bedrohungen!).

Quttera

Unser letzter Eintrag in dieser Liste ist Quttera, das etwas anders ist. Anstatt die Domäne und übermittelte Seiten bei Bedarf zu scannen, kann Quttera auch eine kontinuierliche Überwachung durchführen und Ihnen dabei helfen, Zero-Day-Schwachstellen zu vermeiden.

Die REST-API ist einfach und leistungsstark und kann einige Formate mehr als JSON zurückgeben (z. B. XML und YAML). Vollständiges Multithreading und Parallelität werden bei Scans unterstützt, sodass Sie mehrere umfassende Scans parallel ausführen können. Da der Dienst in Echtzeit ausgeführt wird, ist er für Unternehmen von unschätzbarem Wert, die auf geschäftskritische Dienste angewiesen sind, bei denen Ausfallzeiten den Untergang bedeuten.

Fazit

Sicherheits-Tools wie die in diesem Artikel behandelten sind einfach eine zusätzliche Verteidigungslinie (oder Vorsichtsmaßnahme, wenn Sie so wollen). Genau wie ein Antivirenprogramm können diese eine Menge tun, aber auf keinen Fall eine ausfallsichere Scanmethode bieten. Das liegt einfach daran, dass ein Programm, das mit böswilliger Absicht geschrieben wurde, für den Computer das Gleiche ist wie ein Programm, das mit positiver Wirkung geschrieben wurde – beide benötigen Systemressourcen und stellen Netzwerkanfragen. Der Teufel steckt im Kontext, den Computer nicht erfolgreich erfassen können.

Dennoch bieten diese APIs eine solide Sicherheitsabdeckung, die in den meisten Fällen wünschenswert ist – sowohl für externe Webseiten als auch für Ihre eigenen! 🙂