Die wachsende Bedeutung von Technologien wie Deep Learning, Künstlicher Intelligenz (KI) und Maschinellem Lernen (ML) hat die Nachfrage nach Cloud-GPUs stark erhöht.

Für Unternehmen, die in den Bereichen 3D-Visualisierung, Maschinelles Lernen, KI oder anspruchsvolle Rechenoperationen tätig sind, ist die Art und Weise, wie GPU-Berechnungen durchgeführt werden, von entscheidender Bedeutung.

Traditionell beanspruchten Deep-Learning-Modelle in Unternehmen erhebliche Zeit für Trainings- und Berechnungsaufgaben. Dies führte zu Zeitverlust, hohen Kosten, Platzproblemen und letztlich zu einer Verringerung der Produktivität.

Die neue Generation von GPUs wurde entwickelt, um diese Herausforderungen zu bewältigen. Sie bieten hohe Effizienz für umfangreiche Berechnungen und beschleunigen das Training Ihrer KI-Modelle durch Parallelverarbeitung.

Laut einer Studie von Indigo Research können GPUs bei Trainings von neuronalen Netzen im Zusammenhang mit Deep Learning eine 250-mal höhere Leistung als CPUs erzielen.

Mit der Weiterentwicklung des Cloud Computing sind Cloud-GPUs entstanden, die die Welt der Datenwissenschaft und anderer neuer Technologien revolutionieren. Sie bieten noch schnellere Leistung, einfache Wartung, reduzierte Kosten, schnelle Skalierbarkeit und Zeitersparnis.

Dieser Artikel beleuchtet die Konzepte von Cloud-GPUs und deren Bedeutung für KI, ML, Deep Learning. Außerdem werden einige der besten Cloud-GPU-Plattformen vorgestellt, die Sie für Ihre Bedürfnisse in Betracht ziehen können.

Legen wir los!

Was ist eine Cloud-GPU?

Um Cloud-GPUs zu verstehen, betrachten wir zunächst GPUs im Allgemeinen.

Eine Grafikprozessoreinheit (GPU) ist ein spezialisierter elektronischer Schaltkreis, der zur schnellen Veränderung und Bearbeitung von Speicher eingesetzt wird, um die Erstellung von Bildern oder Grafiken zu beschleunigen.

Moderne GPUs sind aufgrund ihrer Parallelstruktur in der Bildverarbeitung und Computergrafik effizienter als zentrale Prozessoren (CPUs). Eine GPU kann entweder auf der Hauptplatine integriert oder auf einer Grafikkarte oder dem CPU-Chip eines Computers platziert sein.

Cloud-Grafikprozessoren (GPUs) sind Computerinstanzen mit robuster Hardwarebeschleunigung, die für die Ausführung von Anwendungen hilfreich sind, um umfangreiche KI- und Deep-Learning-Workloads in der Cloud zu bewältigen. Sie müssen keine physische GPU auf Ihrem Gerät bereitstellen.

Einige bekannte GPU-Marken sind NVIDIA, AMD, Radeon und GeForce.

GPUs werden eingesetzt in:

- Mobiltelefonen

- Spielkonsolen

- Workstations

- Eingebetteten Systemen

- Persönlichen Computern

Wofür werden GPUs verwendet?

Hier einige Anwendungsbereiche von GPUs:

- In KI und ML für Bilderkennung

- Berechnungen für 3D-Computergrafiken und CAD-Zeichnungen

- Textur-Mapping und Rendering von Polygonen

- Geometrische Berechnungen wie Translationen und Rotationen von Scheitelpunkten in Koordinatensysteme

- Unterstützung von programmierbaren Shadern zur Bearbeitung von Texturen und Scheitelpunkten

- GPU-beschleunigte Video-Kodierung, -Dekodierung und -Streaming

- Grafikintensives Gaming und Cloud-Gaming

- Umfangreiche mathematische Modellierung, Analysen und Deep Learning, die die parallele Verarbeitungsfähigkeit von Allzweck-GPUs erfordern

- Videobearbeitung, Grafikdesign und Content-Erstellung

Welche Vorteile bieten Cloud-GPUs?

Die wichtigsten Vorteile der Nutzung von Cloud-GPUs sind:

Hohe Skalierbarkeit

Wenn Ihr Unternehmen wächst, nimmt auch die Arbeitslast zu. Sie benötigen eine GPU, die sich an Ihre steigende Arbeitslast anpassen kann. Cloud-GPUs ermöglichen dies durch das einfache Hinzufügen weiterer GPUs, um Ihre Anforderungen zu erfüllen. Umgekehrt ist auch eine Reduzierung der Kapazität schnell möglich.

Minimierung der Kosten

Anstatt teure physische Hochleistungs-GPUs zu erwerben, können Sie auf Cloud-GPUs zurückgreifen, die stundenweise zu geringeren Kosten verfügbar sind. Sie zahlen nur für die Stunden, in denen Sie die Cloud-GPUs tatsächlich nutzen. Im Vergleich dazu wären physische GPUs, auch bei geringer Auslastung, deutlich teurer.

Schonung lokaler Ressourcen

Cloud-GPUs beanspruchen keine lokalen Ressourcen, anders als physische GPUs, die viel Platz auf Ihrem Computer einnehmen. Zudem wird Ihr Computer bei der Ausführung umfangreicher ML-Modelle oder Rendering-Aufgaben deutlich verlangsamt.

Durch die Auslagerung der Rechenleistung in die Cloud wird Ihr Computer entlastet und kann weiterhin problemlos für andere Aufgaben genutzt werden. Sie steuern alles über Ihren Computer, anstatt ihn mit der gesamten Arbeitslast und Rechenaufgaben zu überlasten.

Zeitersparnis

Cloud-GPUs ermöglichen Designern schnelle Iterationen durch verkürzte Rendering-Zeiten. Aufgaben, die früher Stunden oder Tage dauerten, können nun in Minuten erledigt werden. Dadurch wird die Produktivität Ihres Teams deutlich gesteigert, und Sie können Zeit in Innovation investieren, anstatt in Rendering oder Berechnungen.

Wie unterstützen GPUs Deep Learning und KI?

Deep Learning ist ein grundlegender Bestandteil der künstlichen Intelligenz. Es handelt sich um eine fortschrittliche ML-Technik, die das repräsentative Lernen mithilfe von künstlichen neuronalen Netzen (KNNs) betont. Deep-Learning-Modelle werden zur Verarbeitung großer Datenmengen oder rechenintensiver Prozesse eingesetzt.

Wo kommen nun GPUs ins Spiel?

GPUs sind darauf ausgelegt, parallele Berechnungen, also mehrere Berechnungen gleichzeitig, durchzuführen. Sie nutzen die Fähigkeiten von Deep-Learning-Modellen, um umfangreiche Rechenaufgaben zu beschleunigen.

Dank ihrer zahlreichen Kerne bieten GPUs hervorragende Parallelverarbeitungsberechnungen. Zudem verfügen sie über eine höhere Speicherbandbreite, um riesige Datenmengen für Deep-Learning-Systeme zu bewältigen. Daher werden sie häufig für das Training von KI-Modellen, das Rendern von CAD-Modellen, grafikintensive Videospiele und vieles mehr verwendet.

Wenn Sie gleichzeitig mit mehreren Algorithmen experimentieren möchten, können Sie auch mehrere GPUs parallel betreiben. So lassen sich verschiedene Prozesse auf separaten GPUs ohne gegenseitige Beeinträchtigung durchführen. Sie können mehrere GPUs auf unterschiedlichen physischen Computern oder auf einem einzelnen Computer verwenden, um umfangreiche Datenmodelle zu verarbeiten.

So starten Sie mit Cloud-GPUs

Der Einstieg in Cloud-GPUs ist unkompliziert. Wenn Sie die Grundlagen verstehen, ist alles einfach und schnell. Zunächst müssen Sie einen Cloud-GPU-Anbieter auswählen, z. B. die Google Cloud Platform (GCP).

Melden Sie sich anschließend bei GCP an. Hier können Sie alle damit verbundenen Vorteile nutzen, wie Cloud-Funktionen, Speicheroptionen, Datenbankverwaltung und Integrationen mit Anwendungen. Sie können auch Google Colaboratory verwenden, das wie Jupyter Notebook funktioniert, um kostenlos eine GPU zu nutzen. Schließlich können Sie mit dem Rendering von GPUs für Ihren Anwendungsfall beginnen.

Sehen wir uns nun verschiedene Optionen für Cloud-GPUs an, die Sie für KI und massive Workloads nutzen können.

Linode

Linode bietet On-Demand-GPUs für Parallelverarbeitungs-Workloads wie Videobearbeitung, wissenschaftliches Rechnen, Maschinelles Lernen, KI und mehr. Die GPU-optimierten VMs werden durch NVIDIA Quadro RTX 6000, Tensor- und RT-Kerne beschleunigt und nutzen die CUDA-Leistung, um Raytracing-Workloads, Deep Learning und komplexe Berechnungen auszuführen.

Verwandeln Sie Ihre Investitionen in Betriebskosten, indem Sie die Linode GPU nutzen, um die GPU-Leistung zu nutzen und vom tatsächlichen Wert der Cloud zu profitieren. Zudem können Sie sich mit Linode auf Ihre Kernkompetenzen konzentrieren, anstatt sich um die Hardware zu kümmern.

Linode-GPUs beseitigen die Hürden, um sie für komplexe Anwendungsfälle wie Video-Streaming, KI und Maschinelles Lernen zu nutzen. Darüber hinaus erhalten Sie bis zu 4 Grafikkarten pro Instanz, je nach den Leistungsanforderungen Ihres Workloads.

Die Quadro RTX 6000 verfügt über 4.608 CUDA-Kerne, 576 Tensor-Kerne, 72 RT-Kerne, 24 GB GDDR6-GPU-Speicher, 84T RTX-OPS, 10 Giga Rays/sec Rays Cast und eine FP32-Leistung von 16,3 TFLOPs.

Der Preis für den dedizierten Plus-RTX6000-GPU-Plan beträgt 1,5 $/Stunde.

Paperspace CORE

Optimieren Sie Ihren Workflow mit der beschleunigten Computing-Infrastruktur der nächsten Generation von Paperspace CORE. Es bietet eine benutzerfreundliche Oberfläche, die einfaches Onboarding, Tools für die Zusammenarbeit und Desktop-Apps für Mac, Linux und Windows ermöglicht. Nutzen Sie es, um anspruchsvolle Anwendungen mit unbegrenzter Rechenleistung auszuführen.

CORE bietet ein schnelles Netzwerk, sofortige Bereitstellung, 3D-App-Unterstützung und eine umfassende API für den programmgesteuerten Zugriff. Sie erhalten einen vollständigen Überblick über Ihre Infrastruktur mit einer intuitiven GUI an einem zentralen Ort. Zudem bietet die CORE-Verwaltungsschnittstelle robuste Tools, mit denen Sie Maschinen, Netzwerke und Benutzer filtern, sortieren, verbinden oder erstellen können.

Die leistungsstarke Verwaltungskonsole von CORE führt Aufgaben wie das Hinzufügen der Active Directory-Integration oder VPN schnell aus. Sie können auch komplexe Netzwerkkonfigurationen einfach verwalten und mit wenigen Klicks schneller arbeiten.

Darüber hinaus finden Sie viele optionale Integrationen, die für Ihre Arbeit nützlich sind. Profitieren Sie von erweiterten Sicherheitsfunktionen, freigegebenen Laufwerken und mehr mit dieser Cloud-GPU-Plattform. Nutzen Sie kostengünstige GPUs mit Bildungsrabatten, Abrechnungsbenachrichtigungen und sekundengenauer Abrechnung.

Einfachheit und Geschwindigkeit für Ihren Workflow ab einem Startpreis von 0,07 $/Stunde.

Google Cloud-GPUs

Nutzen Sie leistungsstarke GPUs für wissenschaftliches Rechnen, 3D-Visualisierung und Maschinelles Lernen mit Google Cloud-GPUs. Diese helfen bei der Beschleunigung von HPC, einer breiten Auswahl von GPUs passend zu Preis und Leistung und minimieren die Arbeitslast durch Maschinenanpassungen und flexible Preise.

Es werden verschiedene GPUs wie NVIDIA K80, P4, V100, A100, T4 und P100 angeboten. Zudem gleichen Google Cloud-GPUs Speicher, Prozessor, Hochleistungsfestplatte und bis zu 8 GPUs in jeder Instanz für die individuelle Arbeitslast aus.

Sie erhalten zudem Zugriff auf branchenführende Netzwerke, Datenanalysen und Speicher. GPU-Geräte sind in einigen Regionen nur in bestimmten Zonen verfügbar. Die Preise hängen von der Region, der gewählten GPU und dem Maschinentyp ab. Sie können den Preis mit dem Google Cloud-Preisrechner ermitteln.

Alternativ können Sie sich für diese Lösungen entscheiden:

Elastischer GPU-Dienst

Der Elastische GPU-Dienst (EGS) bietet parallele und leistungsstarke Rechenfunktionen mit GPU-Technologie. Er eignet sich ideal für viele Szenarien wie Videobearbeitung, Visualisierung, wissenschaftliches Rechnen und Deep Learning. EGS verwendet verschiedene GPUs wie NVIDIA Tesla M40, NVIDIA Tesla V100, NVIDIA Tesla P4, NVIDIA Tesla P100 und AMD FirePro S7150.

Sie profitieren von Vorteilen wie Online-Deep-Learning-Inferenzdiensten und -Schulungen, Inhaltsidentifizierung, Bild- und Spracherkennung, HD-Medienkodierung, Videokonferenzen, Reparatur von Filmmaterial und 4K/8K-HD-Live.

Darüber hinaus stehen Optionen wie Video-Rendering, Computational Finance, Klimavorhersage, Kollisionssimulation, Gentechnik, nichtlineare Bearbeitung, Fernunterrichtsanwendungen und Konstruktionsdesign zur Verfügung.

- Die GA1-Instance bietet bis zu 4 AMD FirePro S7150-GPUs, 160 GB Arbeitsspeicher und 56 vCPUs. Sie umfasst 8192 Kerne und 32 GB GPU-Speicher, die parallel arbeiten und 15 TFLOPS mit einfacher Genauigkeit und ein TFLOPS mit doppelter Genauigkeit liefern.

- Die GN4-Instanz bietet bis zu 2 NVIDIA Tesla M40-GPUs, 96 GB Arbeitsspeicher und 56 vCPUs. Sie umfasst 6000 Kerne und 24 GB GPU-Speicher, der 14 TFLOPS mit einfacher Genauigkeit liefert. Es gibt auch viele andere Instanzen wie GN5, GN5i und GN6.

- EGS unterstützt intern 25 Gbit/s und bis zu 2.000.000 PPS Netzwerkbandbreite, um die von den Rechenknoten benötigte maximale Netzwerkleistung bereitzustellen. Es verfügt über einen lokalen Hochgeschwindigkeits-Cache, der mit SSD- oder Ultra-Cloud-Festplatten verbunden ist.

- Leistungsstarke NVMe-Laufwerke verarbeiten 230.000 IOPS mit einer E/A-Latenz von 200 µs und bieten eine Lesebandbreite von 1900 Mbit/s und eine Schreibbandbreite von 1100 Mbit/s.

Sie können je nach Bedarf aus verschiedenen Kaufoptionen wählen, um die Ressourcen zu erhalten, und nur dafür bezahlen.

Azure N-Serie

Die Azure N-Serie der Azure Virtual Machines (VMs) verfügt über GPU-Funktionen. GPUs eignen sich ideal für grafik- und rechenintensive Workloads und helfen Anwendern, Innovationen durch verschiedene Szenarien wie Deep Learning, Predictive Analytics und Remote-Visualisierung voranzutreiben.

Verschiedene N-Serien haben spezifische Angebote für bestimmte Workloads.

- Die NC-Serie konzentriert sich auf leistungsstarkes Maschinelles Lernen und Computing-Workloads. Die neueste Version ist NCsv3, die NVIDIAs Tesla V100-GPU verwendet.

- Die ND-Serie konzentriert sich auf Inferenz- und Trainingsszenarien, insbesondere für Deep Learning. Sie verwendet NVIDIA Tesla P40-GPUs. Die neueste Version ist NDv2 mit NVIDIA Tesla V100-GPUs.

- Die NV-Serie konzentriert sich auf Remote-Visualisierung und andere intensive Anwendungsworkloads, die von der NVIDIA Tesla M60-GPU unterstützt werden.

- Die NC-, NCsv3-, NDs- und NCsv2-VMs bieten eine InfiniBand-Verbindung, die skalierbare Leistung ermöglicht. Hier erhalten Sie Vorteile für Deep Learning, Grafik-Rendering, Videobearbeitung, Spiele usw.

IBM Cloud

IBM Cloud bietet Flexibilität, Leistung und eine Vielzahl von GPU-Optionen. Da GPUs die zusätzliche Intelligenz liefern, die einer CPU fehlt, unterstützt Sie IBM Cloud dabei, direkten Zugriff auf die optimale Serverauswahl für eine nahtlose Integration mit der IBM Cloud-Architektur, Anwendungen und APIs zu erhalten, sowie ein verteiltes Netzwerk von Rechenzentren weltweit.

- Sie erhalten Bare-Metal-Server-GPU-Optionen wie Intel Xeon 4210, NVIDIA T4-Grafikkarte, 20 Kerne, 32 GB RAM, 2,20 GHz und 20 TB Bandbreite. Ähnliche Optionen sind für Intel Xeon 5218 und Intel Xeon 6248 verfügbar.

- Für virtuelle Server erhalten Sie AC1.8×60 mit acht vCPUs, 60 GB RAM und 1 x P100-GPU. Hier stehen auch Optionen wie AC2.8×60 zur Verfügung.

Die Bare-Metal-Server-GPU beginnt bei 819 $/Monat, die virtuelle Server-GPU bei 1,95 $/Stunde.

AWS und NVIDIA

AWS und NVIDIA haben sich zusammengetan, um kontinuierlich kostengünstige, flexible und leistungsstarke GPU-basierte Lösungen bereitzustellen. Dies beinhaltet NVIDIA-GPU-gesteuerte Amazon EC2-Instances und Dienste wie AWS IoT Greengrass, das mit NVIDIA Jetson Nano-Modulen eingesetzt wird.

Benutzer setzen AWS und NVIDIA für virtuelle Workstations, Maschinelles Lernen (ML), IoT-Dienste und Hochleistungs-Computing ein. Die von NVIDIA-GPUs angetriebenen Amazon EC2-Instances sind für die Bereitstellung skalierbarer Leistung zuständig. Zudem nutzen Sie AWS IoT Greengrass, um die AWS Cloud-Dienste auf NVIDIA-basierte Edge-Geräte auszuweiten.

Die NVIDIA A100 Tensor Core-GPUs versorgen die Amazon EC2 P4d-Instances mit branchenführenden Netzwerken mit geringer Latenz und hohem Durchsatz. Auch für andere Szenarien gibt es passende Instanzen wie Amazon EC2 P3, Amazon EC2 G4 usw.

Testen Sie die Leistung der GPU-Cloud mit einer KOSTENLOSEN Testversion.

OVHcloud

OVHcloud stellt Cloud-Server bereit, die für die Verarbeitung umfangreicher paralleler Workloads optimiert sind. Die GPUs verfügen über eine Reihe von Instanzen, die in NVIDIA Tesla V100-Grafikprozessoren integriert sind, um den Anforderungen von Deep Learning und Maschinellem Lernen gerecht zu werden.

Sie unterstützen die Beschleunigung der Datenverarbeitung in den Bereichen grafische Datenverarbeitung und künstliche Intelligenz. OVH arbeitet mit NVIDIA zusammen, um eine optimale GPU-beschleunigte Plattform für Hochleistungs-Computing, KI und Deep Learning bereitzustellen.

Nutzen Sie die einfachste Möglichkeit, GPU-beschleunigte Container über einen vollständigen Katalog bereitzustellen und zu verwalten. Es wird eine von vier Karten direkt über PCI-Passthrough ohne Virtualisierungsebene an die Instanzen geliefert, um alle Ressourcen optimal zu nutzen.

Die Dienste und Infrastrukturen von OVHcloud sind nach ISO/IEC 27017, 27001, 27701 und 27018 zertifiziert. Diese Zertifizierungen belegen, dass OVHcloud ein Informationssicherheitsmanagementsystem (ISMS) zur Verwaltung von Schwachstellen, zur Implementierung von Geschäftskontinuität, zur Steuerung von Risiken und ein Datenschutzinformationsmanagementsystem (PIMS) einsetzt.

Darüber hinaus bietet NVIDIA Tesla V100 viele wertvolle Funktionen wie PCIe 32 GB/s, 16 GB HBM2 Kapazität, 900 GB/s Bandbreite, Double Precision – 7 TeraFLOPs, Single Precision – 14 TeraFLOPs und Deep Learning – 112 TeraFLOPs.

Lambda-GPU

Trainieren Sie Deep-Learning-, ML- und KI-Modelle mit der Lambda GPU Cloud und skalieren Sie mit wenigen Klicks von einer Maschine auf eine beliebige Anzahl von VMs. Nutzen Sie vorinstallierte Hauptframeworks und die neueste Version des Lambda-Stacks, die CUDA-Treiber und Deep-Learning-Frameworks enthält.

Greifen Sie über das Dashboard schnell auf die dedizierte Jupyter Notebook-Entwicklungsumgebung für jeden Computer zu. Verwenden Sie SSH direkt mit einem der SSH-Schlüssel oder verbinden Sie sich über das Webterminal im Cloud-Dashboard für direkten Zugriff.

Jede Instanz unterstützt eine maximale Bandbreite von 10 Gbit/s zwischen den Knoten, was ein verteiltes Training mit Frameworks wie Horovod ermöglicht. Sie können auch Zeit bei der Modelloptimierung sparen, indem Sie die Anzahl der GPUs auf einzelnen oder vielen Instanzen skalieren.

Mit der Lambda GPU Cloud können Sie sogar 50 % der Rechenkosten einsparen, die Cloud-TCO reduzieren und erhalten keine mehrjährigen Verpflichtungen. Nutzen Sie eine einzelne RTX 6000-GPU mit sechs vCPUs, 46 GiB RAM und 658 GiB temporärem Speicher für nur 1,25 $/Stunde. Wählen Sie je nach Bedarf aus einer Vielzahl von Instanzen, um einen bedarfsgerechten Preis für Ihre Nutzung zu erhalten.

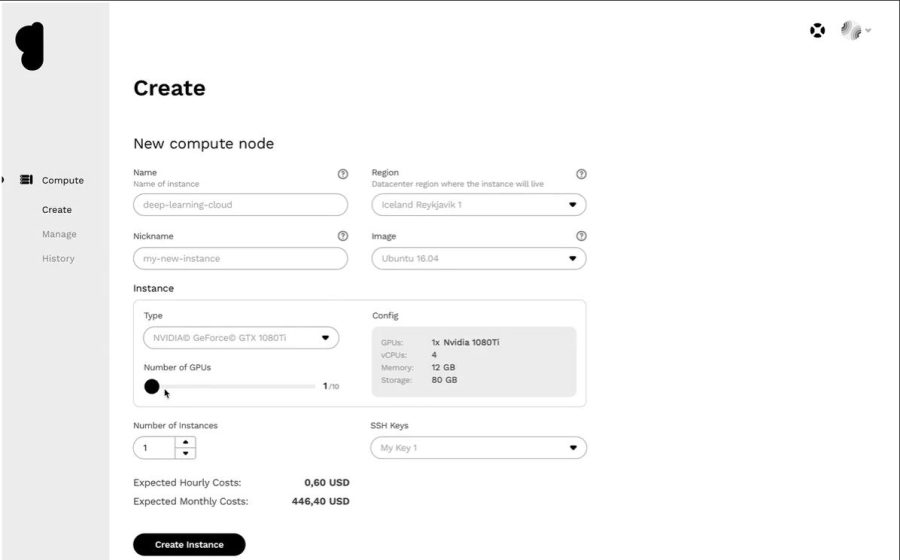

Genesis Cloud

Nutzen Sie eine effiziente Cloud-GPU-Plattform zu einem günstigen Preis von Genesis Cloud. Sie haben Zugriff auf viele effiziente Rechenzentren auf der ganzen Welt, mit denen sie zusammenarbeiten, um eine breite Palette von Anwendungen bereitzustellen.

Alle Dienste sind sicher, skalierbar, robust und automatisiert. Genesis Cloud bietet unbegrenzte GPU-Rechenleistung für visuelle Effekte, Maschinelles Lernen, Transkodierung oder Speicherung, Big-Data-Analysen und vieles mehr.

Genesis Cloud bietet viele kostenlose Funktionen, wie z.B. Snapshots zum Speichern Ihrer Arbeit, Sicherheitsgruppen für den Netzwerkverkehr, Speichervolumes für große Datenmengen, FastAI, PyTorch, vorkonfigurierte Images und eine öffentliche API für TensorFlow.

Es werden NVIDIA- und AMD-GPUs verschiedener Typen eingesetzt. Nutzen Sie die Leistung von GPU-Computing, um neuronale Netze zu trainieren oder Animationsfilme zu erstellen. Die Rechenzentren werden mit 100% erneuerbarer Energie aus geothermischen Quellen betrieben, um die CO2-Emissionen zu senken.

Die Preise sind 85 % niedriger als bei anderen Anbietern und die Abrechnung erfolgt minutengenau. Zudem können Sie mit langfristigen und präemptiven Rabatten weitere Kosten einsparen.

Fazit

Cloud-GPUs sind darauf ausgelegt, eine herausragende Leistung, Geschwindigkeit, Skalierbarkeit, Speicherplatz und Komfort zu bieten. Wählen Sie daher die für Ihre Bedürfnisse passende Cloud-GPU-Plattform mit den erforderlichen Funktionen, um Ihre Deep-Learning-Modelle zu beschleunigen und KI-Workloads einfach zu bewältigen.