Vergessen Sie den Erwerb einer separaten Grafikkarte, bald werden Sie auch ohne sie spielen können. Zumindest, wenn Sie zu den ungefähr 90% der Spieler gehören, die gegenwärtig noch mit 1080p oder einer geringeren Auflösung spielen. Die jüngsten Fortschritte bei Intel und AMD deuten darauf hin, dass ihre integrierten Grafikeinheiten (iGPUs) den Markt für Einstiegsgrafikkarten grundlegend verändern werden.

Weshalb sind integrierte Grafikeinheiten (iGPUs) eigentlich so langsam?

Dafür gibt es im Wesentlichen zwei Hauptursachen: die Speicheranbindung und die Chipgröße.

Der Speicheraspekt ist relativ einfach zu verstehen: Eine schnellere Speicheranbindung führt zu einer gesteigerten Performance. iGPUs profitieren jedoch nicht von hochmodernen Speichertechnologien wie GDDR6 oder HBM2. Stattdessen müssen sie den Arbeitsspeicher des Systems gemeinsam mit den anderen Computerkomponenten nutzen. Dies ist primär darauf zurückzuführen, dass es kostspielig ist, derartigen Speicher direkt auf dem Chip zu integrieren, und iGPUs sind in der Regel auf preisbewusste Nutzer ausgerichtet. Dies wird sich nach aktuellem Kenntnisstand wahrscheinlich nicht grundlegend ändern, aber die Weiterentwicklung von Speichercontrollern, die schnellere Speichernutzung ermöglichen, könnte die Performance von iGPUs in zukünftigen Generationen verbessern.

Die zweite Ursache, die Chipgröße, erfährt im Jahr 2019 eine Veränderung. GPU-Chips sind im Vergleich zu CPUs großflächig, und diese großen Chips stellen ein Problem in der Siliziumherstellung dar. Das hängt mit der Fehlerquote zusammen. Eine größere Fläche bedeutet eine höhere Wahrscheinlichkeit für Defekte, und ein Defekt im Chip kann die gesamte CPU unbrauchbar machen.

Wie Sie im folgenden (hypothetischen) Beispiel sehen, führt eine Verdopplung der Chipgröße zu einer deutlich geringeren Ausbeute, da jeder Defekt einen viel größeren Bereich betrifft. Abhängig von der Position der Defekte kann dies eine ganze CPU unbrauchbar machen. Dieses Beispiel ist nicht übertrieben. Je nach CPU kann die integrierte Grafikeinheit fast die Hälfte des Chips belegen.

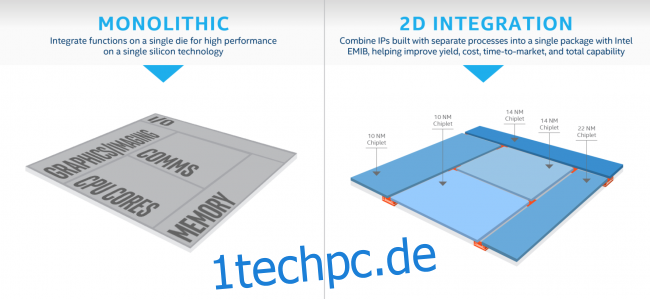

Die Fläche auf einem Chip ist teuer und wird an diverse Komponentenhersteller verkauft. Es ist daher schwierig zu argumentieren, viel Fläche in eine verbesserte iGPU zu investieren, wenn diese Fläche auch zur Erweiterung der Kernanzahl oder für andere Funktionen verwendet werden könnte. Es ist nicht so, dass die Technologie nicht vorhanden wäre. Wenn Intel oder AMD einen Chip mit 90% GPU-Anteil produzieren wollten, könnten sie dies tun, jedoch wären die Erträge mit einem monolithischen Design so gering, dass es sich nicht lohnen würde.

Die Lösung: Chiplets

Sowohl Intel als auch AMD haben ihre Strategien offengelegt, und diese ähneln sich stark. Da die neuesten Prozessknoten höhere Fehlerraten aufweisen als üblich, haben beide Unternehmen beschlossen, ihre Chips zu zerlegen und anschließend wieder zusammenzusetzen. Die genaue Umsetzung ist unterschiedlich, aber in beiden Fällen bedeutet dies, dass das Problem der Chipgröße nicht mehr so gravierend ist, da sie den Chip in kleineren, kostengünstigeren Teilen herstellen und diese dann im fertigen CPU-Modul wieder zusammensetzen können.

Bei Intel scheint dies vor allem eine Maßnahme zur Kostensenkung zu sein. Es scheint keine tiefgreifenden Veränderungen an der Architektur vorzunehmen, sondern ermöglicht ihnen lediglich, für jeden CPU-Bestandteil den optimalen Knoten auszuwählen. Es gibt jedoch Hinweise darauf, dass sie die iGPU-Kapazität erweitern möchten. Das kommende Gen11-Modell soll „64 verbesserte Ausführungseinheiten haben, mehr als das Doppelte der vorherigen Intel Gen9-Grafik (24 EUs), um die 1 TFLOPS-Grenze zu durchbrechen“. Ein einzelner TFLOP ist nicht besonders viel, da die Vega-11-Grafik im Ryzen 2400G bereits 1,7 TFLOPS erreicht. Die iGPUs von Intel blieben jedoch notorisch hinter denen von AMD zurück, weshalb jeder Fortschritt positiv zu bewerten ist.

Ryzen APUs könnten den Markt aufmischen

AMD, der Eigentümer von Radeon, dem zweitgrößten GPU-Hersteller, integriert diese Technologie in seine Ryzen APUs. Mit den in Aussicht stehenden 7-nm-Fortschritten sieht die Zukunft für sie vielversprechend aus. Ihre kommenden Ryzen-Chips sollen Chiplets verwenden, jedoch in einer anderen Art als bei Intel. AMD verwendet separate Chiplets, die über ihre vielseitige „Infinity Fabric“-Verbindung zusammenarbeiten. Dieses System erlaubt eine höhere Modularität als Intels Lösung, jedoch mit einer geringfügig erhöhten Latenz. Chiplets wurden bereits sehr erfolgreich bei ihren 64-Kern Epyc CPUs eingesetzt, die Anfang November angekündigt wurden.

Nach einigen aktuellen Leaks wird AMDs kommende Zen-2-Serie den 3300G umfassen. Dieser Chip soll einen Achtkern-CPU-Chiplet und einen Navi-20-Chiplet (deren kommende Grafikarchitektur) kombinieren. Sollten diese Gerüchte zutreffen, könnte dieser einzelne Chip die Einstiegsgrafikkarten obsolet machen. Der 2400G mit Vega-11-Recheneinheiten erzielt in den meisten Spielen bereits spielbare Frameraten bei 1080p, und der 3300G soll angeblich fast doppelt so viele Recheneinheiten sowie eine neuere, schnellere Architektur besitzen.

Dies ist nicht nur reine Spekulation. Das Design ermöglicht es AMD, im Grunde genommen jede beliebige Anzahl von Chiplets zu verbinden. Die einzigen einschränkenden Faktoren sind die Leistung und der Platz im Gehäuse. Sie werden sehr wahrscheinlich zwei Chiplets pro CPU verwenden. Um die beste integrierte Grafikkarte der Welt zu entwickeln, müssten sie lediglich einen dieser Chiplets durch eine leistungsfähige GPU ersetzen. Es gibt auch einen guten Grund für dieses Vorgehen, da dies nicht nur für PC-Spiele, sondern auch für Konsolen wegweisend wäre, da sie die APUs für die Xbox One- und PS4-Serien produzieren.

Sie könnten sogar etwas schnelleren Grafikspeicher als eine Art L4-Cache verwenden, aber es ist wahrscheinlicher, dass sie wieder den System-RAM nutzen werden und darauf hoffen, den Speichercontroller der Ryzen-Produkte der dritten Generation optimieren zu können.

Wie auch immer die Entwicklung verläuft, sowohl das blaue als auch das rote Team haben nun wesentlich mehr Möglichkeiten, an ihren Chips zu arbeiten. Dies wird sicherlich zu einigen Verbesserungen führen. Aber vielleicht konzentrieren sich beide Teams auch einfach auf die Integration möglichst vieler CPU-Kerne und versuchen, das Mooresche Gesetz noch etwas länger aufrechtzuerhalten.