Im heutigen digitalen Zeitalter wächst die Datenmenge exponentiell an, und wir sprechen von Terabytes und Petabytes. Doch wie können wir diese Datenmassen sinnvoll nutzen und in nützliche Informationen umwandeln, um die Serviceverfügbarkeit zu verbessern?

Unternehmen benötigen vor allem valide, innovative und verständliche Daten für ihre Wissensentdeckungsmodelle.

Aus diesem Grund setzen Unternehmen auf vielfältige Analysemethoden, um qualitativ hochwertige Daten zu gewinnen.

Aber wo beginnt dieser Prozess? Die Antwort lautet: beim Data Wrangling.

Legen wir los!

Was genau ist Data Wrangling?

Data Wrangling bezeichnet den Prozess der Bereinigung, Strukturierung und Transformation von Rohdaten in Formate, die Datenanalyseprozesse erleichtern. Oftmals beinhaltet dies die Arbeit mit unübersichtlichen und komplexen Datensätzen, die für herkömmliche Datenpipelines nicht geeignet sind. Das Ziel ist es, Rohdaten in einen verfeinerten Zustand zu überführen oder bereits verfeinerte Daten für den produktiven Einsatz zu optimieren.

Typische Aufgaben beim Data Wrangling sind:

- Das Zusammenführen verschiedener Datensätze zu einem umfassenden Datensatz für Analysezwecke.

- Die Identifizierung und Behandlung fehlender oder lückenhafter Daten.

- Das Entfernen von Ausreißern oder Anomalien in Datensätzen.

- Die Standardisierung von Eingaben.

Die großen Datenmengen, die bei Data-Wrangling-Prozessen anfallen, lassen sich in der Regel nicht manuell optimieren, sondern erfordern automatisierte Methoden der Datenvorbereitung, um präzisere und qualitativ hochwertigere Ergebnisse zu erzielen.

Die Ziele des Data Wranglings

Neben dem Hauptziel der Datenaufbereitung für Analysen, verfolgt Data Wrangling weitere wichtige Ziele:

- Die Generierung valider und innovativer Daten aus unstrukturierten Rohdaten, um die Entscheidungsfindung in Unternehmen zu verbessern.

- Die Standardisierung von Rohdaten in Formate, die von Big-Data-Systemen verarbeitet werden können.

- Die Reduzierung des Zeitaufwands für Datenanalysten bei der Erstellung von Datenmodellen durch die Bereitstellung strukturierter Daten.

- Die Sicherstellung von Konsistenz, Vollständigkeit, Benutzerfreundlichkeit und Sicherheit für jeden Datensatz, der in einem Data Warehouse verwendet oder gespeichert wird.

Gängige Methoden des Data Wranglings

Entdeckung

Bevor Dateningenieure mit der Datenaufbereitung beginnen, müssen sie verstehen, wie die Daten gespeichert sind, welche Größe sie haben, welche Datensätze vorhanden sind, welche Codierungsformate verwendet wurden und weitere Attribute, die einen Datensatz beschreiben.

Strukturierung

Dieser Prozess umfasst die Organisation von Daten in leicht verwendbare Formate. Rohdatensätze müssen möglicherweise hinsichtlich der Spaltendarstellung, Zeilenanzahl und Optimierung anderer Datenattribute strukturiert werden, um die Analyse zu vereinfachen.

Bereinigung

Strukturierte Datensätze müssen von inhärenten Fehlern und allem, was die Datenqualität beeinträchtigen könnte, befreit werden. Dies beinhaltet das Entfernen doppelter Einträge, das Löschen leerer Zellen und Ausreißerdaten, die Standardisierung von Eingaben, das Umbenennen verwirrender Attribute und mehr.

Anreicherung

Nachdem die Daten die Strukturierungs- und Bereinigungsphase durchlaufen haben, ist es notwendig, den Nutzen der Daten zu bewerten und sie gegebenenfalls mit Werten aus anderen Datensätzen zu ergänzen, falls die gewünschte Datenqualität noch nicht erreicht ist.

Validierung

Der Validierungsprozess umfasst iterative Programmieraufgaben, die Aufschluss über die Datenqualität, Konsistenz, Benutzerfreundlichkeit und Sicherheit geben. Diese Phase stellt sicher, dass alle Transformationsaufgaben erfüllt sind und die Datensätze für Analyse- und Modellierungsphasen bereit sind.

Präsentation

Nach Abschluss aller Phasen werden die aufbereiteten Datensätze innerhalb einer Organisation zur Analyse bereitgestellt. In dieser Phase werden auch die Dokumentation der Vorbereitungsschritte und alle Metadaten, die während des Wrangling-Prozesses generiert wurden, geteilt.

Talend

Talend ist eine umfassende Datenmanagement-Plattform, die in drei Hauptbereiche unterteilt ist, um zuverlässige und konsistente Daten bereitzustellen. Talend bietet Datenintegration, Anwendungs- und API-Integration sowie Datenintegrität und -verwaltung. Data Wrangling in Talend erfolgt über ein browserbasiertes Point-and-Click-Tool, das die Stapel-, Massen- und Live-Datenaufbereitung ermöglicht, einschließlich Datenprofilierung, -bereinigung und -dokumentation.

Talend Data Fabric verarbeitet jede Phase des Datenlebenszyklus und sorgt für ein ausgewogenes Verhältnis von Datenverfügbarkeit, Benutzerfreundlichkeit, Sicherheit und Integrität aller Unternehmensdaten.

Haben Sie sich jemals Sorgen über Ihre verschiedenen Datenquellen gemacht? Der einheitliche Ansatz von Talend ermöglicht eine schnelle Datenintegration aus all Ihren Datenquellen (Datenbanken, Cloud-Speicher und API-Endpunkte) und erlaubt die Transformation und Zuordnung aller Daten mit nahtlosen Qualitätsprüfungen.

Die Datenintegration in Talend wird durch Self-Service-Tools wie Konnektoren ermöglicht, die es Entwicklern gestatten, Daten aus beliebigen Quellen automatisch aufzunehmen und die Daten angemessen zu kategorisieren.

Funktionen von Talend

Universelle Datenintegration

Talend ermöglicht Unternehmen die Verarbeitung jedes Datentyps aus verschiedenen Datenquellen – ob Cloud- oder On-Premise-Umgebungen.

Flexibilität

Talend ist unabhängig von Anbietern oder Plattformen, wenn es darum geht, Datenpipelines aus Ihren integrierten Daten zu erstellen. Sobald Sie Datenpipelines aus Ihren erfassten Daten erstellt haben, ermöglicht Talend Ihnen die Ausführung der Pipelines an jedem beliebigen Ort.

Datenqualität

Mit Funktionen des maschinellen Lernens wie Datendeduplizierung, Validierung und Standardisierung bereinigt Talend die aufgenommenen Daten automatisch.

Unterstützung für Anwendungs- und API-Integrationen

Nachdem Ihre Daten mit den Talend-Self-Service-Tools verarbeitet und verstanden wurden, können Sie Ihre Daten über benutzerfreundliche APIs teilen. Talend API-Endpunkte können Ihre Datenbestände über fortschrittliche Datenzuordnungs- und Transformationstools für SaaS-, JSON-, AVRO- und B2B-Plattformen zugänglich machen.

R

R ist eine ausgereifte und effektive Programmiersprache für die explorative Datenanalyse, sowohl in wissenschaftlichen als auch in geschäftlichen Anwendungen.

R wurde als freie Software für statistische Berechnungen und Grafiken entwickelt und ist sowohl eine Sprache als auch eine Umgebung für Datenverarbeitung, Modellierung und Visualisierung. Die R-Umgebung bietet eine Vielzahl von Softwarepaketen, während die R-Sprache eine Reihe statistischer, Clustering-, Klassifizierungs-, Analyse- und grafischer Techniken integriert, die bei der Datenmanipulation helfen.

Eigenschaften von R

Umfangreiche Paketbibliothek

Dateningenieuren stehen mehr als 10.000 standardisierte Pakete und Erweiterungen aus dem Comprehensive R Archive Network (CRAN) zur Verfügung. Dies erleichtert die Datenaufbereitung und -analyse erheblich.

Hohe Leistungsfähigkeit

Mit den verfügbaren Paketen für verteiltes Rechnen kann R innerhalb von Sekunden komplexe und einfache Manipulationen (mathematische und statistische) an Datenobjekten und Datensätzen durchführen.

Plattformübergreifende Unterstützung

R ist plattformunabhängig und kann auf verschiedenen Betriebssystemen ausgeführt werden. Es ist zudem mit anderen Programmiersprachen kompatibel, was bei rechenintensiven Aufgaben von Vorteil ist.

Der Einstieg in R ist einfach.

Trifacta

Trifacta ist eine interaktive Cloud-Umgebung für die Datenprofilerstellung, die auf Modellen des maschinellen Lernens und Analysen basiert. Dieses Data-Engineering-Tool zielt darauf ab, verständliche Daten zu erstellen, unabhängig davon, wie unübersichtlich oder komplex die Datensätze sind. Benutzer können doppelte Einträge entfernen und leere Zellen in Datensätzen durch Deduplizierungs- und lineare Transformationen auffüllen.

Dieses Daten-Wrangling-Tool erkennt Ausreißer und ungültige Daten in jedem Datensatz. Mit einfachen Drag-and-Drop-Aktionen werden vorhandene Daten klassifiziert und mithilfe von Vorschlägen, die durch maschinelles Lernen unterstützt werden, intelligent transformiert, um die Datenaufbereitung zu beschleunigen.

Das Data Wrangling in Trifacta erfolgt durch überzeugende visuelle Profile, die sowohl technisch versierte als auch nicht-technische Mitarbeiter ansprechen. Trifacta legt großen Wert auf sein benutzerfreundliches Design mit visualisierten und intelligenten Transformationen.

Egal, ob Daten aus Data Marts, Data Warehouses oder Data Lakes stammen, die Benutzer sind von der Komplexität der Datenaufbereitung abgeschirmt.

Eigenschaften von Trifacta

Nahtlose Cloud-Integrationen

Unterstützt Vorbereitungs-Workloads in allen Cloud- oder Hybridumgebungen, so dass Entwickler Datensätze unabhängig von ihrem Standort zur Aufbereitung aufnehmen können.

Verschiedene Datenstandardisierungsmethoden

Trifacta Wrangler bietet verschiedene Mechanismen zur Mustererkennung in Daten und zur Standardisierung der Ausgaben. Dateningenieure können die Standardisierung nach Mustern, nach Funktionen oder in Kombination wählen.

Einfache Arbeitsabläufe

Trifacta organisiert Datenaufbereitungsaufgaben in Form von Flows. Ein Flow enthält einen oder mehrere Datensätze sowie die zugehörigen Schemata (definierte Schritte, die Daten transformieren).

Ein Flow reduziert daher den Zeitaufwand für Entwickler beim Importieren, Wrangling, Profiling und Exportieren von Daten.

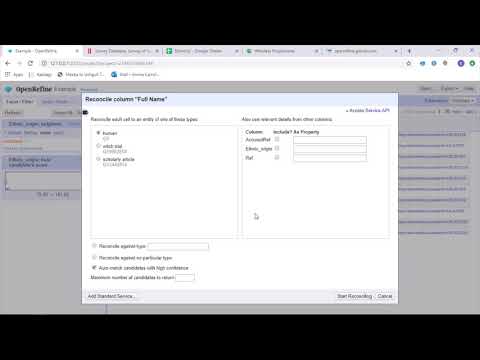

OpenRefine

OpenRefine ist ein ausgereiftes Open-Source-Tool für die Arbeit mit unübersichtlichen Daten. Als Datenbereinigungstool untersucht OpenRefine Datensätze in Sekundenschnelle und wendet komplexe Zelltransformationen an, um die gewünschten Datenformate darzustellen.

OpenRefine nähert sich dem Data Wrangling durch Filter und Partitionen auf Datensätzen unter Verwendung regulärer Ausdrücke. Mithilfe der integrierten General Refine Expression Language können Dateningenieure Daten mithilfe von Facetten, Filtern und Sortiertechniken untersuchen und visualisieren, bevor sie erweiterte Datenoperationen für Entitätsextraktionen durchführen.

OpenRefine ermöglicht es Benutzern, an Daten als Projekten zu arbeiten, bei denen Datensätze aus verschiedenen Computerdateien, Web-URLs und Datenbanken in solche Projekte importiert werden können, die lokal auf den Computern der Benutzer ausgeführt werden.

Mithilfe von Ausdrücken können Entwickler die Datenbereinigung und -transformation erweitern, um Aufgaben wie das Aufteilen/Verbinden von Mehrwertzellen, das Anpassen von Facetten und das Abrufen von Daten aus Spalten unter Verwendung externer URLs durchzuführen.

Funktionen von OpenRefine

Plattformübergreifendes Tool

OpenRefine ist kompatibel mit Windows-, Mac- und Linux-Betriebssystemen und kann über herunterladbare Installationsprogramme verwendet werden.

Umfangreiche API

Bietet eine OpenRefine-API, Datenerweiterungs-API, Abstimmungs-API und andere APIs, die die Interaktion der Benutzer mit den Daten unterstützen.

Datameer

Datameer ist ein SaaS-Datentransformationstool, das die Datenverarbeitung und -integration durch Softwareentwicklungsprozesse vereinfachen soll. Datameer ermöglicht das Extrahieren, Transformieren und Laden von Datensätzen in Cloud-Data-Warehouses wie Snowflake.

Dieses Data-Wrangling-Tool ist gut geeignet für standardmäßige Datensatzformate wie CSV und JSON, so dass Ingenieure Daten in verschiedenen Formaten zur Aggregation importieren können.

Datameer bietet eine katalogähnliche Datendokumentation, tiefgreifende Datenprofilerstellung und Erkennung, um alle Anforderungen an die Datentransformation zu erfüllen. Das Tool führt ein tiefes visuelles Datenprofil durch, das es Benutzern ermöglicht, ungültige, fehlende oder abgelegene Felder und Werte sowie die Gesamtform der Daten zu verfolgen.

Datameer läuft auf einem skalierbaren Data Warehouse und transformiert Daten für aussagekräftige Analysen durch effiziente Datenstapel und Excel-ähnliche Funktionen.

Datameer bietet eine Hybrid-, Code- und No-Code-Benutzeroberfläche, um eine breite Palette von Datenanalyseteams anzusprechen und die einfache Erstellung komplexer ETL-Pipelines zu ermöglichen.

Funktionen von Datameer

Verschiedene Benutzerumgebungen

Bietet Datentransformationsumgebungen für mehrere Anwendertypen – Low-Code, Code und Hybrid – um technisch versierte und nicht-technisch versierte Personen zu unterstützen.

Gemeinsame Arbeitsbereiche

Datameer ermöglicht es Teams, Modelle wiederzuverwenden und zusammenzuarbeiten, um Projekte zu beschleunigen.

Umfassende Datendokumentation

Datameer unterstützt sowohl die system- als auch benutzergenerierte Datendokumentation durch Metadaten und Beschreibungen, Tags und Kommentare im Wiki-Stil.

Abschließende Gedanken 👩🏫

Data Analytics ist ein komplexer Prozess, der eine angemessene Organisation der Daten erfordert, um aussagekräftige Schlussfolgerungen zu ziehen und Vorhersagen zu treffen. Data-Wrangling-Tools helfen Ihnen, große Mengen an Rohdaten zu formatieren, um Sie bei der Durchführung erweiterter Analysen zu unterstützen. Wählen Sie das beste Tool, das Ihren Bedürfnissen entspricht, und werden Sie zum Analytics-Profi!

Vielleicht interessiert Sie auch:

Die besten CSV-Tools zum Konvertieren, Formatieren und Validieren.