Deepfakes verstehen und mit Faceswap selbst erstellen

Künstliche Intelligenz hat sich rasant entwickelt und ist nicht mehr nur eine abstrakte Idee. Sie ist zu einer Realität geworden, die uns Menschen in vielerlei Hinsicht näherkommt.

KI kann heutzutage Texte verfassen, Kunst erschaffen und sogar täuschend echt wie ein Mensch aussehen und sprechen. Das ist eine bemerkenswerte Entwicklung, die wir nutzen sollten, aber auch mit Vorsicht genießen müssen.

Was genau sind Deepfakes?

Der Begriff „Deepfake“ setzt sich aus „Deep Learning“ und „Fake“ zusammen. Im Grunde handelt es sich um Medien, die durch den Einsatz von KI-Technologie täuschend echt gefälscht oder manipuliert wurden.

Laut Wikipedia werden Deepfakes auch als synthetische Medien bezeichnet. Dabei wird ein bereits existierendes Bild, eine Audioaufnahme oder ein Video so verändert, dass es eine völlig andere Person oder Szene darstellt.

Oft werden Deepfakes eingesetzt, um bekannte Persönlichkeiten etwas sagen zu lassen, was sie im wahren Leben nie äußern würden.

Je nach den Fähigkeiten des Erstellers kann es extrem schwerfallen, zwischen einem echten und einem gefälschten Medium zu unterscheiden.

Wie Deepfakes funktionieren

Vereinfacht gesagt, wird in einem Video ein Teil des Originals, wie z.B. das Gesicht, durch eine täuschend ähnliche Fälschung ersetzt. Man könnte diesen Vorgang auch als „Faceswap“ bezeichnen, wie es beispielsweise bei dem bekannten „Obama“-Video der Fall war.

Es gibt aber nicht nur Deepfake-Videos. Auch Bilder und Audioaufnahmen können gefälscht werden, und wer weiß, vielleicht werden in naher Zukunft sogar Deepfake-VR-Avatare Realität.

Quelle: Disney

Die genaue Funktionsweise solcher Manipulationen hängt hauptsächlich von der verwendeten Software und dem zugrundeliegenden Algorithmus ab.

Ein Forschungsbericht von Disney zeigt, dass verschiedene Techniken zum Einsatz kommen, wie Encoder-Decoder, Generative Adversarial Networks (GANs) und geometriebasierte Deepfakes.

Die folgenden Abschnitte konzentrieren sich jedoch hauptsächlich auf die Funktionsweise von Faceswap. Dies ist eine kostenlose Open-Source-Software für Deepfakes, die verschiedene Algorithmen verwendet, um das gewünschte Ergebnis zu erzielen.

Es gibt drei grundlegende Schritte bei der Erstellung von Deepfakes: Extraktion, Training und Konvertierung.

#1. Extraktion

Bei der Extraktion geht es darum, den relevanten Bereich, also beispielsweise ein Gesicht, aus den Medien (Original und dem zur Ersetzung verwendeten Material) herauszufiltern.

Je nach verwendeter Hardware können verschiedene Algorithmen für eine effiziente Erkennung eingesetzt werden.

Faceswap bietet beispielsweise verschiedene Optionen für die Extraktion, Ausrichtung und Maskierung, die auf der Effizienz von CPU oder GPU basieren.

Während der Extraktion wird das Gesicht im Video identifiziert. Die Ausrichtung erfasst wichtige Merkmale des Gesichts, wie Augen, Nase und Kinn. Schließlich werden durch die Maskierung alle Bereiche des Bildes außer dem relevanten Bereich blockiert.

Bei der Auswahl der Extraktionsoptionen ist die benötigte Zeit ein wichtiger Faktor, da rechenintensive Algorithmen auf weniger leistungsfähiger Hardware zu Fehlern oder einer langen Verarbeitungszeit führen können, bis akzeptable Ergebnisse erzielt werden.

Neben der Hardware spielen auch andere Parameter eine Rolle, z.B. ob das Video durch Gesichtsbewegungen, Brillen oder andere Hindernisse beeinträchtigt wird.

Ein wichtiger Schritt ist am Ende die Bereinigung der Daten, da die Extraktion manchmal fehlerhafte Ergebnisse liefern kann.

Dieser Extraktionsprozess wird sowohl für das Originalvideo als auch für das zum Austausch verwendete Material durchgeführt.

#2. Training

Das Training ist das Herzstück der Deepfake-Erstellung.

Dabei wird ein neuronales Netz aus Encoder und Decoder mit den extrahierten Daten trainiert, um ein Modell für die spätere Konvertierung zu erstellen.

Der Encoder wandelt die Eingabe in eine Vektordarstellung um, um den Algorithmus zu trainieren. Der Decoder erstellt dann die Gesichter wieder aus den Vektoren.

Das neuronale Netz bewertet seine Ergebnisse und vergleicht sie mit dem Original, wobei ein Verlustwert vergeben wird. Dieser Wert sinkt mit der Zeit, während der Algorithmus iteriert. Das Training wird beendet, wenn die Vorschauen akzeptabel sind.

Das Training ist ein zeitaufwendiger Prozess. Die Ergebnisse verbessern sich in der Regel mit der Anzahl der Iterationen und der Qualität der Eingabedaten.

Faceswap empfiehlt beispielsweise mindestens 500 Bilder sowohl für das Original als auch für das Tauschmaterial. Die Bilder sollten sich deutlich voneinander unterscheiden und verschiedene Winkel unter verschiedenen Lichtverhältnissen abdecken, um die bestmögliche Darstellung zu erzielen.

Da das Training einige Zeit in Anspruch nimmt, ermöglichen es einige Anwendungen wie Faceswap, das Training zu unterbrechen und später fortzusetzen.

Der Fotorealismus des Ergebnisses hängt von der Effizienz des Algorithmus und der Qualität der Eingabedaten ab. Auch die Leistungsfähigkeit der Hardware spielt eine entscheidende Rolle.

#3. Konvertierung

Die Konvertierung ist der letzte Schritt bei der Deepfake-Erstellung. Die Konvertierungsalgorithmen benötigen das Quellvideo, das trainierte Modell und die Ausrichtungsdatei.

Es gibt verschiedene Optionen, die man vor dem Rendern anpassen kann, wie z.B. Farbkorrektur, Maskentyp und das gewünschte Ausgabeformat.

Nach der Konfiguration dieser Optionen muss man nur noch auf das Endergebnis warten.

Faceswap bietet verschiedene Algorithmen. Man kann mit den verschiedenen Optionen experimentieren, um ein zufriedenstellendes Ergebnis zu erzielen.

Ist das alles?

NEIN!

Das war nur das Face-Swapping, eine Teilmenge der Deepfake-Technologie. Face-Swapping ersetzt lediglich einen Teil des Gesichts und gibt nur einen kleinen Einblick in die Möglichkeiten von Deepfakes.

Um einen überzeugenden Austausch zu erzeugen, müssen möglicherweise auch Ton (Stimmklonen) und der gesamte Körper, einschließlich aller Elemente im Bild, nachgebildet werden, wie folgendes Beispiel zeigt:

Was ist also hier geschehen?

Möglicherweise hat der Deepfake-Ersteller das Video selbst aufgenommen (wie in den letzten Sekunden angedeutet), den Dialog mit einer synthetischen Stimme von Morgan Freeman lippensynchronisiert und seinen eigenen Kopf durch den von Morgan Freeman ersetzt.

Deepfakes sind also mehr als nur Face-Swapping. Es geht um das gesamte Bild, einschließlich des Tons.

Auf YouTube gibt es unzählige Deepfakes, so dass man sich fragen kann, wem man überhaupt noch trauen kann. Um mit der Erstellung zu beginnen, benötigt man lediglich einen leistungsstarken Computer mit einer guten Grafikkarte.

Die Perfektion ist jedoch schwer zu erreichen, insbesondere bei Deepfakes.

Für einen überzeugenden Deepfake, der das Publikum täuschen oder unterhalten kann, sind Geschick und einige Tage oder sogar Wochen an Rechenleistung für eine Videosequenz von ein bis zwei Minuten erforderlich.

Die Algorithmen sind heutzutage extrem leistungsfähig. Aber die Frage, welche Entwicklungen die Zukunft bringt und wie effizient diese Anwendungen auf weniger leistungsfähiger Hardware werden, beunruhigt einige Regierungen.

Wir werden uns hier jedoch nicht mit den zukünftigen Auswirkungen befassen, sondern uns ansehen, wie man selbst auf einfache Weise Deepfakes erstellen kann.

(Einfache) Deepfake-Videos erstellen

Es gibt verschiedene Anwendungen, die man verwenden kann, um Deepfakes zu erstellen. Eine davon ist Faceswap.

Bevor wir beginnen, müssen wir einige Punkte beachten. Zunächst benötigen wir ein qualitativ hochwertiges Video des Ziels, das verschiedene Emotionen zeigt. Außerdem benötigen wir ein Quellvideo, mit dem wir das Ziel austauschen möchten.

Schließen Sie alle grafikintensiven Anwendungen, wie Browser oder Spiele, bevor Sie Faceswap starten. Dies ist besonders wichtig, wenn Sie weniger als 2 GB VRAM (Videospeicher) haben.

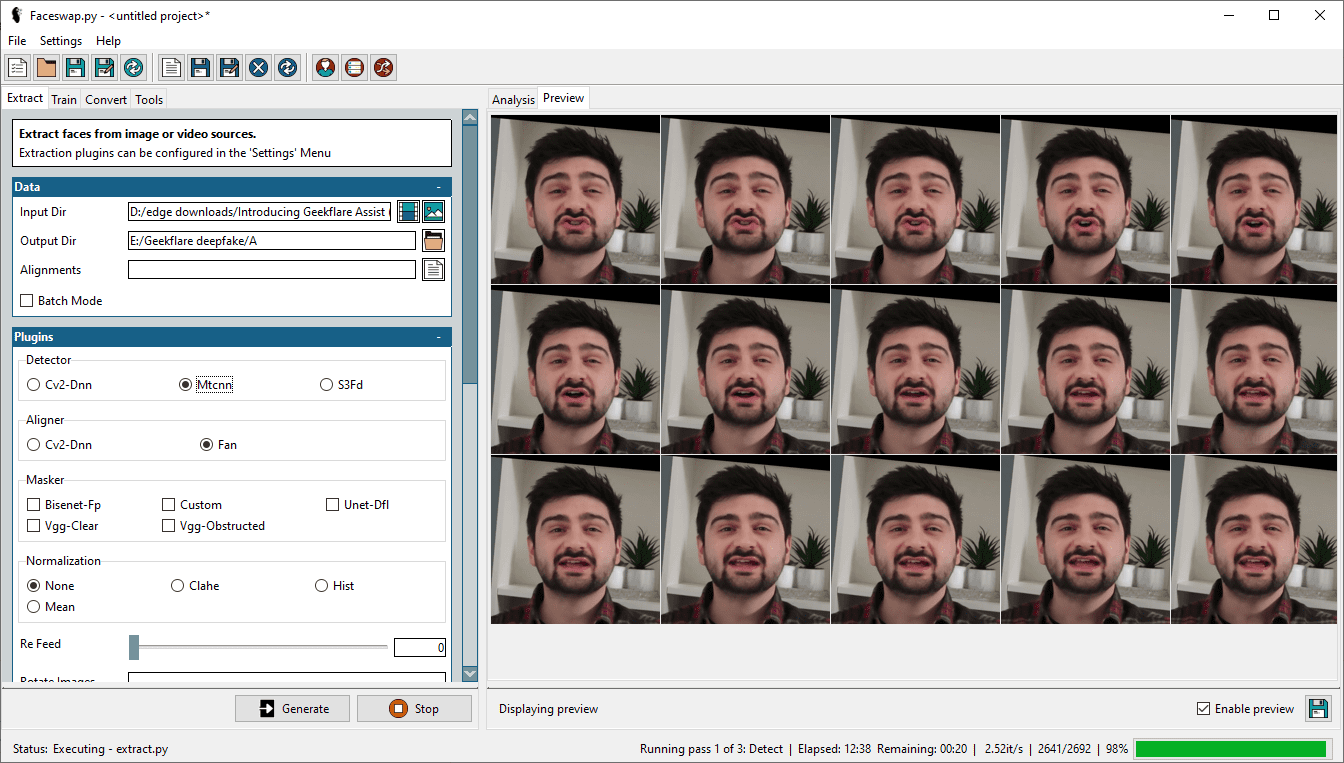

Schritt 1: Gesichter extrahieren

Der erste Schritt ist die Extraktion der Gesichter aus dem Video. Wählen Sie das Zielvideo im Eingabeverzeichnis aus und erstellen Sie ein Ausgabeverzeichnis für die Extraktionen.

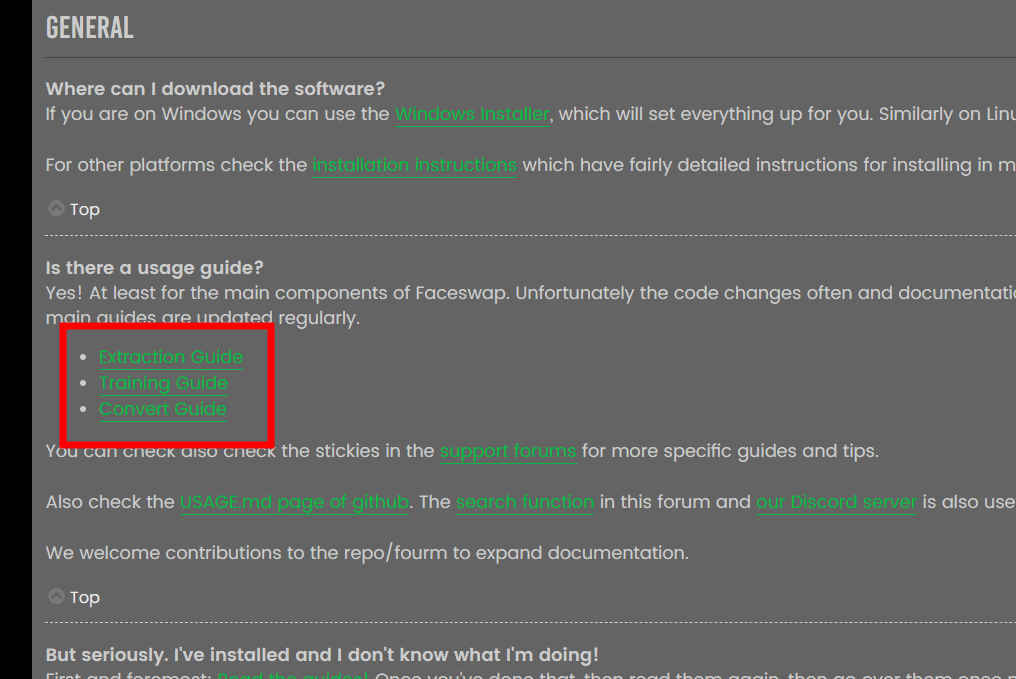

Es gibt verschiedene Optionen, wie Detektor, Aligner, Masker usw. Die Erklärungen zu jeder Option finden Sie in den Faceswap-FAQs.

Quelle: Faceswap-FAQ

Quelle: Faceswap-FAQ

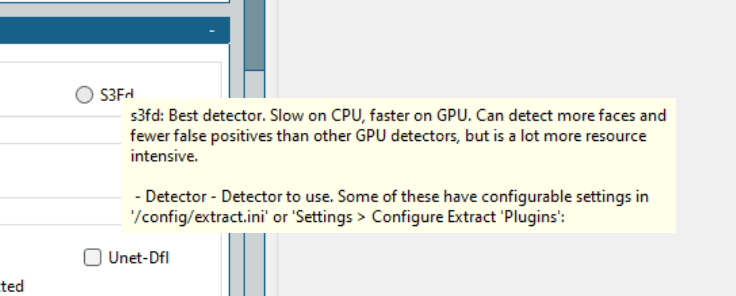

Es ist ratsam, die Dokumentation durchzulesen, um ein besseres Verständnis zu erhalten. Zudem bietet Faceswap hilfreiche Tooltips, die angezeigt werden, wenn man mit der Maus über eine Option fährt.

Es gibt keinen universell gültigen Weg. Man sollte mit den besten Algorithmen beginnen und sich dann nach unten arbeiten, um einen überzeugenden Deepfake zu erstellen.

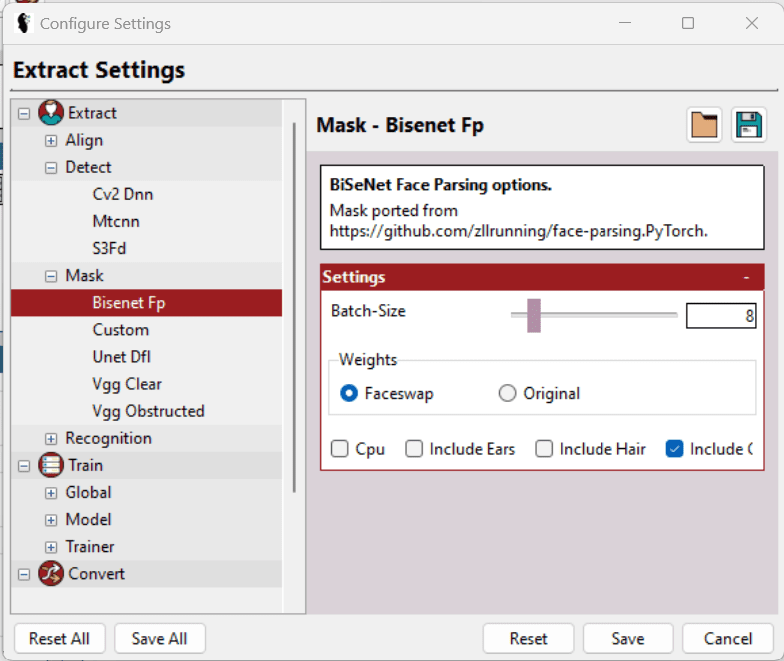

Ich habe Mtcnn (Detektor), Fan (Aligner) und Bisenet-Fp (Masker) verwendet, während alle anderen Optionen unverändert blieben.

Anfangs habe ich es mit S3Fd (bester Detektor) und einigen anderen Masken kombiniert. Meine 2 GB Nvidia GeForce GTX 750Ti konnte der Aufgabe jedoch nicht gewachsen, und der Vorgang schlug immer wieder fehl.

Letztendlich musste ich meine Erwartungen herunterschrauben und die Einstellungen anpassen, um den Vorgang erfolgreich durchzuführen.

Neben der Auswahl des richtigen Detektors und Maskers gibt es im Menü „Einstellungen > Einstellungen konfigurieren“ weitere Optionen, mit denen sich die einzelnen Parameter für eine bessere Unterstützung der Hardware optimieren lassen.

Wählen Sie eine möglichst niedrige Batch-Size, Input Size und Output Size und aktivieren Sie LowMem usw. Diese Optionen sind nicht immer verfügbar und variieren je nach Abschnitt. Die Tooltips helfen bei der Auswahl der optimalen Optionen.

Obwohl die Software Gesichter sehr gut extrahiert, enthalten die Ausgabebilder manchmal mehr, als für das Training (später erläutert) des Modells erforderlich ist. Beispielsweise werden alle Gesichter erfasst (wenn das Video mehrere Gesichter enthält), und es kann zu fehlerhaften Erkennungen kommen, bei denen das Zielgesicht nicht vorhanden ist.

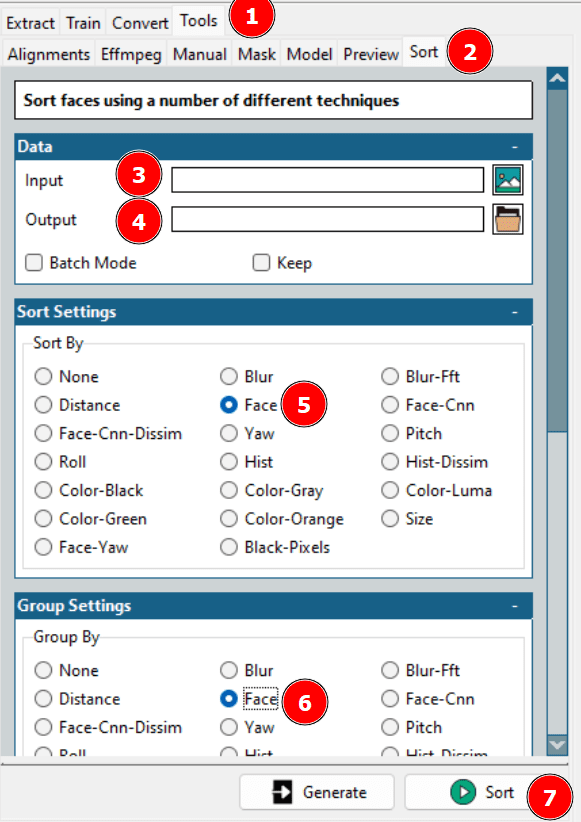

Daher ist es erforderlich, die Datensätze zu bereinigen. Entweder kann man den Ausgabeordner durchgehen und die fehlerhaften Ergebnisse löschen, oder man nutzt die Sortierfunktion von Faceswap.

Mit diesem Tool werden verschiedene Gesichter nacheinander aufgelistet, so dass man die benötigten Gesichter in einem einzigen Ordner zusammenfassen und die restlichen Bilder löschen kann.

Vergessen Sie nicht, dass die Extraktion auch für das Quellvideo wiederholt werden muss.

Schritt 2: Modell trainieren

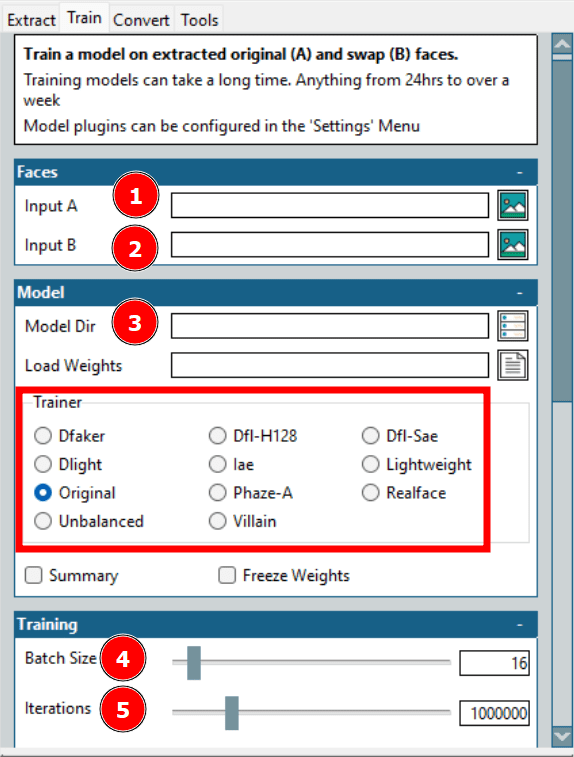

Dies ist der längste Prozess bei der Erstellung eines Deepfakes. „Eingang A“ bezieht sich auf das Zielgesicht, „Eingang B“ auf das Quellgesicht. Das Modellverzeichnis speichert die Trainingsdateien.

Die wichtigste Option hier ist der Trainer. Es gibt viele Trainer mit individuellen Skalierungsoptionen. Dfl-H128- und Lightweight-Trainer mit den niedrigsten Konfigurationseinstellungen haben auf meiner Hardware gut funktioniert.

Die Batch-Size-Option ist ebenfalls wichtig. Eine höhere Batch-Size verkürzt die Trainingszeit, benötigt jedoch mehr VRAM. Die Anzahl der Iterationen hat keinen festen Einfluss auf das Ergebnis. Legen Sie einen ausreichend hohen Wert fest und beenden Sie das Training, sobald die Vorschau akzeptabel ist.

Es gibt noch ein paar weitere Einstellungen, wie das Erstellen eines Zeitraffers mit voreingestellten Intervallen. Ich habe das Modell jedoch nur mit den wichtigsten Einstellungen trainiert.

Schritt 3: Auf Original umstellen

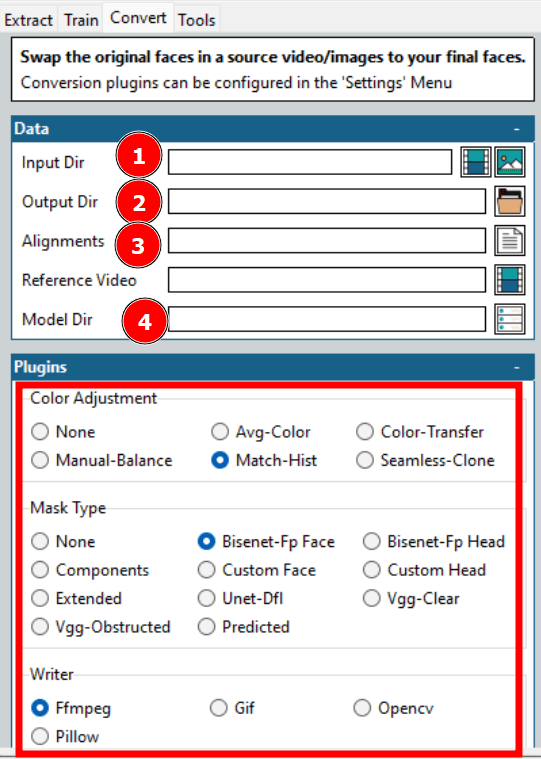

Dies ist der letzte Schritt bei der Erstellung eines Deepfakes.

Dieser Schritt dauert in der Regel nicht so lange, und man kann mit verschiedenen Optionen experimentieren, um schnell das gewünschte Ergebnis zu erzielen.

Wie in der Abbildung oben angegeben, müssen Sie einige Optionen auswählen, bevor Sie die Konvertierung starten.

Die meisten Optionen, wie Eingabe- und Ausgabeverzeichnis, Modellverzeichnis usw., wurden bereits behandelt. Ein wichtiger Aspekt sind die Ausrichtungen, die sich auf die Ausrichtungsdatei (.fsa) des Zielvideos beziehen. Diese Datei wird während der Extraktion im Eingabeverzeichnis erstellt.

Das Feld „Ausrichtungen“ kann leer gelassen werden, wenn diese Datei nicht verschoben wurde. Andernfalls können Sie die Datei auswählen und zu den anderen Optionen übergehen. Beachten Sie, dass Sie die Ausrichtungsdatei bereinigen müssen, wenn Sie die Extraktionen zuvor bereinigt haben.

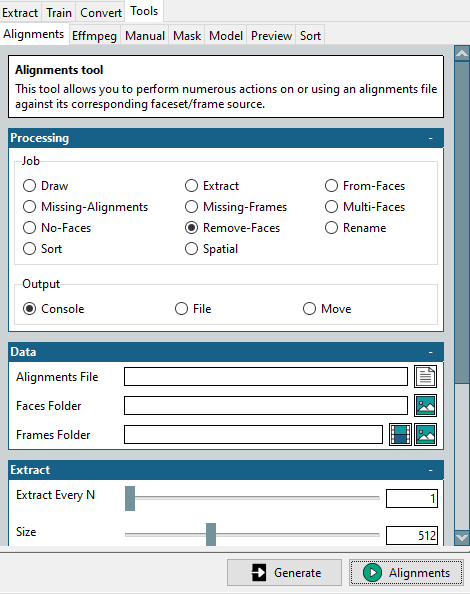

Dazu finden Sie im Menü „Tools > Alignments“ ein Mini-Tool.

Wählen Sie im Bereich „Job“ die Option „Gesichter entfernen“, wählen Sie die ursprüngliche Ausrichtungsdatei und den Ordner „Bereinigte Zielflächen“ aus und klicken Sie unten rechts auf „Alignments“.

Dadurch wird eine modifizierte Ausrichtungsdatei erstellt, die dem optimierten Gesichtsordner entspricht. Denken Sie daran, dass wir dies für das Zielvideo benötigen, in das wir wechseln möchten.

Weitere Konfigurationsmöglichkeiten sind Farbkorrektur und Maskentyp. Die Farbkorrektur bestimmt die Maskenmischung. Sie können einige Optionen ausprobieren, sich das Ergebnis in der Vorschau ansehen und dann die optimale Option auswählen.

Der Maskentyp ist ebenfalls wichtig. Er hängt von Ihren Erwartungen und der verfügbaren Hardware ab. Sie müssen auch die Eigenschaften des Eingangsvideos berücksichtigen. Vgg-Clear funktioniert gut bei frontalen Gesichtern ohne Hindernisse, während Vgg-Obstructed auch mit Hindernissen wie Handgesten, Brillen usw. zurechtkommt.

Die Writer-Optionen bieten eine Auswahl basierend auf dem gewünschten Ausgabeformat. Wählen Sie z.B. Ffmpeg für ein Video-Rendering.

Zusammenfassend lässt sich sagen, dass der Schlüssel zu einem erfolgreichen Deepfake darin liegt, verschiedene Ausgaben in der Vorschau anzusehen und die Einstellungen entsprechend der verfügbaren Zeit und der Hardwareleistung zu optimieren.

Anwendungen von Deepfakes

Es gibt gute, schlechte und gefährliche Anwendungen von Deepfakes.

Zu den guten Anwendungen gehört die Nachbildung von Geschichtsunterricht, um ihn lebendiger und einprägsamer zu gestalten.

Darüber hinaus werden Deepfakes von Online-Lernplattformen verwendet, um Videos aus Texten zu erstellen.

Auch die Filmindustrie wird von dieser Technologie profitieren. Es wird einfacher sein, dem eigentlichen Schauspieler bei Stunts zuzusehen, selbst wenn in Wirklichkeit ein Stuntman sein Leben riskiert. Zudem wird die Erstellung mehrsprachiger Filme einfacher denn je.

Leider gibt es auch viele schlechte Anwendungen. Laut einem Bericht von Deeptrace werden 96% aller Deepfakes in der Pornoindustrie verwendet, um Prominenten-Gesichter auf Pornodarsteller zu setzen.

Darüber hinaus werden Deepfakes auch gegen nicht-prominente Frauen eingesetzt. Oft verwenden Täter Fotos oder Videos, die die Opfer in ihren Social-Media-Profilen veröffentlicht haben.

Eine weitere beängstigende Anwendung ist das Vishing, auch bekannt als Voice-Phishing. Ein CEO eines britischen Unternehmens überwies auf Anweisung des „CEO“ seiner deutschen Muttergesellschaft 243.000 US-Dollar, nur um später festzustellen, dass es sich tatsächlich um einen Deepfake-Anruf handelte.

Noch gefährlicher wird es, wenn Deepfakes dazu verwendet werden, Kriege zu provozieren oder zur Kapitulation aufzufordern. Bei einem kürzlichen Vorfall forderte der ukrainische Präsident Wolodymyr Selenskyj seine Streitkräfte und sein Volk auf, im laufenden Krieg zu kapitulieren. Die Wahrheit wurde dieses Mal durch die schlechte Videoqualität enthüllt.

Zusammenfassend lässt sich sagen, dass es viele Deepfake-Anwendungen gibt und dies erst der Anfang ist.

Das führt uns zu der Millionen-Dollar-Frage…

Sind Deepfakes legal?

Das hängt maßgeblich von der Gesetzgebung des jeweiligen Landes ab. Es gibt noch keine klar definierten Gesetze, die festlegen, was erlaubt ist und was nicht.

Die Legalität von Deepfakes hängt davon ab, wie sie eingesetzt werden. Es ist harmlos, jemanden zu unterhalten oder aufzuklären, solange das Zielobjekt nicht dadurch geschädigt wird.

Bösartige Anwendungen sollten unabhängig von der Rechtsprechung strafbar sein. Eine weitere Grauzone ist die Frage nach Urheberrechtsverletzungen, die ebenfalls berücksichtigt werden muss.

Informieren Sie sich bei den zuständigen Behörden über die rechtliche Lage bezüglich Deepfakes.

Vorsicht ist geboten!

Deepfakes nutzen künstliche Intelligenz, um jeden zu Dingen zu bringen, die er nie gesagt hat.

Der erste Ratschlag sollte lauten: Trauen Sie nichts, was Sie im Internet sehen. Es gibt unzählige Fehlinformationen, und diese werden immer wirksamer.

Da die Erstellung von Deepfakes immer einfacher wird, ist es an der Zeit, dass wir lernen, wie man sie erkennt.