Die Bedeutung der Logdatei-Analyse für die Suchmaschinenoptimierung

Die Analyse von SEO-Protokolldateien ist entscheidend, um das Verhalten von Suchmaschinen-Crawlern auf einer Webseite zu verstehen. Sie ermöglicht es, potenzielle Bereiche für die technische Suchmaschinenoptimierung (SEO) zu identifizieren.

SEO ohne die Untersuchung des Crawler-Verhaltens ist wie ein Flug im Blindflug. Selbst wenn Ihre Seite bei der Google Search Console eingereicht und indexiert wurde, bleiben viele Fragen offen. Ohne die Auswertung von Protokolldateien ist es unmöglich zu beurteilen, ob Suchmaschinen-Bots Ihre Seite korrekt erfassen und lesen.

Aus diesem Grund habe ich eine umfassende Anleitung zusammengestellt, die alles Wissenswerte zur Analyse von SEO-Protokolldateien und zur Identifizierung von Problemen und SEO-Optimierungspotenzialen enthält.

Was ist die Logdatei-Analyse?

Die Analyse von SEO-Protokolldateien ist ein Prozess, bei dem die Interaktionsmuster von Suchmaschinen-Bots mit einer Website aufgedeckt werden. Diese Analyse stellt einen zentralen Bestandteil der technischen SEO dar.

Die Untersuchung von Protokolldateien ist unerlässlich, um Probleme im Zusammenhang mit dem Crawling, der Indizierung und den Statuscodes zu erkennen und zu beheben.

Was sind Protokolldateien?

Protokolldateien dokumentieren, wer eine Webseite besucht und welche Inhalte betrachtet werden. Sie enthalten Informationen über die Anfragenden (auch bekannt als „Clients“).

Diese Informationen können sich auf Suchmaschinen-Bots wie Google oder Bing oder auf normale Website-Besucher beziehen. Typischerweise werden Protokolldateien vom Webserver der Website erfasst und über einen bestimmten Zeitraum aufbewahrt.

Welche Informationen enthalten Protokolldateien?

Bevor wir uns der Bedeutung von Protokolldateien für SEO zuwenden, ist es wichtig zu verstehen, welche Daten diese Dateien beinhalten. Eine Protokolldatei enthält in der Regel:

- Die URL der Seite, die ein Besucher anfordert.

- Den HTTP-Statuscode der Seite.

- Die angefragte Server-IP-Adresse.

- Das Datum und die Uhrzeit des Zugriffs.

- Die Daten des User Agents (des Suchmaschinen-Bots), der die Anfrage stellt.

- Die Anfragemethode (GET/POST).

Protokolldateien mögen auf den ersten Blick komplex erscheinen. Sobald Sie jedoch die Bedeutung und den Zweck von Protokolldateien für SEO verstehen, können Sie sie effektiv nutzen, um wertvolle SEO-Erkenntnisse zu gewinnen.

Zweck der Logdatei-Analyse für SEO

Die Logdatei-Analyse hilft dabei, wichtige technische SEO-Probleme zu lösen und eine effektive SEO-Strategie für die Optimierung Ihrer Webseite zu entwickeln.

Hier sind einige SEO-Probleme, die mit Hilfe von Protokolldateien analysiert werden können:

#1. Häufigkeit des Crawlens durch Googlebot

Suchmaschinen-Bots sollten Ihre wichtigen Seiten regelmäßig crawlen, um die Suchmaschine über Aktualisierungen oder neue Inhalte zu informieren.

Ihre wichtigsten Produkt- oder Informationsseiten sollten in den Google-Protokollen erscheinen. Wenn eine Produktseite für ein nicht mehr verkauftes Produkt oder eine wichtige Kategorieseite nicht vorhanden ist, deutet dies auf ein Problem hin, das durch die Analyse von Protokolldateien erkannt werden kann.

Wie nutzt ein Suchmaschinen-Bot das Crawl-Budget?

Jedes Mal, wenn ein Suchmaschinen-Crawler Ihre Website besucht, hat er ein begrenztes „Crawl-Budget“. Google definiert das Crawl-Budget als die Summe aus der Crawl-Rate und der Crawl-Nachfrage einer Website.

Das Crawlen und Indexieren einer Website kann behindert werden, wenn viele URLs mit geringem Wert vorhanden sind oder URLs in der Sitemap nicht korrekt übermittelt werden. Das Crawlen und Indexieren wichtiger Seiten wird erleichtert, wenn Ihr Crawl-Budget optimiert ist.

Die Logdatei-Analyse hilft bei der Optimierung des Crawl-Budgets, was die SEO-Bemühungen beschleunigt.

#2. Probleme und Status der Mobile-First-Indexierung

Die Mobile-First-Indexierung ist für alle Webseiten wichtig und wird von Google bevorzugt. Die Logdatei-Analyse zeigt Ihnen, wie oft der Smartphone-Googlebot Ihre Seite crawlt.

Diese Analyse hilft Webmastern, Webseiten für mobile Geräte zu optimieren, falls sie vom Smartphone-Googlebot nicht richtig gecrawlt werden.

#3. HTTP-Statuscodes von Webseiten

Die Antwortcodes, die Webseiten zurückgeben, können über Protokolldateien oder über die Option zum Abrufen und Rendern von Anfragen in der Google Search Console ermittelt werden.

Protokolldatei-Analysatoren können Seiten mit 3xx-, 4xx- und 5xx-Codes identifizieren. Diese Probleme können durch geeignete Maßnahmen behoben werden, z. B. durch Umleitung von URLs auf die richtigen Ziele oder durch Ändern des 302-Status in 301.

#4. Analyse von Crawling-Aktivitäten

Google bewertet die Struktur Ihrer Webseite anhand der Crawling-Tiefe und der internen Verlinkung. Eine schlechte interne Verlinkungsstruktur und Crawling-Tiefe können Gründe für ein unsachgemäßes Crawlen der Website sein.

Wenn Sie Probleme mit der Hierarchie, der Seitenstruktur oder der Verlinkungsstruktur Ihrer Webseite haben, können Sie diese mithilfe der Logdatei-Analyse identifizieren.

Die Logdatei-Analyse unterstützt die Optimierung der Webseiten-Architektur und der Verlinkungsstruktur.

#4. Entdeckung verwaister Seiten

Verwaiste Seiten sind Webseiten, die von keiner anderen Seite verlinkt sind. Diese Seiten werden von Bots nur schwer entdeckt und haben somit Schwierigkeiten, in Suchmaschinen zu erscheinen.

Verwaiste Seiten können leicht von Crawlern wie Screaming Frog entdeckt werden. Dieses Problem kann behoben werden, indem die betroffenen Seiten mit anderen Seiten der Webseite verknüpft werden.

#5. Prüfung der Seiten auf Seitengeschwindigkeit und Benutzererfahrung

Page Experience und Core Web Vitals sind mittlerweile offizielle Rankingfaktoren. Webseiten müssen den Google-Richtlinien zur Seitengeschwindigkeit entsprechen.

Langsame oder große Seiten können mit Protokolldatei-Analysatoren identifiziert werden. Diese Seiten können dann für die Seitengeschwindigkeit optimiert werden, was das Gesamtranking in den Suchmaschinenergebnisseiten (SERPs) verbessert.

Die Protokolldatei-Analyse gibt Ihnen die Kontrolle darüber, wie Ihre Webseite gecrawlt wird und wie Suchmaschinen mit Ihrer Webseite interagieren.

Nachdem wir die Grundlagen der Protokolldateien und ihrer Analyse besprochen haben, werfen wir nun einen Blick auf den Prozess der Überprüfung von Protokolldateien für SEO.

So führen Sie eine Protokolldateianalyse durch

Wir haben die verschiedenen Aspekte von Logdateien und deren Bedeutung für SEO beleuchtet. Nun ist es an der Zeit, den Prozess der Dateianalyse und die besten Werkzeuge zur Protokolldateianalyse kennenzulernen.

Sie benötigen Zugriff auf die Server-Protokolldatei der Website, um auf die Protokolldatei zugreifen zu können. Die Dateien können auf folgende Weise analysiert werden:

Für den manuellen Zugriff auf die Protokolldateien sind verschiedene Schritte erforderlich.

- Sammeln oder exportieren Sie die Protokolldaten vom Webserver. Die Daten sollten nach Suchmaschinen-Bots oder Crawlern gefiltert werden.

- Konvertieren Sie die heruntergeladene Datei mithilfe von Datenanalyse-Tools in ein lesbares Format.

- Analysieren Sie die Daten manuell mit Excel oder anderen Visualisierungstools, um SEO-Lücken und -Potenziale zu identifizieren.

- Sie können auch Filterprogramme und Befehlszeilen verwenden, um Ihre Arbeit zu vereinfachen.

Die manuelle Bearbeitung von Dateidaten ist nicht einfach, da Excel-Kenntnisse erforderlich sind und in der Regel das Entwicklungsteam involviert ist. Tools zur Analyse von Logdateien erleichtern SEO-Experten die Arbeit.

Sehen wir uns die wichtigsten Tools zum Auditieren der Protokolldateien an und erfahren Sie, wie diese Tools bei der Analyse helfen.

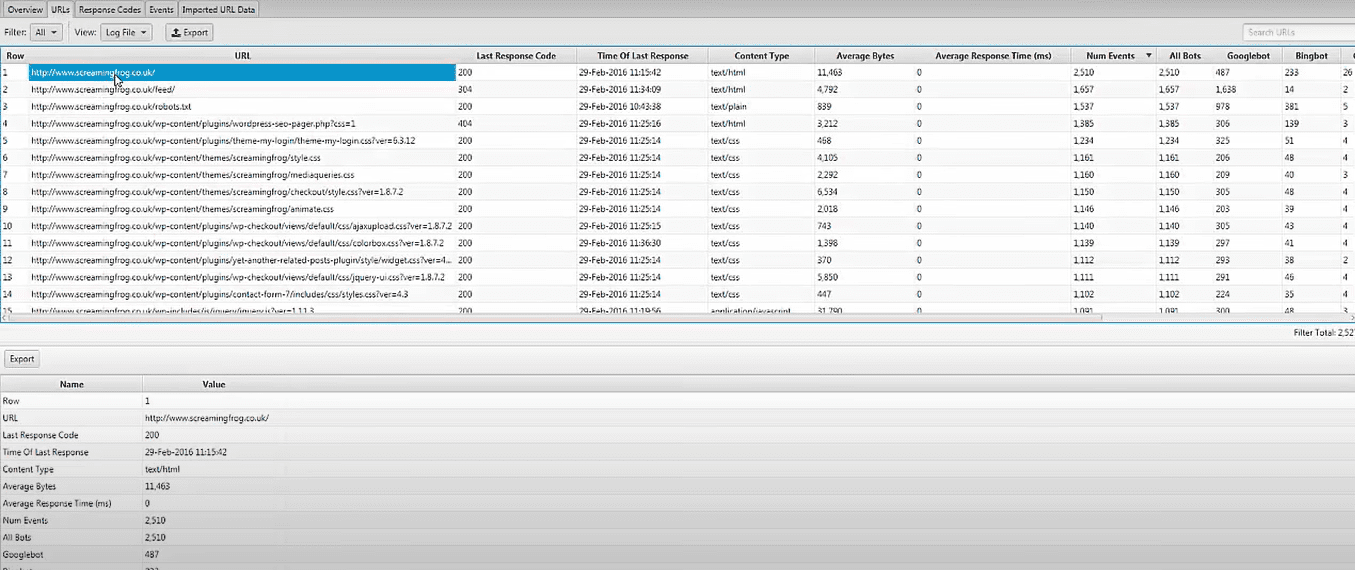

Screaming Frog Log File Analyzer

Technische SEO-Probleme können mithilfe von hochgeladenen Logdatei-Daten und durch die Verifizierung von Suchmaschinen-Bots mit dem Screaming Frog Log File Analyzer identifiziert werden. Das Tool bietet folgende Funktionen:

- Analyse der Suchmaschinen-Bot-Aktivität und Daten für SEO-Zwecke.

- Ermittlung der Website-Crawling-Frequenz durch Suchmaschinen-Bots.

- Identifizierung technischer SEO-Probleme sowie externer und interner defekter Links.

- Analyse der am häufigsten und am wenigsten gecrawlten URLs, um Verluste zu reduzieren und die Effizienz zu steigern.

- Identifizierung von Seiten, die nicht von Suchmaschinen gecrawlt werden.

- Vergleich und Kombination von Daten, einschließlich externer Linkdaten, Richtlinien und anderer Informationen.

- Anzeige von Daten zu Referrer-URLs.

Das Analysetool für Protokolldateien von Screaming Frog ist für einzelne Projekte mit einem Limit von 1000 Zeilenprotokollereignissen kostenlos. Für uneingeschränkten Zugriff und technische Unterstützung ist ein Upgrade auf die kostenpflichtige Version erforderlich.

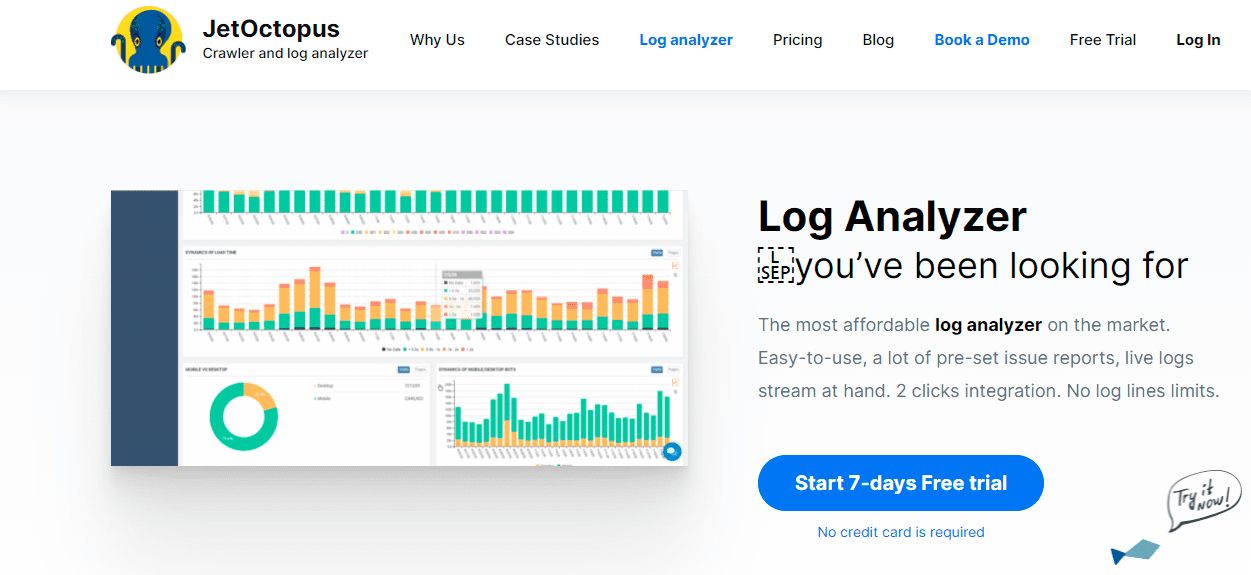

JetOctopus

JetOctopus ist eine empfehlenswerte Wahl für erschwingliche Protokollanalyse-Tools. Es bietet eine siebentägige kostenlose Testversion ohne Kreditkartenpflicht und eine Zwei-Klick-Verbindung. Crawling-Frequenz, Crawling-Budget, beliebteste Seiten und mehr können mit dem JetOctopus-Protokollanalysator identifiziert werden, ähnlich wie bei anderen Tools.

Mit diesem Tool können Sie Logdatei-Daten mit Google Search Console-Daten integrieren, was einen deutlichen Vorteil gegenüber der Konkurrenz bietet. Durch diese Kombination erkennen Sie, wie der Googlebot mit Ihrer Website interagiert und wo Verbesserungen möglich sind.

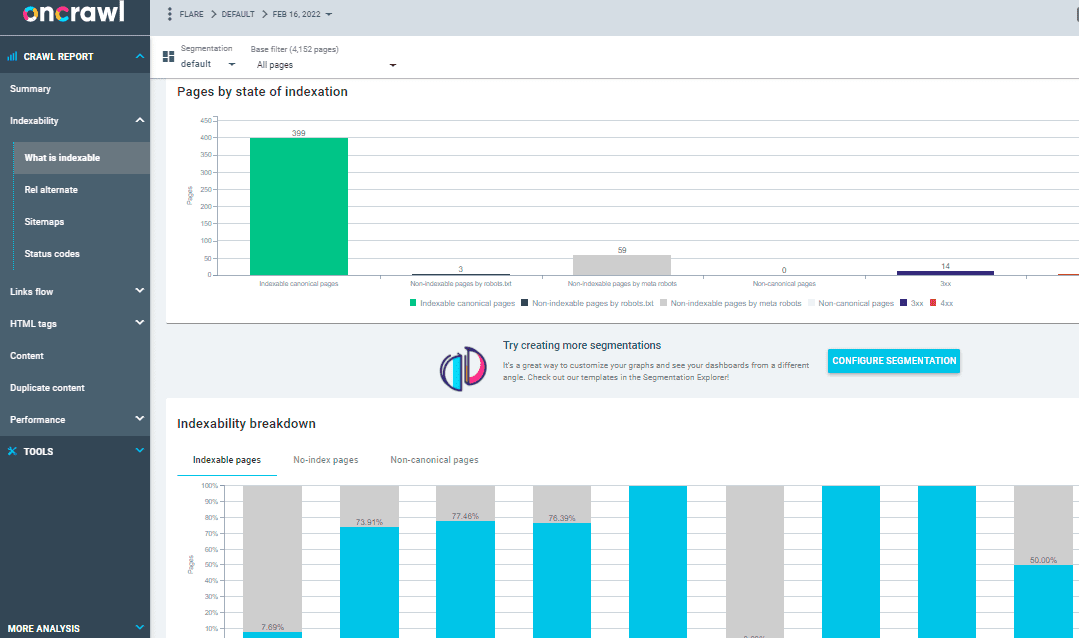

OnCrawl Log Analyzer

Der OnCrawl Log Analyzer verarbeitet täglich über 500 Millionen Protokollzeilen und ist ein Tool für mittlere bis große Webseiten. Es überwacht die Protokolle Ihres Webservers in Echtzeit und stellt sicher, dass Ihre Seiten ordnungsgemäß indiziert und gecrawlt werden.

OnCrawl Log Analyzer ist DSGVO-konform und hochsicher. Anstelle von IP-Adressen speichert das Programm alle Protokolldateien in einer sicheren und separaten FTP-Cloud.

Neben JetOctopus und Screaming Frog Log File Analyzer bietet OnCrawl einige zusätzliche Funktionen, wie:

- Unterstützung vieler Protokollformate wie IIS, Apache und Nginx.

- Das Tool passt sich leicht an Ihre Verarbeitungs- und Speicheranforderungen an, wenn sich diese ändern.

- Dynamische Segmentierung: Ein leistungsstarkes Werkzeug, um Muster und Verbindungen in Ihren Daten zu erkennen, indem Sie Ihre URLs und internen Links nach verschiedenen Kriterien gruppieren.

- Verwendung von Datenpunkten aus Ihren Rohdaten, um umsetzbare SEO-Berichte zu erstellen.

- Protokolldateien, die in Ihren FTP-Bereich übertragen werden, können mit Hilfe von technischen Mitarbeitern automatisiert werden.

- Überwachung aller gängigen Browser, einschließlich Google, Bing, Yandex und Baidu-Crawler.

OnCrawl Log Analyzer hat zwei weitere wichtige Tools:

Oncrawl SEO-Crawler: Mit dem Oncrawl SEO Crawler können Sie Ihre Webseite mit hoher Geschwindigkeit und geringem Ressourcenaufwand durchsuchen. Er verbessert das Verständnis des Benutzers darüber, wie sich Rankingkriterien auf die Suchmaschinenoptimierung auswirken.

Oncrawl-Daten: Oncrawl-Daten analysieren alle SEO-Faktoren, indem sie Daten aus Crawl- und Analysedaten kombinieren. Es ruft Daten aus Crawl- und Protokolldateien ab, um das Crawl-Verhalten zu verstehen, und empfiehlt das Crawl-Budget für vorrangige Inhalte oder Ranking-Seiten.

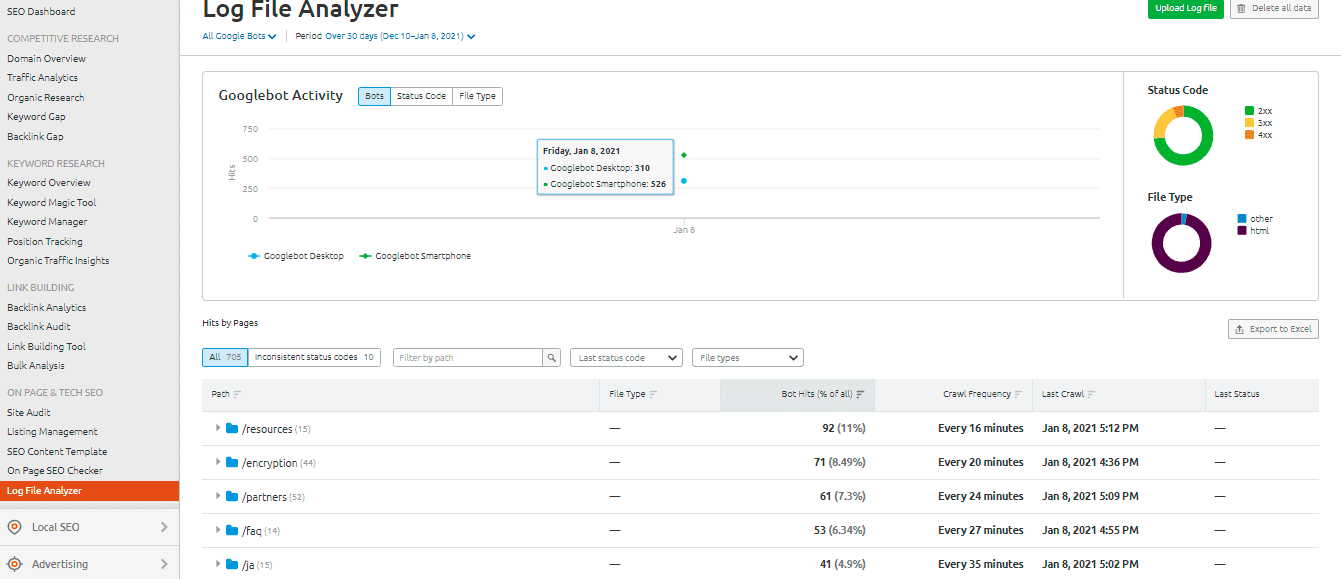

SEMrush Log File Analyzer

Der SEMrush Log File Analyzer ist eine gute Wahl für ein unkompliziertes, browserbasiertes Tool. Dieses Analysetool muss nicht heruntergeladen werden und kann online genutzt werden.

SEMrush bietet Ihnen zwei Berichte:

Seiten-Hits: Dieser Bericht zeigt die Interaktion von Web-Crawlern mit den Inhalten Ihrer Webseite. Er liefert Daten zu Seiten, Ordnern und URLs mit den maximalen und minimalen Bot-Interaktionen.

Die Aktivität des Googlebots: Dieser Bericht bietet tagesaktuelle Einblicke in die Webseite, wie z. B.:

- Die Typen der durchforsteten Dateien.

- Der allgemeine HTTP-Statuscode.

- Die Anzahl der Anfragen, die von verschiedenen Bots an Ihre Webseite gesendet wurden.

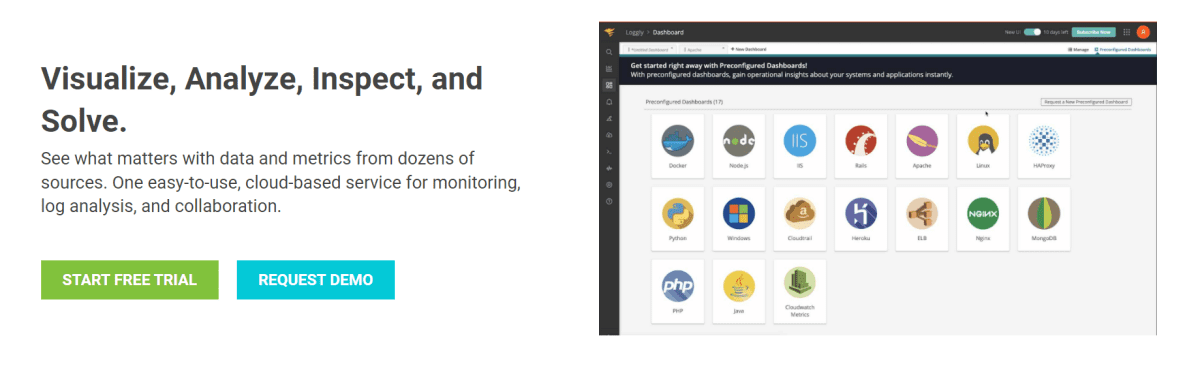

Loggly von SolarWinds

Loggly von SolarWinds untersucht die Zugriffs- und Fehlerprotokolle Ihres Webservers sowie die wöchentlichen Metriken der Website. Sie können Ihre Protokolldaten jederzeit einsehen und es verfügt über Funktionen, die das Durchsuchen von Protokollen vereinfachen.

Ein robustes Protokolldatei-Analyse-Tool wie SolarWinds Loggly ist notwendig, um die Protokolldateien auf Ihrem Webserver effizient nach Informationen über den Erfolg oder Misserfolg von Ressourcenanfragen von Clients zu durchsuchen.

Loggly kann Diagramme mit den am wenigsten besuchten Seiten bereitstellen und die durchschnittliche, minimale und maximale Seitenladegeschwindigkeit berechnen, um Sie bei der Optimierung der Suchmaschinenoptimierung Ihrer Website zu unterstützen.

Crawling-Statistiken der Google Search Console

Die Google Search Console bietet einen hilfreichen Überblick über ihre Praktiken. Die Bedienung der Konsole ist unkompliziert. Ihre Crawling-Statistiken sind in drei Kategorien unterteilt:

- Kilobytes, die pro Tag heruntergeladen werden: Gibt die Kilobytes an, die von Googlebots beim Besuch der Website heruntergeladen werden. Hohe Durchschnittswerte in der Grafik weisen entweder auf häufigeres Crawlen oder auf einen langen Crawl-Vorgang hin.

- Gecrawlte Seiten pro Tag: Gibt die Anzahl der Seiten an, die der Googlebot täglich crawlt. Es wird auch der Status der Crawling-Aktivität aufgezeichnet (niedrig, hoch oder durchschnittlich). Eine niedrige Crawling-Rate deutet darauf hin, dass die Seite nicht richtig vom Googlebot gecrawlt wird.

- Zeitaufwand für das Herunterladen einer Seite (in Millisekunden): Dies gibt die Zeit an, die der Googlebot benötigt, um beim Crawlen der Website HTTP-Anfragen zu stellen. Je weniger Zeit der Googlebot für Anfragen aufwenden muss, desto besser ist das Herunterladen der Seite, da die Indexierung schneller erfolgt.

Fazit

Ich hoffe, Sie konnten viel aus dieser Anleitung zur Analyse von Protokolldateien und zur Verwendung von Tools zur Protokollprüfung für SEO mitnehmen. Die Überprüfung von Protokolldateien ist äußerst effektiv, um die technischen SEO-Aspekte Ihrer Webseite zu optimieren.

Die Google Search Console und der SEMrush Log File Analyzer sind gute Optionen für ein kostenloses und einfaches Analyse-Tool. Alternativ können Sie den Screaming Frog Log File Analyzer, JetOctopus oder Oncrawl Log Analyzer ausprobieren, um ein besseres Verständnis für die Interaktion von Suchmaschinen-Bots mit Ihrer Webseite zu erhalten. Sie können gemischte Premium- und kostenlose Protokolldatei-Analysetools für SEO verwenden.

Sie können sich auch einige fortschrittliche Website-Crawler ansehen, um Ihre SEO-Bemühungen zu verbessern.