Audio-Deepfakes eröffnen eine neue Dimension der Täuschung, in der wir nicht mehr sicher sein können, was wir hören. War es tatsächlich der Präsident, der den Krieg erklärt hat, oder eine raffinierte Fälschung? Fragt wirklich Ihr Vater am Telefon nach seinen Passwörtern? Die Fähigkeit, Stimmen zu manipulieren, wirft existenzielle Fragen auf, die neben nuklearen, chemischen und biologischen Bedrohungen stehen.

Nach den Herausforderungen durch Nanotechnologie und globale Pandemien stehen wir nun vor der Gefahr von Deepfakes, die die Kontrolle über unser eigenes Abbild oder unsere Stimme untergraben.

Was genau ist ein Audio-Deepfake?

Wir sind bereits mit Video-Deepfakes vertraut, bei denen Deep-Learning-Algorithmen verwendet werden, um eine Person durch das Bild einer anderen zu ersetzen. Nun erlebt die Audio-Manipulation ihren Durchbruch. Bei einem Audio-Deepfake wird eine Stimme, die potenziell nicht von der realen Stimme zu unterscheiden ist, synthetisch erzeugt. Es ist quasi „Photoshop“ für Stimmen, wie Zohaib Ahmed, CEO von Resemble AI, es ausdrückt.

Allerdings sind schlechte Photoshop-Bearbeitungen leicht zu erkennen, während Audio-Deepfakes oft schwerer zu entlarven sind. Eine Sicherheitsfirma berichtete, dass Menschen in nur 57% der Fälle korrekt einschätzen, ob ein Audio-Deepfake authentisch oder gefälscht ist. Das ist nicht besser als ein Münzwurf.

Aufgrund der oft minderen Qualität von Sprachaufnahmen, insbesondere bei Telefongesprächen oder Aufnahmen in lauten Umgebungen, können Audio-Deepfakes noch täuschender sein. Je geringer die Klangqualität, desto schwieriger wird es, die verräterischen Zeichen einer gefälschten Stimme zu erkennen.

Warum braucht man „Photoshop“ für Stimmen?

Die Nachfrage nach synthetischem Audio ist enorm, und es gibt einen „sehr unmittelbaren ROI“, wie Ahmed betont. Besonders im Gaming-Bereich eröffnet sich eine neue Welt. Während früher die Stimme die einzige Komponente in einem Spiel war, die nicht on-demand generiert werden konnte, können Studios nun die Stimme eines Schauspielers klonen und Text-to-Speech-Engines verwenden, um Charaktere in Echtzeit sprechen zu lassen.

Auch in traditionelleren Bereichen wie Werbung, technischem Support und Kundenservice ist die Technologie wertvoll. Eine authentisch menschliche Stimme kann personalisierte und kontextbezogene Antworten geben, ohne dass menschliches Eingreifen erforderlich ist. Zudem gibt es medizinische Anwendungen, wie die Stimmwiederherstellung für Menschen mit Sprachverlust, etwa durch ALS. CereProc half dem verstorbenen Filmkritiker Roger Ebert seine Stimme zurückzugewinnen und arbeitet mit der ALS Association zusammen, um synthetische Stimmen für Betroffene zu entwickeln.

Wie funktioniert die Technologie?

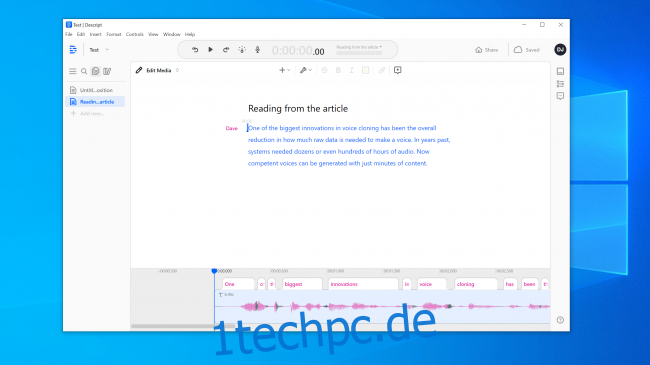

Das Klonen von Stimmen ist im Aufwind, und viele Unternehmen entwickeln entsprechende Tools. Resemble AI und Descript bieten kostenlose Online-Demos an, bei denen man die eigene Stimme aufnehmen und ein Modell erstellen lassen kann. Mithilfe von Deep-Learning-Algorithmen wird aufgezeichnete Sprache mit Text abgeglichen, um die phonetischen Elemente zu verstehen, aus denen die Stimme besteht. So kann die KI Wörter aussprechen, die sie noch nie gehört hat.

Die Basistechnologie existiert schon länger, doch es bedurfte weiterer Forschung. Durch die Fortschritte im Bereich Computer Vision, insbesondere die Entwicklung von Generative Adversarial Networks (GANs), die Vorhersagen basierend auf vorhandenen Daten ermöglichen, konnte sich die Sprachsynthese deutlich verbessern.

Zudem wurde die benötigte Menge an Rohdaten zur Erstellung einer Stimme erheblich reduziert. Benötigte man früher hunderte von Stunden an Audiomaterial, so reichen nun wenige Minuten.

Die Furcht vor dem Ungewissen

Die Technologie ist faszinierend und beängstigend zugleich, wie auch die Atomkraft, Nanotechnologie, 3D-Druck und CRISPR. Es gibt bereits Fälle, in denen Menschen durch Stimmklone getäuscht wurden. 2019 wurde ein Unternehmen in Großbritannien durch einen Audio-Deepfake zu einer Geldüberweisung an Kriminelle verleitet. Auf YouTube finden sich Beispiele von bekannten Persönlichkeiten, die Dinge sagen, die sie nie gesagt haben.

Wir haben die Tools von Resemble AI und Descript selbst getestet. Die Ergebnisse von Descript, das ursprünglich Lyrebird hieß, waren beeindruckend. Die Qualität war verblüffend und es war beunruhigend, die eigene Stimme Dinge sagen zu hören, die man nie gesagt hat. Zwar gab es eine leicht robotische Qualität, jedoch würde dies wahrscheinlich kaum jemandem auffallen. Resemble AI hingegen lieferte keine ganz so überzeugenden Ergebnisse. Dennoch ist es offensichtlich, dass wir die Schwelle überschritten haben, ab der Audio-Deepfakes nur schwer zu erkennen sind. Laut Kundan Kumar von Descript ist dies für einen kleinen Prozentsatz der Fälle bereits Realität.

Mit der Zeit wird die Technologie besser, es werden weniger Audioaufnahmen benötigt und die KI wird immer besser darin, menschenähnliche Nuancen zu erzeugen.

Die Ethik der Technologie

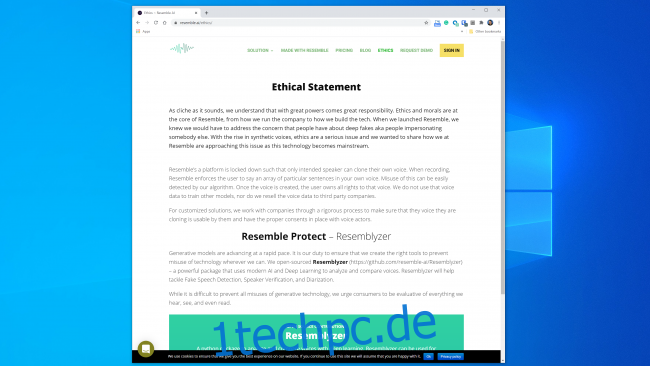

Viele Unternehmen, die in diesem Bereich tätig sind, zeigen Bereitschaft, die Technologie verantwortungsvoll einzusetzen. Resemble AI hat eine Ethik-Sektion auf ihrer Website, in der sie einen strengen Prozess bei der Zusammenarbeit mit Unternehmen versprechen, um sicherzustellen, dass die geklonte Stimme rechtmäßig verwendet wird. Auch Descript erlaubt es nur, die eigene Stimme zu klonen und verlangt, dass Aufnahmen live erfolgen, um nicht einvernehmliches Klonen zu vermeiden. Jedoch sind Open-Source-Tools verfügbar, die keine solchen Einschränkungen haben. Man benötigt keine fortgeschrittenen Programmierkenntnisse, um sie zu missbrauchen.

Sicherheitsexperten sind vorbereitet

Kriminelle haben schon lange vor dem Klonen von Stimmen versucht, über das Telefon Geld zu stehlen. Sicherheitsfirmen wie Pindrop sind darauf spezialisiert, Betrug zu erkennen. Pindrop analysierte 2019 1,2 Milliarden Sprachinteraktionen und verhinderte Betrugsversuche im Wert von rund 470 Millionen US-Dollar. Vor dem Stimmenklonen nutzten Betrüger andere Techniken, wie das Anrufen von anderen Standorten mit persönlichen Daten des Opfers. Die akustische Signatur kann auch verraten, dass ein Anruf beispielsweise von einem Skype-Telefon in Nigeria kommt. Einige Betrüger versuchen, Callcenter-Agenten mit Hintergrundgeräuschen abzulenken, oder verändern die Frequenz ihrer Stimme. Stimmklonen ist jedoch die neueste Entwicklung. Es ist sinnvoll, Zeit in die Erstellung einer synthetischen Stimme zu investieren, wenn die Auszahlung entsprechend hoch ist.

Kann man Audio-Deepfakes erkennen?

Die schlechte Nachricht ist, dass Sprachklone immer besser werden. Die gute Nachricht ist, dass Computer, anders als Menschen, keine Probleme damit haben, Echt von Falsch zu unterscheiden. Auch wenn ein gut konstruiertes Stimmmodell für das menschliche Ohr überzeugend klingt, wie im Fall des von Präsident Obama, der MC Ren auffordert, Stellung zu beziehen. Die Erkennung synthetischer Stimmen wird schwieriger, je kürzer ein Soundclip ist oder je schlechter die Audioqualität ist. Pindrop verwendet Deep-Learning-Systeme, um zu analysieren, ob ein Audiosample der Person entspricht, für die es sich ausgibt. Dabei wird geprüft, ob die Geräusche überhaupt von einem Menschen stammen können.

Jede Sekunde Sprache enthält zwischen 8.000 und 50.000 Datensamples. Einschränkungen der Sprache, die auf menschlicher Evolution basieren, wie der minimale Abstand zwischen zwei Stimmklängen, helfen bei der Identifizierung. Auch die sogenannten Frikative, Laute die entstehen, wenn Luft durch enge Stellen im Rachen strömt, sind schwer für Deep-Learning-Systeme nachzubilden. Somit stolpern Software zum Klonen von Stimmen noch immer über die Tatsache, dass Menschen eben keine Maschinen sind.