Apache Hive präsentiert sich als ein verteiltes und ausfallsicheres Data-Warehouse-System, das die Analyse großer Datenmengen ermöglicht.

Ein Data-Warehouse fungiert als Datenverwaltungssystem, das umfangreiche Mengen historischer Daten aus verschiedenen Quellen bündelt. Ziel ist es, diese Daten für Analysen und Berichte aufzubereiten, was wiederum die Grundlage für Business Intelligence und fundierte Entscheidungen bildet.

Die Daten, die Apache Hive verwendet, werden in Apache Hadoop gespeichert, einem Open-Source-Framework für die verteilte Speicherung und Verarbeitung von Daten. Apache Hive baut auf Apache Hadoop auf und greift daher auf dessen Daten zu. Es ist jedoch auch möglich, andere Speichersysteme wie Apache HBase zu verwenden.

Ein Hauptvorteil von Apache Hive ist, dass es Nutzern erlaubt, große Datensätze zu bearbeiten (lesen, schreiben, verwalten) und die Daten mithilfe der Hive Query Language (HQL), die SQL ähnelt, abzufragen und zu analysieren.

Funktionsweise von Apache Hive

Apache Hive bietet eine SQL-ähnliche, hochsprachliche Schnittstelle zum Abfragen und Verwalten von großen Datenmengen, die im Hadoop Distributed File System (HDFS) gespeichert sind. Wenn ein Benutzer eine Abfrage in Apache Hive startet, wird diese in eine Reihe von MapReduce-Jobs umgewandelt, die auf dem Hadoop-Cluster ausgeführt werden.

MapReduce ist ein Modell zur parallelen Verarbeitung großer Datenmengen, das über verteilte Computercluster hinweg arbeitet. Nach Abschluss der MapReduce-Jobs werden deren Ergebnisse verarbeitet und zu einem Endergebnis zusammengeführt. Dieses Ergebnis kann in einer Hive-Tabelle gespeichert oder zur weiteren Verarbeitung oder Analyse nach HDFS exportiert werden.

Die Geschwindigkeit von Abfragen in Hive kann durch die Verwendung von Partitionen erhöht werden. Dabei werden Hive-Tabellen basierend auf den Tabelleninformationen in verschiedene Teile unterteilt. Diese Partitionen können für eine noch schnellere Abfrage großer Datenmengen weiter unterteilt werden. Dieser Prozess wird als Bucketing bezeichnet.

Apache Hive ist für Organisationen, die mit Big Data arbeiten, unverzichtbar. Es ermöglicht die einfache Verwaltung großer Datensätze, eine schnelle Datenverarbeitung und komplexe Datenanalysen. Dies führt zu detaillierten Berichten, die wiederum eine verbesserte Entscheidungsfindung unterstützen.

Vorteile von Apache Hive

Die Verwendung von Apache Hive bietet eine Reihe von Vorteilen:

Benutzerfreundlichkeit

Die Möglichkeit, Daten mit HQL abzufragen, ähnlich wie bei SQL, macht Apache Hive sowohl für Programmierer als auch für Nicht-Programmierer zugänglich. Dies ermöglicht Datenanalysen an großen Datensätzen ohne das Erlernen einer neuen Sprache oder Syntax. Diese Benutzerfreundlichkeit hat maßgeblich zur Verbreitung und Nutzung von Apache Hive beigetragen.

Geschwindigkeit

Apache Hive ermöglicht eine schnelle Datenanalyse großer Datensätze durch Batch-Verarbeitung. Bei der Batch-Verarbeitung werden große Datenmengen gesammelt und in Gruppen verarbeitet. Die Ergebnisse werden später zu einem Endergebnis kombiniert. Diese Methode ermöglicht eine schnelle Verarbeitung und Analyse von Daten.

Zuverlässigkeit

Hive nutzt das Hadoop Distributed File System (HDFS) zur Datenspeicherung. Durch diese Zusammenarbeit können Daten während der Analyse repliziert werden, was eine fehlertolerante Umgebung schafft, in der Daten selbst bei Fehlfunktionen der Computersysteme nicht verloren gehen. Dies macht Apache Hive besonders zuverlässig und ausfallsicher, was es von anderen Data-Warehouse-Systemen abhebt.

Skalierbarkeit

Apache Hive ist so konzipiert, dass es problemlos wachsende Datenmengen verarbeiten kann. Es bietet somit eine Data-Warehouse-Lösung, die sich den Bedürfnissen der Nutzer anpasst.

Kosteneffizienz

Als Open-Source-Lösung ist Apache Hive im Vergleich zu anderen Data-Warehousing-Lösungen relativ kostengünstig im Betrieb. Das macht es zu einer attraktiven Option für Unternehmen, die ihre Betriebskosten minimieren möchten.

Apache Hive ist eine leistungsstarke und zuverlässige Data-Warehousing-Lösung, die nicht nur skalierbar ist, sondern auch eine schnelle, kostengünstige und benutzerfreundliche Alternative darstellt.

Funktionen von Apache Hive

Zu den Hauptfunktionen von Apache Hive gehören:

#1. Hive-Server 2 (HS2)

Unterstützt Authentifizierung und Multi-Client-Parallelität, konzipiert für eine bessere Unterstützung offener API-Clients wie Java Database Connectivity (JDBC) und Open Database Connectivity (ODBC).

#2. Hive-Metastore-Server (HMS)

Dient als zentraler Speicher für die Metadaten von Hive-Tabellen und Partitionen in einer relationalen Datenbank. Die im HMS gespeicherten Metadaten werden Clients über die Metastore-Service-API zur Verfügung gestellt.

#3. Hive ACID

Stellt sicher, dass alle durchgeführten Transaktionen ACID-konform sind. ACID steht für die vier wünschenswerten Eigenschaften von Datenbanktransaktionen: Atomarität, Konsistenz, Isolation und Dauerhaftigkeit.

#4. Hive-Datenkomprimierung

Reduziert die Größe der gespeicherten und übertragenen Daten ohne Beeinträchtigung der Qualität und Integrität der Daten. Dies geschieht durch Entfernen von Redundanzen, irrelevanter Daten oder durch spezielle Codierung, ohne die Qualität und Integrität der komprimierten Daten zu mindern. Hive unterstützt Datenkomprimierung direkt.

#5. Hive-Replikation

Bietet ein Framework für die Replikation von Hive-Metadaten und Datenänderungen zwischen Clustern für Backup und Datenwiederherstellung.

#6. Sicherheit und Beobachtbarkeit

Kann in Apache Ranger integriert werden, ein Framework zur Überwachung und Verwaltung der Datensicherheit, und in Apache Atlas, mit dem Unternehmen ihre Compliance-Anforderungen erfüllen können. Hive unterstützt auch Kerberos-Authentifizierung, ein Netzwerkprotokoll zur Sicherung der Kommunikation im Netzwerk. Diese Kombination macht Hive sicher und beobachtbar.

#7. Hive LLAP

Verfügt über Low Latency Analytical Processing (LLAP), wodurch Hive sehr schnell wird, indem Daten-Caching optimiert und eine persistente Abfrageinfrastruktur verwendet wird.

#8. Kostenbasierte Optimierung

Nutzt einen kostenbasierten Abfrageoptimierer und einen Abfrageausführungs-Framework von Apache Calcite zur Optimierung seiner SQL-Abfragen. Apache Calcite wird beim Aufbau von Datenbanken und Datenverwaltungssystemen eingesetzt.

Diese Funktionen machen Apache Hive zu einem hervorragenden Data-Warehouse-System.

Anwendungsfälle für Apache Hive

Apache Hive ist eine vielseitige Data-Warehouse- und Datenanalyselösung, die es Benutzern ermöglicht, große Datenmengen einfach zu verarbeiten und zu analysieren. Einige Anwendungsfälle sind:

Datenanalyse

Apache Hive unterstützt die Analyse großer Datensätze mit SQL-ähnlichen Anweisungen. Organisationen können so Muster in den Daten erkennen und sinnvolle Schlüsse ziehen. Dies ist besonders nützlich in der Entwurfsphase. Unternehmen wie AirBnB, FINRA und Vanguard verwenden Apache Hive für Datenanalyse und -abfragen.

Batch-Verarbeitung

Apache Hive ermöglicht die Verarbeitung großer Datensätze in Gruppen durch verteilte Datenverarbeitung. Dies erlaubt eine schnelle Verarbeitung großer Datenmengen. Ein Beispiel hierfür ist das Versicherungs- und Vermögensverwaltungsunternehmen Guardian.

Datenspeicherung

Apache Hive wird auch zur Speicherung und Verwaltung großer Datensätze verwendet. Die gespeicherten Daten können dann analysiert und Berichte generiert werden. Unternehmen wie JPMorgan Chase und Target nutzen Apache Hive als Data-Warehouse-Lösung.

Marketing und Kundenanalyse

Organisationen können Apache Hive nutzen, um ihre Kundendaten zu analysieren, Kundensegmente zu erstellen und ihre Kunden besser zu verstehen. Dies erlaubt es, Marketingmaßnahmen zu optimieren und an die Kundenbedürfnisse anzupassen. Diese Anwendung ist für alle Unternehmen relevant, die mit Kundendaten arbeiten.

ETL-Verarbeitung (Extrahieren, Transformieren, Laden)

Beim Umgang mit großen Datenmengen in einem Data-Warehouse sind Vorgänge wie Datenbereinigung, Extraktion und Transformation notwendig, bevor Daten in das System geladen werden. Apache Hive kann diese Vorgänge ausführen und somit die Datenverarbeitung und -analyse schnell, einfach und fehlerfrei gestalten.

Dies sind die wichtigsten Anwendungsfälle für Apache Hive.

Lernressourcen

Apache Hive ist ein nützliches Werkzeug für das Data-Warehousing und die Datenanalyse. Organisationen und Einzelpersonen, die mit großen Datensätzen arbeiten, können von Apache Hive profitieren. Für weitere Informationen stehen folgende Ressourcen zur Verfügung:

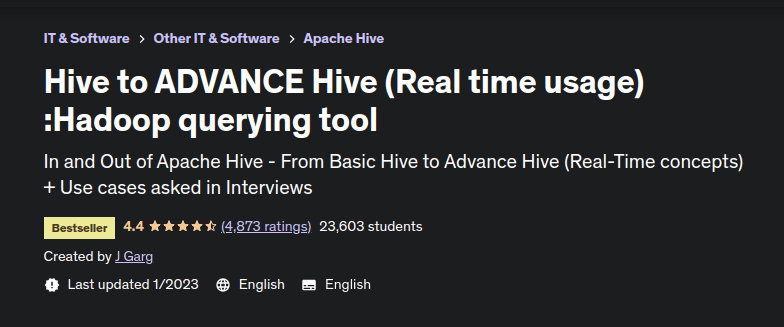

#1. Hive to ADVANCE Hive (Echtzeitnutzung)

Ein Bestseller-Kurs auf Udemy, erstellt von J Garg, einem erfahrenen Big-Data-Berater mit über zehn Jahren Erfahrung in der Arbeit mit Apache-Technologien für Datenanalyse und Schulung. Der Kurs führt von den Grundlagen von Apache Hive bis zu fortgeschrittenen Konzepten und behandelt auch Anwendungsfälle für Vorstellungsgespräche. Lernende erhalten auch Datensätze und Apache Hive-Abfragen zum Üben.

Behandelte Konzepte umfassen erweiterte Funktionen in Hive, Komprimierungstechniken, Konfigurationseinstellungen, das Arbeiten mit mehreren Tabellen und das Laden unstrukturierter Daten.

Der Kurs zeichnet sich durch die detaillierte Behandlung fortgeschrittener Hive-Konzepte aus, die in realen Projekten verwendet werden.

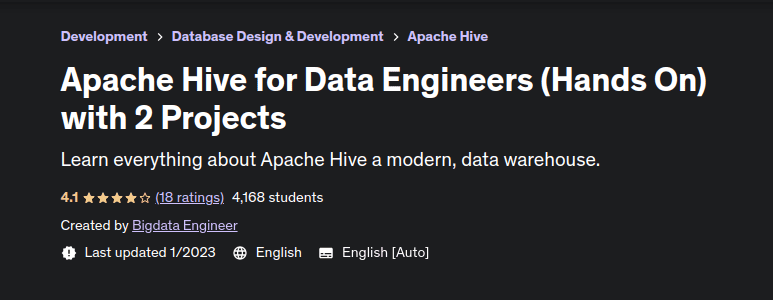

#2. Apache Hive für Dateningenieure

Ein praxisorientierter, projektbasierter Udemy-Kurs für Lernende, die mit Apache Hive arbeiten möchten. Der Kurs beginnt mit einer Einführung in Apache Hive und seiner Bedeutung für Dateningenieure. Er behandelt die Hive-Architektur, die Installation und Konfigurationen. Danach werden Hive-Abfrageabläufe, Funktionen, Einschränkungen und das verwendete Datenmodell behandelt.

Zudem werden Datentypen, Data Definition Language (DDL) und Data Manipulation Language (DML) in Hive behandelt. Die letzten Abschnitte widmen sich fortgeschrittenen Konzepten wie Ansichten, Partitionierung, Bucketing, Joins und integrierten Funktionen. Abschließend werden häufige Fragen und Antworten aus Vorstellungsgesprächen besprochen. Ein ausgezeichneter Kurs, um mehr über Apache Hive und seine Anwendung in der Praxis zu lernen.

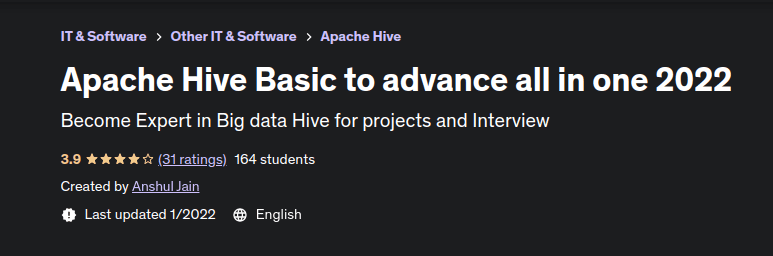

#3. Apache Hive Basic to Advance

Ein Kurs von Anshul Jain, einem erfahrenen Data Engineer im Bereich Big Data. Er präsentiert Apache Hive-Konzepte auf verständliche Weise, ideal für Anfänger. Der Kurs behandelt HQL-Klauseln, Fensterfunktionen, materialisierte Ansichten, CRUD-Operationen in Hive, den Austausch von Partitionen und die Leistungsoptimierung zur schnellen Datenabfrage. Praktische Erfahrungen mit Apache Hive und Vorbereitung auf typische Fragen in Vorstellungsgesprächen.

#4. Apache Hive Essentials

Dieses Buch ist besonders nützlich für Datenanalysten, Entwickler und alle, die Apache Hive lernen möchten. Der Autor verfügt über mehr als zehn Jahre Erfahrung in der Entwicklung und Implementierung von Enterprise-Big-Data-Architekturen und -Analysen.

Das Buch behandelt die Erstellung und Einrichtung einer Hive-Umgebung, die effektive Beschreibung von Daten mit Hive DDL sowie das Kombinieren und Filtern von Datensätzen. Außerdem werden Datentransformationen, wie Sortierung und Funktionen in Hive, sowie die Aggregation und das Sampling von Daten behandelt. Es wird gezeigt, wie die Leistung von Hive-Abfragen gesteigert und die Sicherheit erhöht werden kann. Schließlich geht es um Anpassungen in Apache Hive und die Optimierung für Big-Data-Anforderungen.

#5. Apache Hive Cookbook

Das Apache Hive Cookbook, sowohl als Kindle als auch als Taschenbuch erhältlich, bietet eine leicht verständliche, praktische Einführung in Apache Hive. Es hilft Lesern, Apache Hive und seine Integration in gängige Big-Data-Frameworks zu verstehen. Es richtet sich an Leser mit SQL-Kenntnissen und behandelt die Konfiguration von Apache Hive mit Hadoop, Dienste in Hive, das Hive-Datenmodell sowie Hive DDL und DML.

Erweiterungsfunktionen, Joins, Join-Optimierung, Statistiken, Funktionen, das Hive-Tuning zur Optimierung, sowie Sicherheitsaspekte werden behandelt. Abschließend wird die Integration von Hive mit anderen Frameworks ausführlich besprochen.

Fazit

Apache Hive ist besonders geeignet für traditionelle Data-Warehousing-Aufgaben, jedoch nicht für die Verarbeitung von Online-Transaktionen. Es wurde entwickelt, um Leistung, Skalierbarkeit, Fehlertoleranz und lose Kopplung mit seinen Eingabeformaten zu maximieren.

Unternehmen, die große Datenmengen verarbeiten, können enorm von den Funktionen von Apache Hive profitieren, insbesondere bei der Speicherung und Analyse dieser Daten.

Es ist auch sinnvoll, die Hauptunterschiede zwischen Apache Hive und Apache Impala zu betrachten.