Die Bedeutung von Data Fabric für die digitale Transformation

Die Digitalisierung eines Unternehmens ist erst dann wirklich abgeschlossen, wenn isolierte Geschäftsdaten in einer kohärenten Datenstruktur zusammengeführt werden. Diese Struktur sollte nicht nur die Einhaltung von Risiko-, Governance- und Datenschutzrichtlinien gewährleisten, sondern auch eine effiziente Datenverarbeitung ermöglichen.

Viele Organisationen, die aus unterschiedlichen Teams und Abteilungen bestehen, sammeln und verwalten ihre Daten oft in Silos. Data Governance und Datenschutzbestimmungen erschweren zusätzlich die Zusammenführung verschiedener öffentlicher oder privater Datenquellen.

Wie kann eine wirklich zentralisierte und digitalisierte Datenverarbeitung erreicht werden? Die Antwort liegt in der Data Fabric. Dieser Artikel beleuchtet die Funktionsweise einer Data Fabric und hilft Ihnen, die richtige Entscheidung bei der Auswahl eines entsprechenden Tools zu treffen.

Was ist Data Fabric?

Laut einem Bericht von Gartner gehören Mesh-Datennetzwerke, auch bekannt als Data Fabrics, zu den Top-Technologietrends. Experten in den Bereichen Analytik und Datentechnologie sehen sie als das zukunftsweisende Datenmanagement-Tool für Technologie-Startups, kleine und mittlere Unternehmen sowie Konzerne.

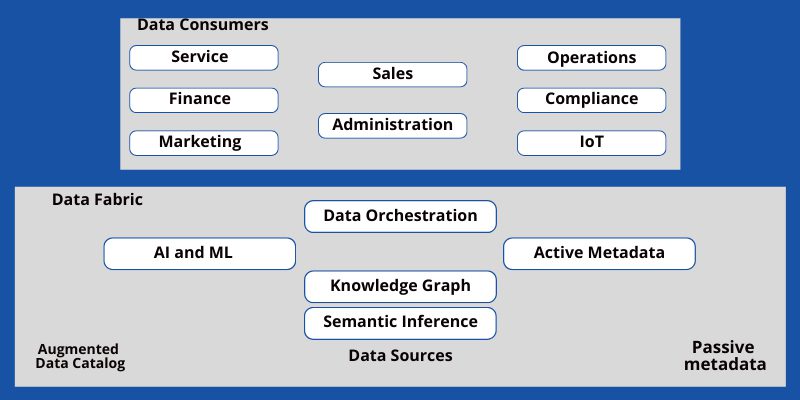

Eine Data Fabric ist eine IT-Umgebung mit einer einheitlichen Architektur, die unterschiedliche Datenquellen mit Geschäftsanwendungen verbindet. Im Hintergrund arbeitet ein leistungsstarker Agent für künstliche Intelligenz (KI), der Daten sicher analysiert und nur die relevanten Informationen an Vertriebsmitarbeiter, Kundenbetreuer oder Führungskräfte weitergibt.

Aus der Vogelperspektive betrachtet, sieht ein Mesh-Datennetzwerk wie ein virtuelles Gewebe aus, in dem verschiedene Datenspeicher- und Rechensysteme miteinander verbunden sind und Informationen austauschen.

Der Zweck von Data Fabric

Hürden wie unterschiedliche Geschäftsanwendungen, Zeitbeschränkungen, Platzmangel, verschiedene Datenspeichermethoden, Datenabrufmethoden und Datensicherheitsprotokolle stellen Engpässe dar, die Unternehmen in ihrer Entwicklung behindern. Diese Kontrollen sind jedoch notwendig, um vertrauliche Daten zu schützen. Sie können also weder abgeschafft noch einfach so belassen werden.

Hier kommt die Data Fabric ins Spiel. Sie dient als Datenautobahn, die Daten aus verschiedenen Standorten, Geschäftsanwendungen, Außenstellen, Ladenfronten, Servern und vielen weiteren Quellen zusammenführt. Diese Daten können strukturiert, halbstrukturiert oder unstrukturiert sein und sind oft mit unterschiedlichen Sicherheitsrichtlinien verbunden.

Der Endbenutzer, wie beispielsweise ein Kunde, ein Vertriebsmitarbeiter oder ein Manager, muss all diese Komplexitäten nicht verstehen. Er benötigt lediglich sicheren Zugriff auf die benötigten Daten, um seine Aufgaben zu erledigen. Data Fabric ermöglicht dies durch Automatisierung, KI und maschinelles Lernen (ML).

Weitere wesentliche Zwecke sind:

- Verbindung mit allen Geschäftsdatenquellen über Container und Konnektoren.

- Bereitstellung von Datenintegrations- und Erfassungsfunktionen innerhalb des Speichers und der Anwendungen.

- Funktion als Hochgeschwindigkeits-Dateninfrastruktur für Big-Data-Analysen.

- Verbindung von Datenkonsumenten und -quellen in einem Mesh-Netzwerk.

- Unterstützung hybrider Datenoperationen zwischen Private Cloud, Public Cloud, Multi-Cloud, On-Premise und Bare-Metal-Workstations.

Oft verbringen Unternehmen mehr Zeit damit, Daten zu diskutieren und zu genehmigen, als sie tatsächlich zu verarbeiten. Mitarbeiter durchlaufen endlose E-Mail-Threads, bevor sie die notwendigen Freigaben für die Datenverarbeitung erhalten. Dies stellt eine ernsthafte Bedrohung für die Produktivität zukunftsorientierter Unternehmen dar. Data Fabric kann diese Probleme lösen:

- Sie bietet eine zentrale Plattform für den Zugriff, die Übermittlung, die Aufbewahrung und die Analyse aller Arten von Daten.

- Obwohl Mitarbeiter bis zu einem bestimmten Grad auf Daten zugreifen können, werden alle Richtlinien zur Datenverwaltung und -regulierung eingehalten.

- Daten werden vertrauenswürdiger und leichter verständlich, da KI-Systeme sie vor der Nutzung durch Menschen verarbeiten.

- Die Kommunikation zwischen Maschinen oder über das Internet der Dinge (IoT) wird ermöglicht, um menschliche Eingriffe in sensible Daten zu minimieren.

- Die Plattform kann sich einfach an die Zunahme und Abnahme von Anwendungen, Kundenanfragen, internen Datenzugriffstickets oder dem plötzlichen Zustrom großer Marketingdaten anpassen.

- Die Anforderungen und Abhängigkeiten von Legacy-Infrastrukturen werden reduziert, wodurch Kosten gespart werden.

- Die Cloud-Technologie wird optimal genutzt, indem alle digitalen Datenquellen an einem sicheren Ort verbunden werden, der durch strenge KI-Algorithmen geschützt ist.

Letztendlich erhalten Mitarbeiter im Kundenservice schneller Zugriff auf die benötigten Daten aus ihren CRMs, was zu einer schnelleren Bearbeitung von Kundenanfragen und damit zu mehr Kundenzufriedenheit führt.

Vorteile von Data Fabric

Stärkung des agilen DevOps-Modells

Agile Software- oder Produktentwicklungsprojekte können durch temporäre Datenverarbeitungsprobleme beeinträchtigt werden. Durch die Einführung einer Data Fabric können Datenausfallzeiten minimiert werden.

Einhaltung der Data Governance

Die zugrunde liegende KI und ML können helfen, Datenschutz- und Governance-Richtlinien durchzusetzen. Die KI verarbeitet die angeforderten Daten und präsentiert sie den Mitarbeitern gemäß den Unternehmensrichtlinien.

Skalierbarkeit

Managed Service Provider (MSPs) können die Datenverarbeitungskapazität bei Bedarf schnell erhöhen oder verringern.

Metadatenverwaltung

Ein Datenkatalog hostet Datenquellen, Assets und Metadaten. Die Anzeige von Metadaten ermöglicht es KI-Systemen, benötigte Daten schneller zu finden.

Fehlererkennung

KI-Systeme können Datenbeschädigungen, Integritätsprobleme und Fehler erkennen, bevor das Unternehmen finanzielle Verluste erleidet.

Rollenbasierter Zugriff

Mitarbeiter können verarbeitete Daten anfordern, die ihrer Sicherheitsfreigabe innerhalb der Organisation entsprechen.

Abschaffung von Datensilos

Datensilos stellen keine Bedrohung mehr dar, wenn Data Fabric alle Daten in einer verschlüsselten Datenautobahn zusammenführt. Teams können auf legitime Daten aus jeder Abteilung zugreifen, ohne Umwege.

Datenintegration

Data Fabric und die zugrunde liegende KI ermöglichen eine sofortige Datenintegration mit Echtzeit-Software wie CRMs, ERPs, Kunden-Apps und Apps für Mitarbeiter im Kundenservice.

Hochwertige Daten

Intelligente Algorithmen einer Data Fabric analysieren kontinuierlich alle Datenquellen. Mitarbeiter können auf Eingabedaten vertrauen, ohne dass eine Validierung durch Vorgesetzte erforderlich ist.

Die Architektur von Data Fabric

Data Fabrics müssen einen verbesserten Datenzugriff gewährleisten, ohne die Datenqualität und -sicherheit zu beeinträchtigen. Eine typische Data-Fabric-Architektur umfasst daher die folgenden Komponenten:

Datenkatalog

Ein Datenkatalog ist eine strukturierte Form aller Geschäftsdaten. Benutzer können auf solche Kataloge zugreifen, um die für ihre Aufgaben benötigten Informationen zu finden. Der Datenkatalog besteht aus Metadaten und einem Knowledge Graph.

KI- und ML-basierte Automatisierung

Im Zentrum einer Data Fabric sollte ein KI-System stehen, das Abfragen auflöst, die Datenqualität kontrolliert, Sicherheitsprüfungen durchführt und vieles mehr.

Datenintegration und -transport

Data Fabrics integrieren Daten aus allen Quellen, z. B. Servern vor Ort, Cloud-Speichern und Mitarbeiter-Laptops. Es sollten Datenkonnektoren vorhanden sein, um Informationen mit einem entfernten Computer oder Transporter zu verbinden und die Daten durch die Data Fabric zu bewegen.

So implementieren Sie Data Fabric

Die Art und Weise, wie eine Data Fabric implementiert wird, hängt stark von den individuellen Bedürfnissen und Anforderungen des jeweiligen Unternehmens ab. Es gibt keine Standardlösung für die Implementierung, aber einige gemeinsame Merkmale und Ebenen der Architektur:

Datenverwaltung: Diese Ebene dient der Datensicherheit und Governance.

Datenaufnahme: Hier werden alle Cloud-Daten zusammengeführt und die Verbindungen zwischen strukturierten und unstrukturierten Daten lokalisiert.

Datenverarbeitung: Es wird sichergestellt, dass relevante Daten während der Datenextraktion verfügbar sind.

Datenanordnung: Diese Ebene umfasst die Ausführung von Aufgaben wie die Erfassung isolierter Daten, Datenstrukturierung, Datenbereinigung, Integration und Transformation, um nutzbare Daten zu erstellen.

Datenerkennung: Durch die Integration verschiedener Quellen können Daten gesammelt werden, die entscheidend für die Kundenzufriedenheit sind.

Datenzugriff: Diese Ebene ist dem Datenverbrauch gewidmet und unterstützt den Zugriff auf relevante Daten über Datenvisualisierungstools oder Anwendungs-Dashboards.

Data-Fabric-Prinzipien

Das Ziel von Mesh-Datennetzwerken ist die Vereinheitlichung verteilter und vielfältiger Datenbestände von Unternehmen in allen Branchen. Darüber hinaus werden End-to-End-Datenverwaltungsprozesse als einheitliche Datenverwaltungsplattform zusammengeführt.

Data Fabric erreicht dies durch folgende Datenverwaltungsprinzipien:

- Datenentdeckung

- Datenpflege

- Datenorganisation

- Datenmodellierung

- Qualitätsprüfungen

- Isolierte Datenorchestrierung

- Datenintegration

- Datenverwaltung

Data-Fabric-Funktionen

Kontinuierliche Auflösung von Datenabfragen

Data Fabrics sind auf Hochgeschwindigkeitsinternet, Solid-State-Laufwerke und Supercomputer angewiesen, um angeforderte Daten ohne Ausfallzeiten abrufen zu können.

Endlose Datenintegration, -erkennung und -katalogisierung

Die primäre KI, die für das Datenmanagement innerhalb der Data Fabric verantwortlich ist, muss kontinuierlich arbeiten, um neue Rohdaten zu akzeptieren, zu analysieren, zu katalogisieren und in Geschäftsanwendungen zu integrieren.

Passive und aktive Metadaten

Aktive Metadaten sind Informationen wie Datenqualität, Datennutzung und aktueller Bearbeiter. Passive Metadaten sind statische Daten, die vom Autor festgelegt werden. Die KI einer Data Fabric ändert diese ständig, um den Aufwand für die manuelle Datenexploration oder -vorbereitung zu reduzieren.

Flexibilität

Die Data Fabric ist hochflexibel und akzeptiert Änderungen, wann immer sie von Ihrem Unternehmen benötigt werden.

Die Implementierung einer Data Fabric ist mit intelligenter Software unkompliziert. Einige der bekanntesten Anbieter für kleine und mittlere Unternehmen sind:

Atlan

Atlan ist eine leistungsstarke, aber benutzerfreundliche aktive Metadatenplattform und ein Datenarbeitsbereich, mit dem Sie einfach auf Daten aus jeder Quelle zugreifen können. Sie fungiert als moderner Datenkatalog für Ihre Data-Fabric-Anforderungen. Die Plattform bietet Lösungen für alles rund um Daten, einschließlich Katalogisierung, Profilerstellung, Erkennung, Qualitätssicherung, Governance, Exploration und Integration.

Die Benutzeroberfläche erinnert an die Google-Suche, und ein umfangreiches Unternehmensglossar hilft Ihnen, Ihre Daten besser zu verstehen. Unternehmen können über Funktionen wie granulare Governance und Zugriffskontrollen die Datennutzung innerhalb eines Ökosystems verwalten.

Atlan unterstützt die Integration mit Anwendungen wie Big Query, Amazon Redshift, Snowflake, MYSQL, Looker und Tableau.

K2View

Wenn Sie eine Plattform mit umfassender Data-Fabric-Funktionalität suchen, ist K2View eine gute Wahl. Diese Datenproduktanwendung unterstützt Sie in allen Phasen des Mesh-Datennetzwerks, einschließlich Datenintegration, -vorbereitung, -orchestrierung und -pipelining.

Mit K2View können Unternehmen anspruchsvollste Data-Fabric-Architekturen in Cloud-, On-Premise- und Hybridumgebungen realisieren. Die Verwaltung von Daten durch Menschen wird reduziert, da die Bereitstellung von Data Fabrics einfacher wird. Die Anwendung kann Daten aus mehreren Quellen vereinheitlichen und sie an Systeme mit hohen Anforderungen an die Datenintegrität weiterleiten.

Mit K2View können Sie sofort Data Lakes und Data Warehouses erstellen, die Sie sofort analysieren können. Selbst ohne Programmierkenntnisse können Sie die Bewegung und Transformation von Daten von der Quelle zum Ziel steuern.

Unternehmen können konfigurierbare Regeln verwenden, um den Datenzugriff, die Synchronisierung und die Sicherheit zu kontrollieren. Darüber hinaus ist die Plattform für die Datendienstautomatisierung mit einem benutzerfreundlichen Framework geeignet.

Talend

Talend ist eine Data-Fabric-Plattform, die einen reibungslosen Datenzugriff gewährleistet und Ihnen hilft, den Geschäftswert zu steigern. Jedes Unternehmen muss kompromisslose Daten verwalten und deren Benutzerfreundlichkeit, Integrität, Verfügbarkeit und Sicherheit gewährleisten. Mit dieser Anwendung können Unternehmen ihre Daten in gutem Zustand halten und Risiken minimieren.

Talend ist eine einheitliche Plattform für zuverlässige und zugängliche Daten, die Governance, Integration und Integrität bietet. Mit Hilfe von Serviceinfrastrukturen und Partnerökosystemen stellt Talend qualitativ hochwertige Daten bereit. Hier können Sie die benötigten Daten durch Dokumentation und Kategorisierung ermitteln.

Da die Daten automatisch in Echtzeit bereinigt werden, besteht keine Gefahr, dass fehlerhafte Daten in Ihr System gelangen. Mit diesem Tool können Unternehmen ihre Produktivität steigern und Geld sparen, während gleichzeitig die Einhaltung gesetzlicher Vorschriften und die Risikominderung gewährleistet werden.

Mit der Anwendungs- und API-Integration können Sie Ihren Kunden bessere Erfahrungen bieten. Diese stellen auch Self-Service-Funktionen für den internen und externen Austausch von vertrauenswürdigen Daten sicher.

Incorta

Incorta ist eine Self-Service-Datenanalyseplattform, mit der Unternehmen ihre Daten voll ausschöpfen können, um Erkenntnisse zu geringeren Kosten zu gewinnen. Die Lösung bietet eine agile Datenerfahrung, die es Ihnen ermöglicht, rechtzeitige und fundierte Entscheidungen zu treffen.

Die Plattform verwendet In-Memory-Analysen und Direct Data Mapping-Funktionen, um eine hohe Geschwindigkeit und Skalierbarkeit für die Datenspeicherung und -verwaltung zu bieten. Selbst wenn Sie Ihre Daten aus mehreren Ressourcen analysieren möchten, kann Incorta eine echte geschäftliche Agilität für ein flexibles Daten-Pipelining sicherstellen.

Darüber hinaus hilft die Plattform bei der Datenerfassung, -verarbeitung, -analyse und -präsentation von Geschäftsanwendungsdaten. Mit der nativen Visualisierungsfunktion können Geschäftsdaten authentisch präsentiert werden.

Fazit

Data Fabric ist die Architektur der nächsten Generation für Datenspeicherung, -verarbeitung, -aufbewahrung und -verwaltung. Viele digitale Unternehmen nutzen bereits Data-Fabric-Tools, um ihre Mitarbeiter auf die Zukunft vorzubereiten.

Besonders kleine Unternehmen, mittlere Unternehmen und Start-ups können von dieser Technologie profitieren, da sie sich Verzögerungen im Arbeitsablauf aufgrund von Genehmigungen und Prüfungen nicht leisten können. Informieren Sie sich über die Angebote und den Mehrwert der oben genannten Tools für Ihr Unternehmen.

Ihr RevOps-Geschäftsmodell kann stark von Data Fabric profitieren. Erfahren Sie hier mehr über Revenue Operations (RevOps)-Tools.